深圳国资投了!红杉押注的AI生命科学企业津渡生科完成千万级Pre-A+轮融资

深圳国资投了!红杉押注的AI生命科学企业津渡生科完成千万级Pre-A+轮融资近日,AI生命科学企业津渡生科宣布完成千万级Pre-A+轮融资,由深圳南山区战略直投平台南山战新投投资。值得注意的是,仅2025年该公司就连续获得了红杉中国种子基金、创东方投资分别领投天使+轮、Pre-A轮,加上本轮融资已完成累计近亿元人民币。

近日,AI生命科学企业津渡生科宣布完成千万级Pre-A+轮融资,由深圳南山区战略直投平台南山战新投投资。值得注意的是,仅2025年该公司就连续获得了红杉中国种子基金、创东方投资分别领投天使+轮、Pre-A轮,加上本轮融资已完成累计近亿元人民币。

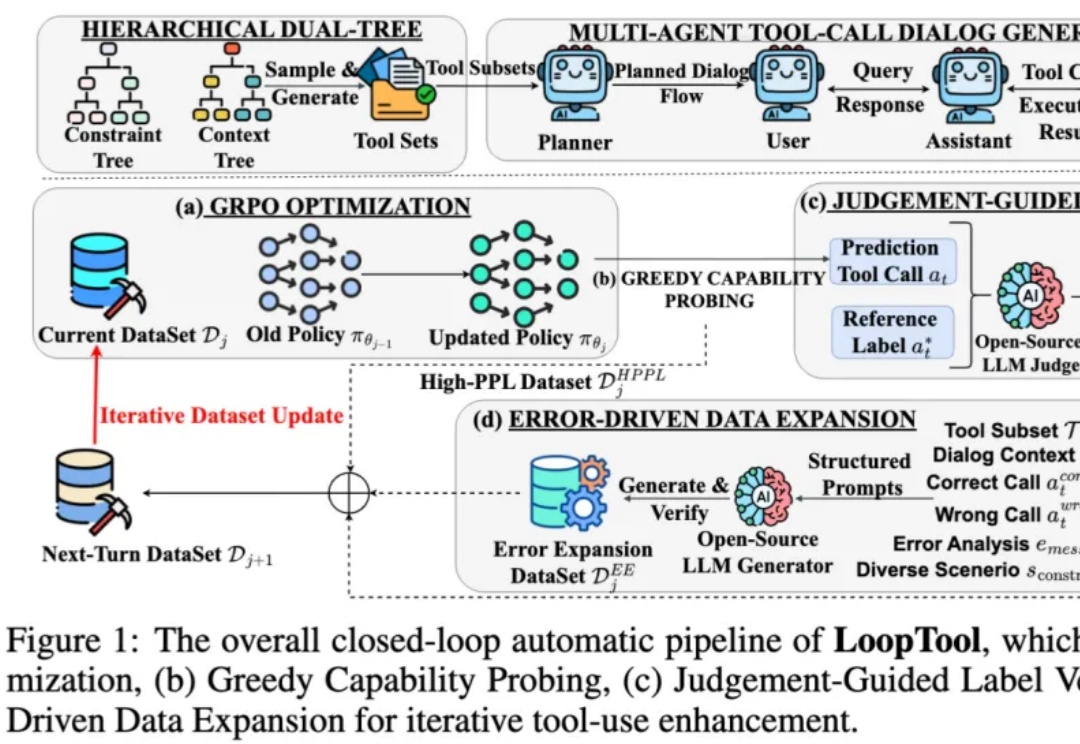

在过去两年,大语言模型 (LLM) + 外部工具的能力,已成为推动 AI 从 “会说” 走向 “会做” 的关键机制 —— 尤其在 API 调用、多轮任务规划、知识检索、代码执行等场景中,大模型要想精准调用工具,不仅要求模型本身具备推理能力,还需要借助海量高质量、针对性强的函数调用训练数据。

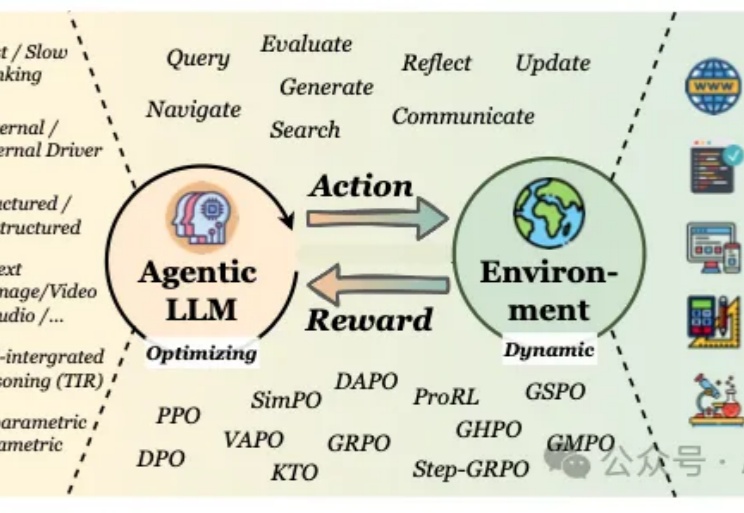

当我们谈论大型语言模型(LLM)的"强化学习"(RL)时,我们在谈论什么?从去年至今,RL可以说是当前AI领域最炙手可热的词汇。

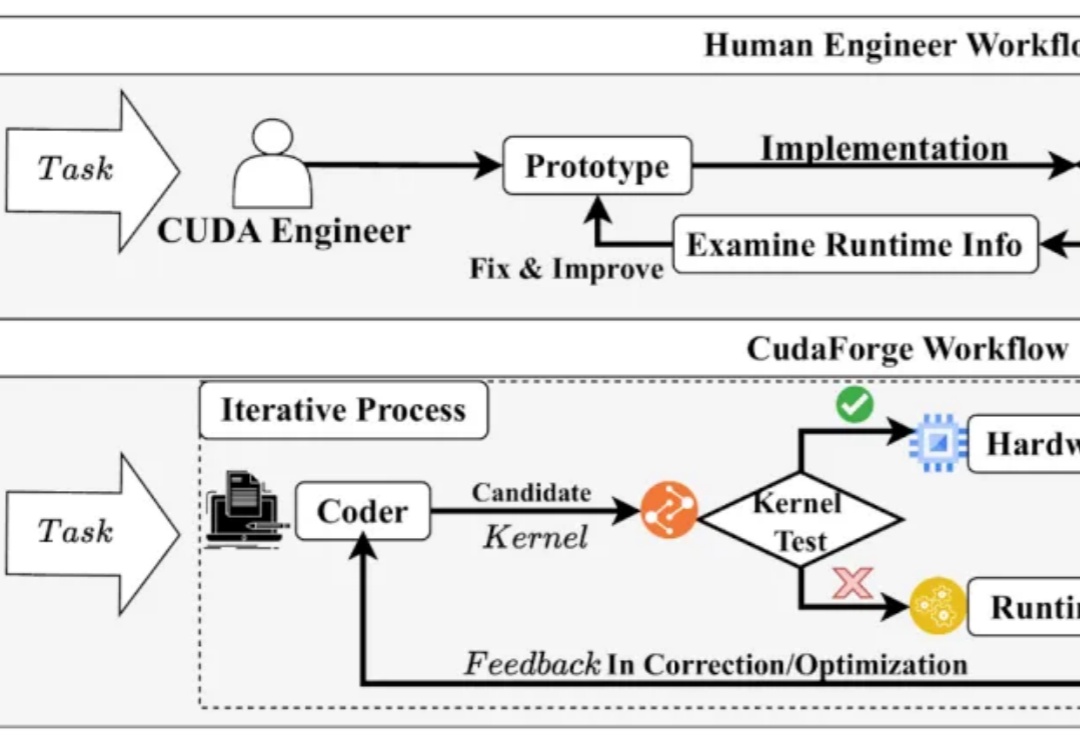

CUDA 代码的性能对于当今的模型训练与推理至关重要,然而手动编写优化 CUDA Kernel 需要很高的知识门槛和时间成本。与此同时,近年来 LLM 在 Code 领域获得了诸多成功。

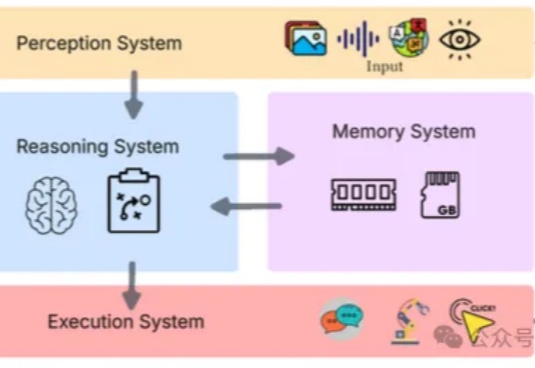

如何构建一个真正意义上的“自主代理”(Agent),而不是一个“带LLM的高级工作流”? 让钢铁侠中的“贾维斯”(J.A.R.V.I.S.)真正来到现实,不仅能对话,还能调动资源、控制机械、在复杂战局中自主执行多步任务。

图灵奖得主LeCun与Meta分道扬镳!LLM邪路一条,「世界模型才是」未来。

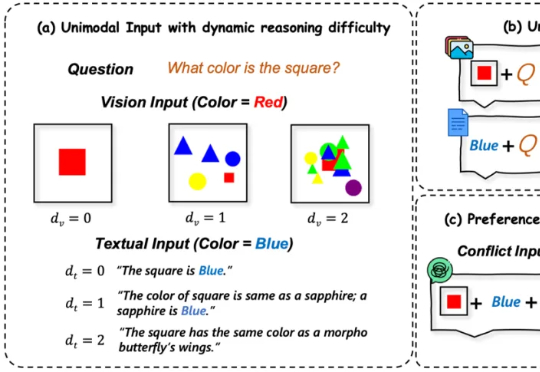

多模态大语言模型(MLLMs)在处理来自图像和文本等多种来源的信息时能力强大 。 然而,一个关键挑战随之而来:当这些模态呈现相互冲突的信息时(例如,图像显示一辆蓝色汽车,而文本描述它为红色),MLLM必须解决这种冲突 。模型最终输出与某一模态信息保持一致的行为,称之为“模态跟随”(modality following)

谷歌在第三天发布了《上下文工程:会话与记忆》(Context Engineering: Sessions & Memory) 白皮书。文中开篇指出,LLM模型本身是无状态的 (stateless)。如果要构建有状态的(stateful)和个性化的 AI,关键在于上下文工程。

多模态大语言模型(MLLM)在目标定位精度上被长期诟病,难以匹敌传统的基于坐标回归的检测器。近日,来自 IDEA 研究院的团队通过仅有 3B 参数的通用视觉感知模型 Rex-Omni,打破了这一僵局。

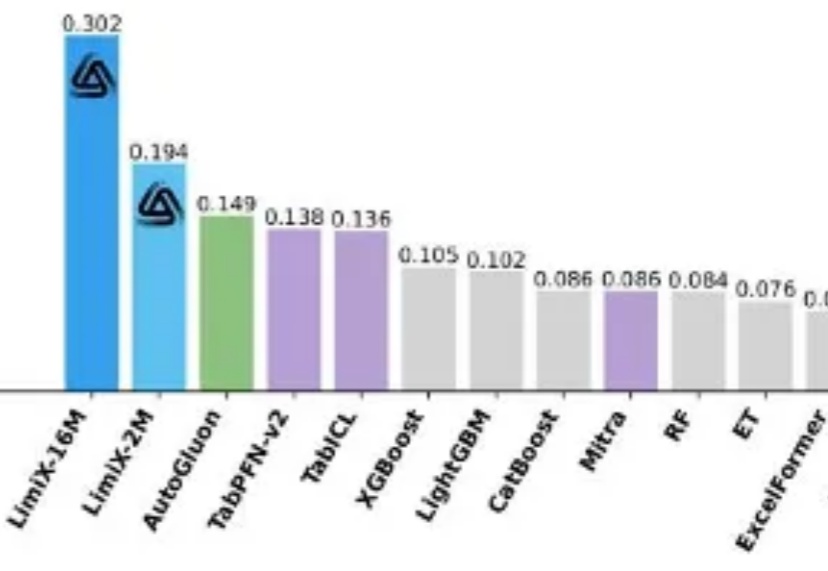

提到 AI 的突破,人们首先想到的往往是大语言模型(LLM):写代码、生成文本、甚至推理多模态内容,几乎重塑了通用智能的边界。但在一个看似 “简单” 的领域 —— 结构化表格数据上,这些强大的模型却频频失手。