最近很火的Hindsight,基于图谱的「Agent记忆栈」解耦事实与信念

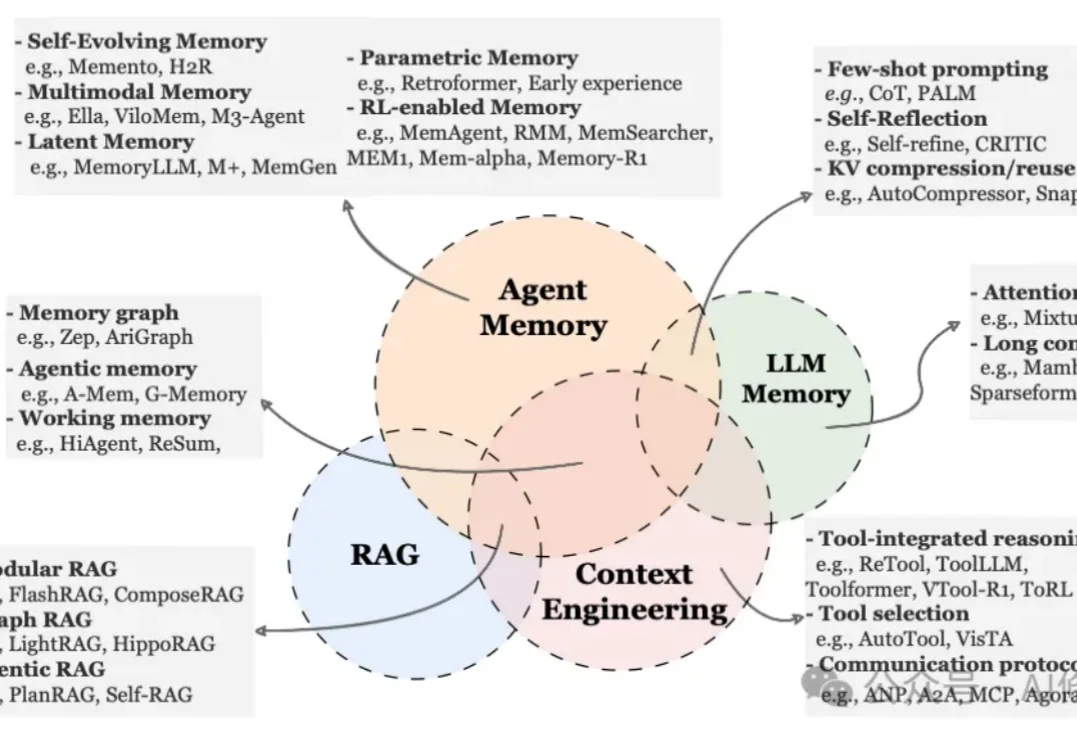

最近很火的Hindsight,基于图谱的「Agent记忆栈」解耦事实与信念在上一篇文章中,我们系统梳理了AI Agent 记忆机制的全景综述AI Agent最新「Memory」综述 |多所顶尖机构联合发布。今天我将带您了解一项最近很火的Agent记忆项目「HINDSIGHT」

在上一篇文章中,我们系统梳理了AI Agent 记忆机制的全景综述AI Agent最新「Memory」综述 |多所顶尖机构联合发布。今天我将带您了解一项最近很火的Agent记忆项目「HINDSIGHT」

就在昨天,新加坡国立大学、中国人民大学、复旦大学等多所顶尖机构联合发布了一篇AI Agent 记忆(Memory)综述。

国内记忆框架首开源,企业实战已上线运行。在海外巨头已经将“记忆系统”提升到基础设施层的同时,红熊AI便是其中之一。公司成立于2024年,围绕多模态大模型与记忆科学开展研发,并将这些能力用于为企业提供智能客服、营销自动化与AI智能体服务。

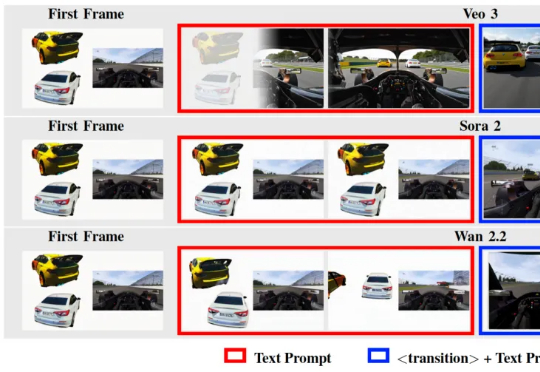

在 Text-to-Video / Image-to-Video 技术突飞猛进的今天,我们已经习惯了这样一个常识: 视频生成的第一帧(First Frame)只是时间轴的起点,是后续动画的起始画面。

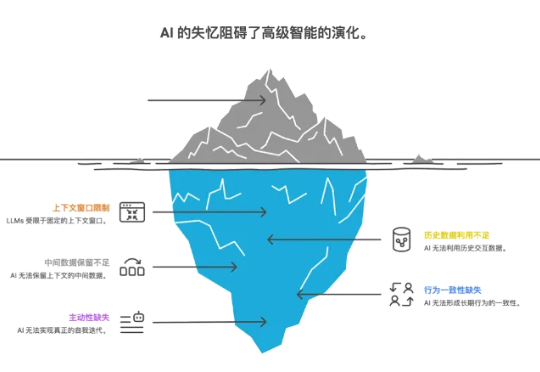

记忆,或是 AI 从「即时回答工具」迈向「个性化超级助手」的关键突破

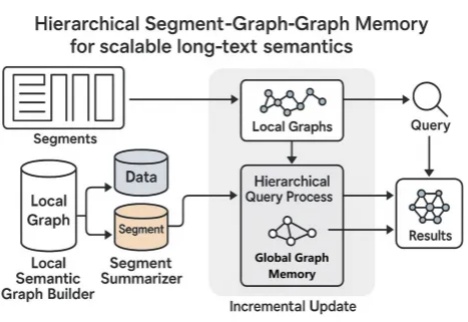

当你阅读《红楼梦》《哈利·波特》《百年孤独》等长篇小说时,读着读着可能就忘记前面讲了什么,有时还会搞混人物关系。AI 在阅读长文章的时候也存在类似问题,当文章太长时它也会卡主,要么读得特别慢,要么记不住前面的内容。

斯坦福明星华人博士生的创业机器人,终于正式亮相!

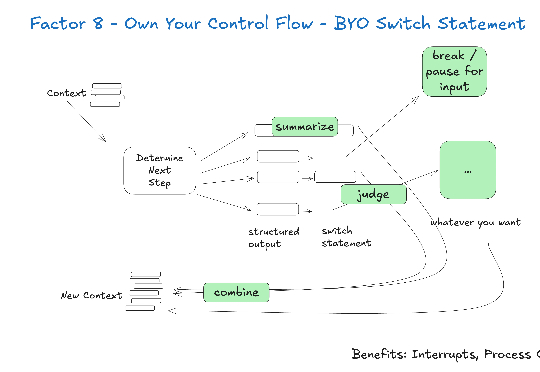

最近半年,我阅读了业界关于 AI Agent 的工程实践:Anthropic 的 Context Engineering 论文、Manus 的工程分享、Cline 的 Memory Bank 设计等。同时自己也一直在做跟 AI Agent 相关的项目,如:Jta[1](开源的翻译 Agent,基于 Agentic Workflow)。

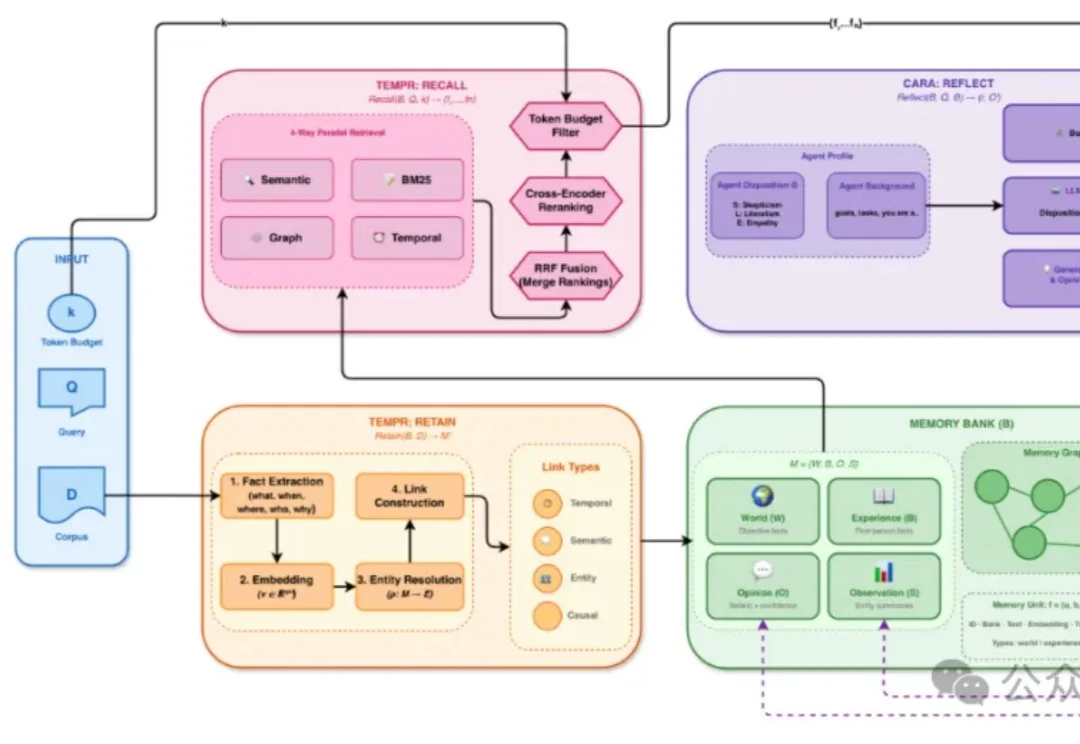

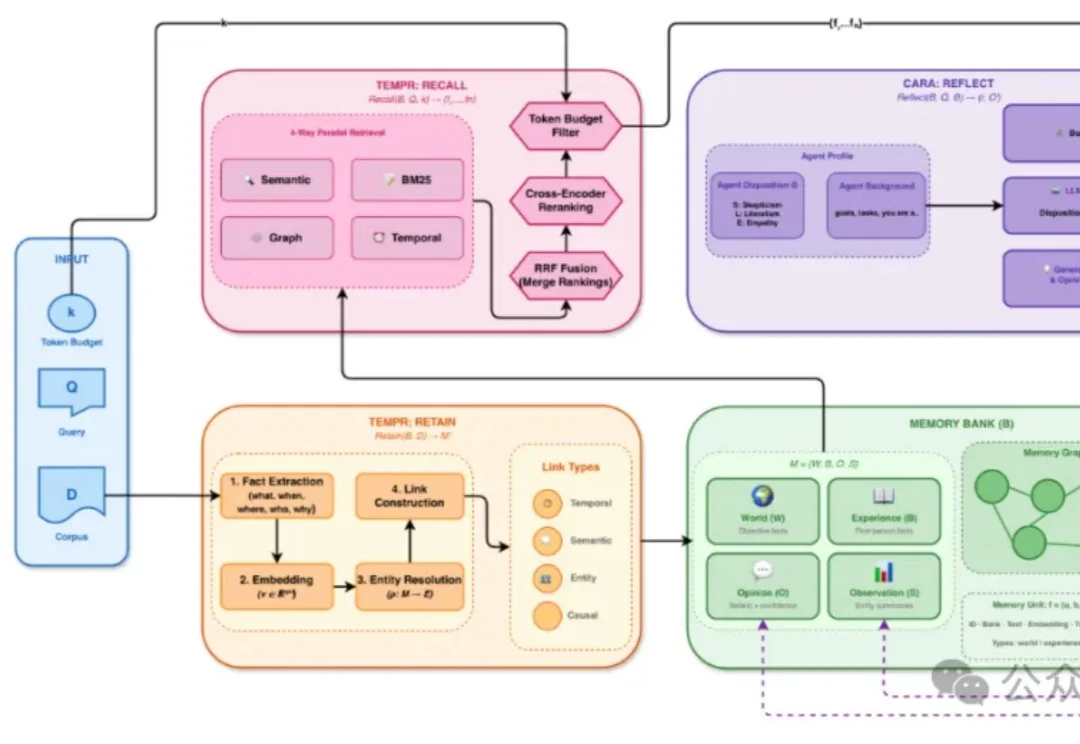

EverMind 团队近日宣布正式发布其旗舰产品 EverMemOS,这是一款面向人工智能智能体的世界级长期记忆操作系统。它旨在成为未来智能体的数据基础设施,为 AI 赋予持久、连贯、可进化的 “灵魂”。

谷歌在第三天发布了《上下文工程:会话与记忆》(Context Engineering: Sessions & Memory) 白皮书。文中开篇指出,LLM模型本身是无状态的 (stateless)。如果要构建有状态的(stateful)和个性化的 AI,关键在于上下文工程。