3A大作!阿里ROLL团队从基建->算法->机理,推动RL4LLM全栈协同优化

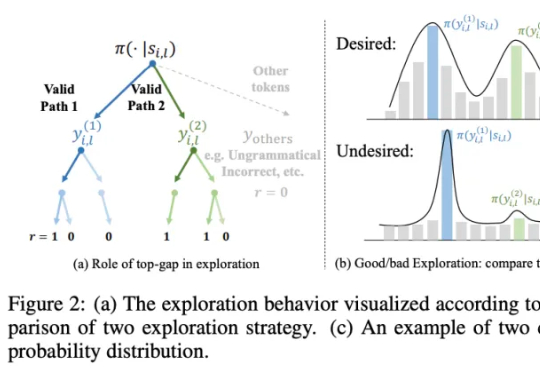

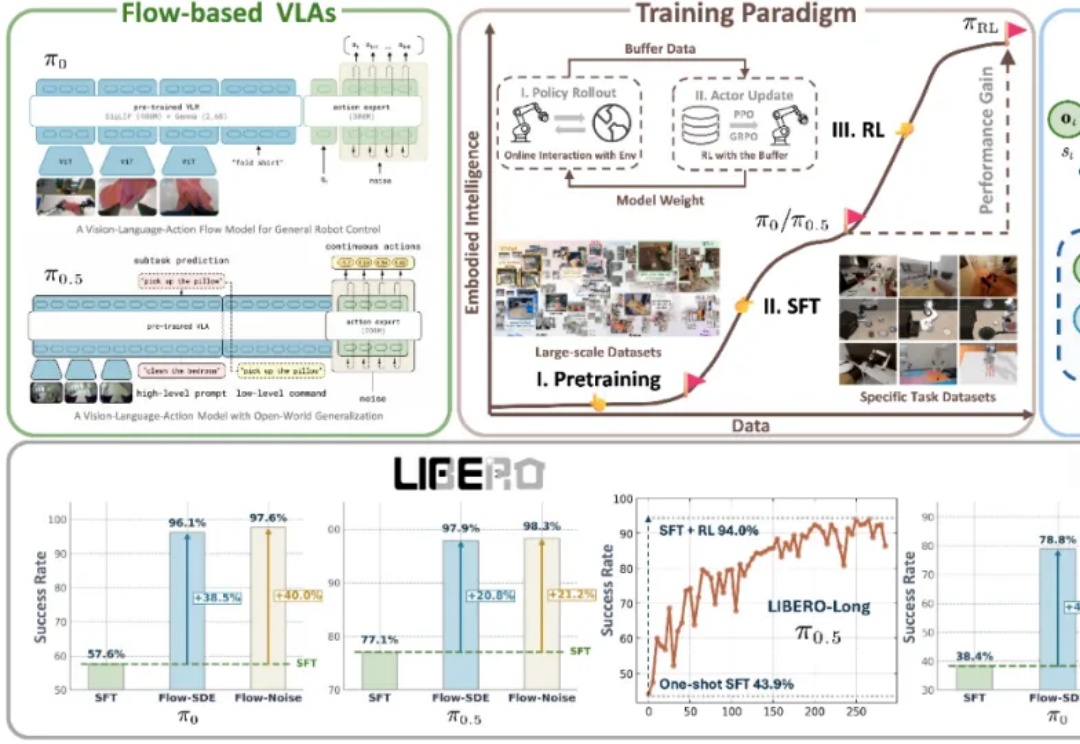

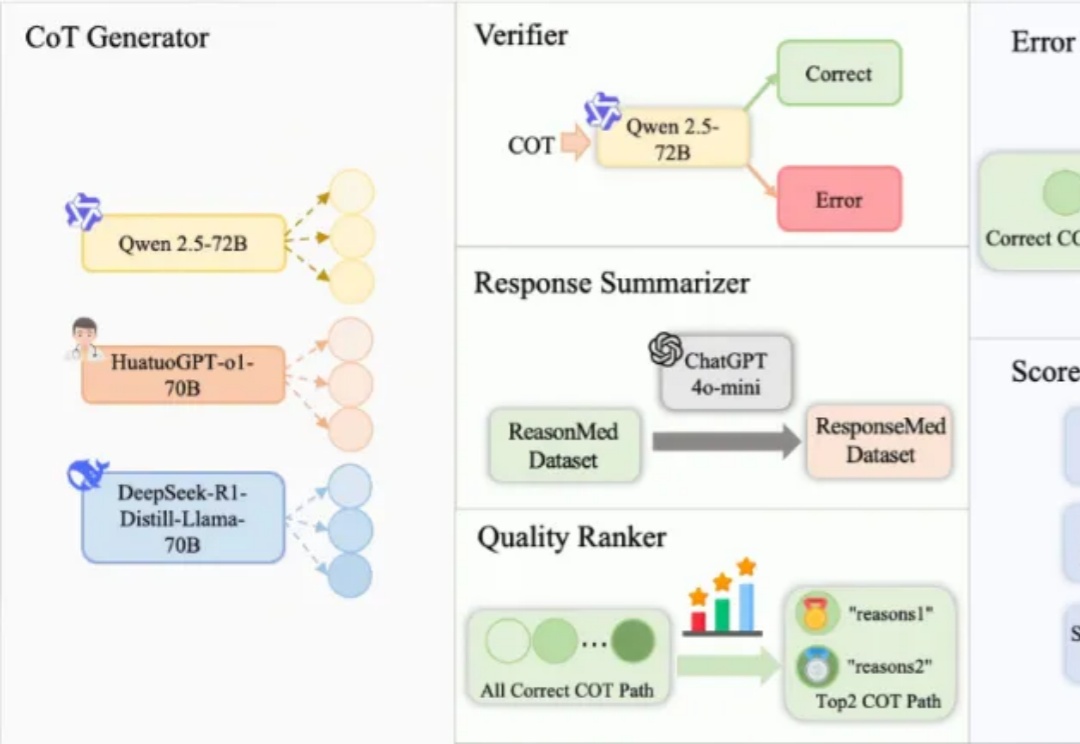

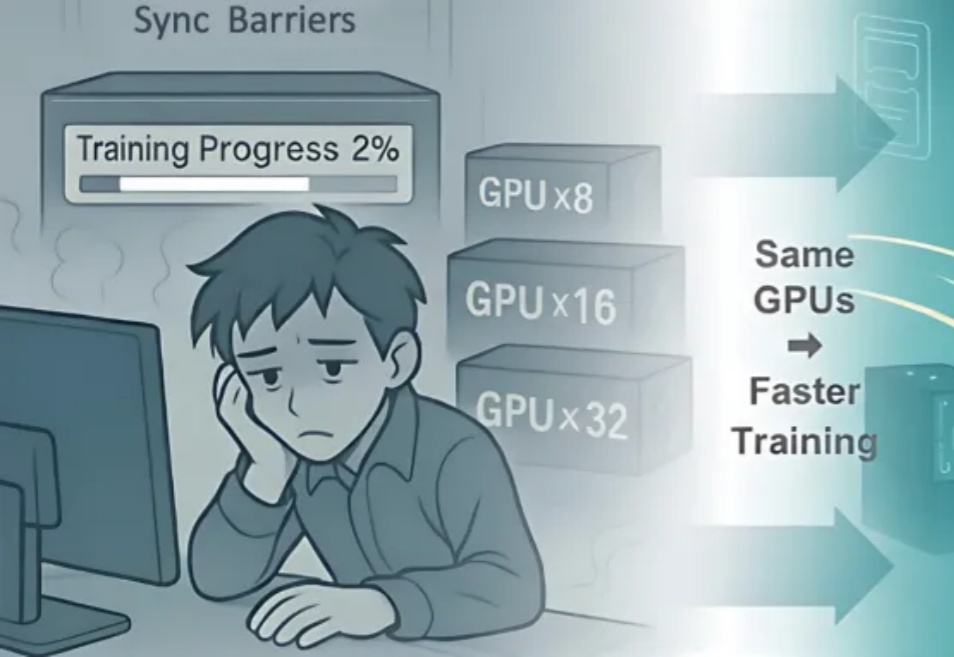

3A大作!阿里ROLL团队从基建->算法->机理,推动RL4LLM全栈协同优化近期,阿里巴巴 ROLL 团队(淘天未来生活实验室与阿里巴巴智能引擎团队)联合上海交通大学、香港科技大学推出「3A」协同优化框架 ——Async 架构(Asynchronous Training)、Asymmetric PPO(AsyPPO)与 Attention 机制(Attention-based Reasoning Rhythm),