Transformer已死?DeepMind正在押注另一条AGI路线

Transformer已死?DeepMind正在押注另一条AGI路线借鉴人类联想记忆,嵌套学习让AI在运行中构建抽象结构,超越Transformer的局限。谷歌团队强调:优化器与架构互为上下文,协同进化才能实现真正持续学习。这篇论文或成经典,开启AI从被动训练到主动进化的大门。

借鉴人类联想记忆,嵌套学习让AI在运行中构建抽象结构,超越Transformer的局限。谷歌团队强调:优化器与架构互为上下文,协同进化才能实现真正持续学习。这篇论文或成经典,开启AI从被动训练到主动进化的大门。

在检索增强生成中,扩大生成模型规模往往能提升准确率,但也会显著抬高推理成本与部署门槛。CMU 团队在固定提示模板、上下文组织方式与证据预算,并保持检索与解码设置不变的前提下,系统比较了生成模型规模与检索语料规模的联合效应,发现扩充检索语料能够稳定增强 RAG,并在多项开放域问答基准上让小中型模型在更大语料下达到甚至超过更大模型在较小语料下的表现,同时在更高语料规模处呈现清晰的边际收益递减。

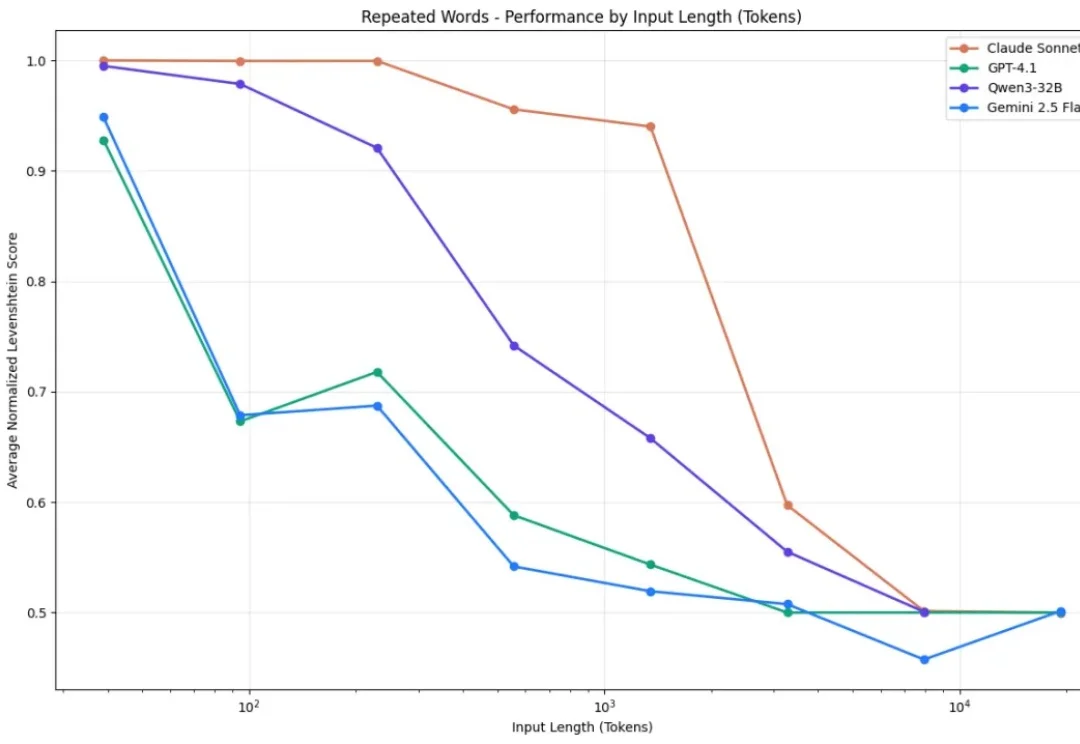

你有没有发现,你让AI读一篇长文章,结果它读着读着就忘了前面的内容? 你让它处理一份超长的文档,结果它给出来的答案,牛头不对马嘴? 这个现象,学术界有个专门的名词,叫做上下文腐化。 这也是目前AI的通病:大模型的记忆力太差了,文章越长,模型越傻!

新年伊始,MIT CSAIL 的一纸论文在学术圈引发了不小的讨论。Alex L. Zhang 、 Tim Kraska 与 Omar Khattab 三位研究者在 arXiv 上发布了一篇题为《Recursive Language Models》的论文,提出了所谓“递归语言模型”(Recursive Language Models,简称 RLM)的推理策略。

2026年开局,Anthropic未发一弹已占先机!谷歌首席工程师Jaana Dogan连发多帖,高度赞扬Claude Opus 4.5——没有图像/音频模型、巨大的上下文,仅有一款专注编码的Claude,Anthropic依旧是OpenAI谷歌最有力竞争者。

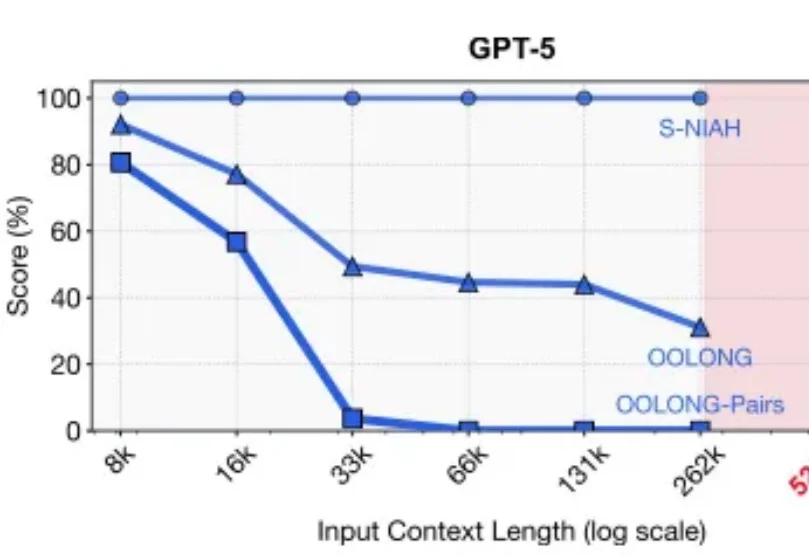

2025年的最后一天, MIT CSAIL提交了一份具有分量的工作。当整个业界都在疯狂卷模型上下文窗口(Context Window),试图将窗口拉长到100万甚至1000万token时,这篇论文却冷静地指出了一个被忽视的真相:这就好比试图通过背诵整本百科全书来回答一个复杂问题,既昂贵又低效。

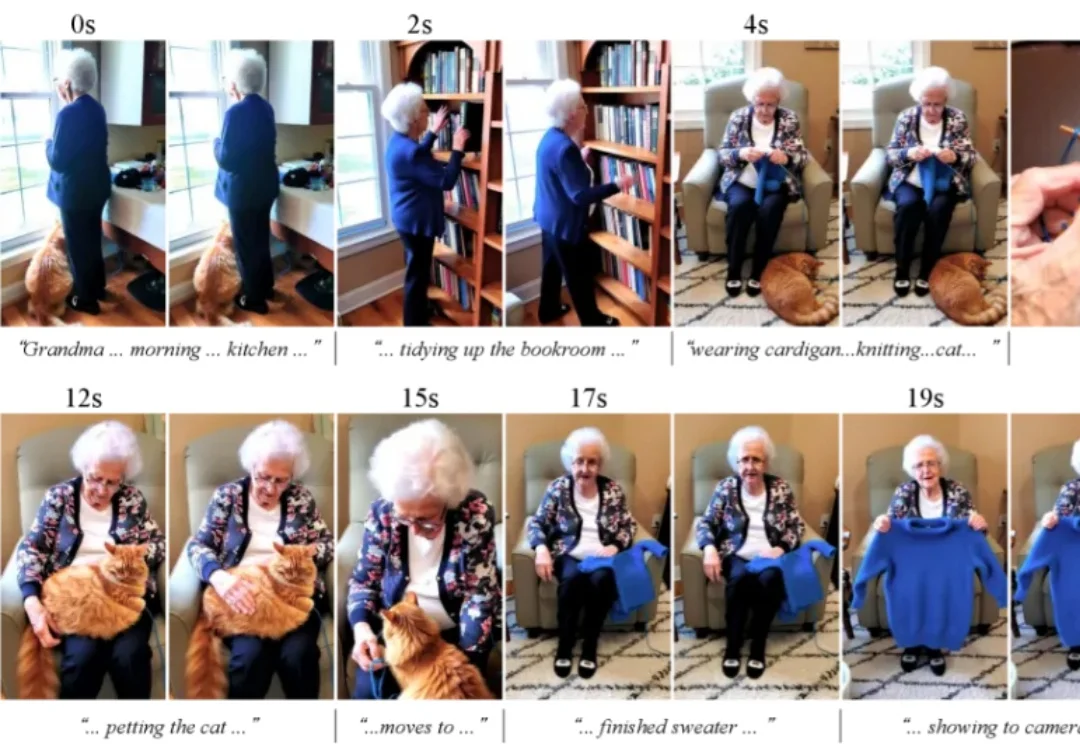

大部分的高质量视频生成模型,都只能生成上限约15秒的视频。清晰度提高之后,生成的视频时长还会再一次缩短。

大家好,我是鲁工。 长期以来,Gemini CLI在与Claude Code等AI编程工具竞争时都面临劣势。 随着上个月Gemini 3 Pro发布,谷歌同时也推出了全新的AI编程IDE Antigr

编辑|张倩、陈陈 当智能体(Agent)开始深度介入人类世界,关于豆包 AI 手机的讨论可能只是个开始。 在此之前,手机、电脑软件都是给人用的 —— 人负责一步步操作,系统负责把信息存好、算好。但现在

在一场技术演讲中,Netflix 工程部的资深大牛 Jake Nations,开场就抛出了一个几乎所有工程师都心照不宣的“坦白”。几乎每个正在使用 Copilot、Cursor、Claude 写代码的人,都干过同一件事:让 AI 生成代码,看起来没问题,就直接交付。测试通过、功能可用、部署成功,但当系统真的在凌晨三点出问题时,没人能再说清楚它为什么还能跑。