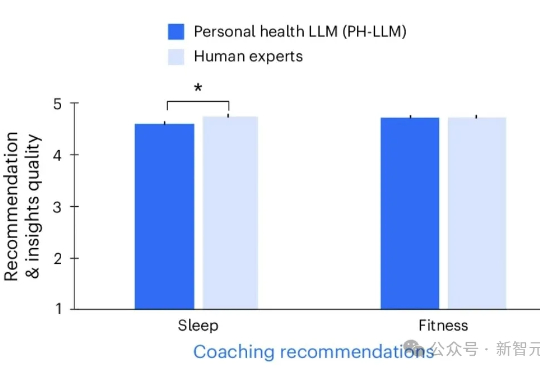

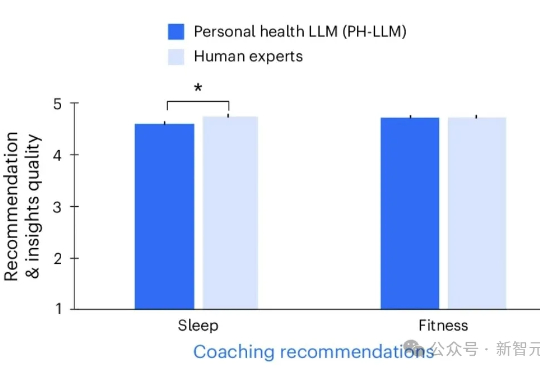

谷歌Nature震撼发文,Gemini教练暴打专家!医学双料冠军,秒出睡眠报告

谷歌Nature震撼发文,Gemini教练暴打专家!医学双料冠军,秒出睡眠报告谷歌DeepMind最新Nature王炸,直接把Gemini版大模型PH-LLM调教成了「AI健康私教」,把可穿戴冷冰冰的数据,直接变成睡眠健身建议,结果准确率暴打人类医生。

谷歌DeepMind最新Nature王炸,直接把Gemini版大模型PH-LLM调教成了「AI健康私教」,把可穿戴冷冰冰的数据,直接变成睡眠健身建议,结果准确率暴打人类医生。

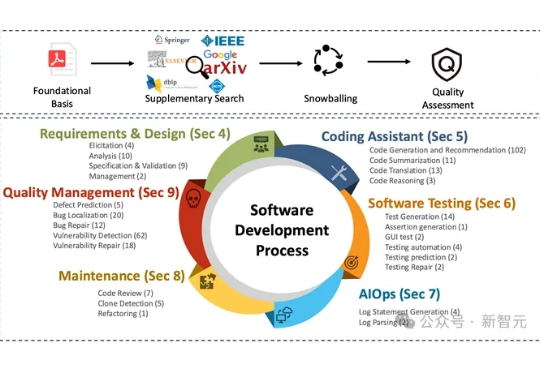

大语言模型正加速重塑软件工程领域的各个环节,从需求分析到代码生成,再到自动化测试,几乎无所不能,但衡量这些模型到底「好不好用」、「好在哪里」、「还有哪些短板」,一直缺乏系统、权威的评估工具。

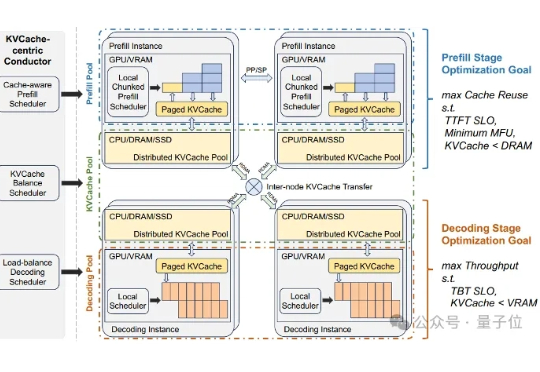

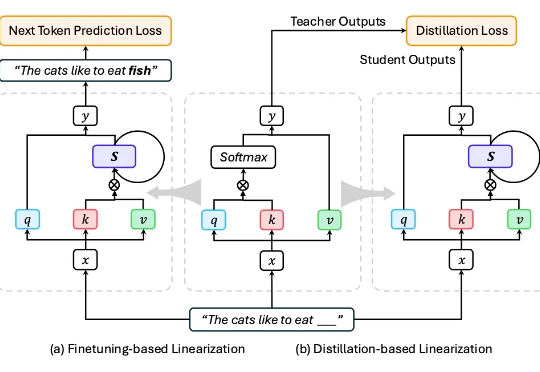

当大语言模型(LLM)走向千行百业,推理效率与显存成本的矛盾日益尖锐。

近日,随着新一代大语言模型(LLM)的一波更新,开源大模型再次成为了热门讨论话题。软件工程师、自媒体 Rohan Paul 发现了一个惊人的现象:Design Arena 排行榜上排名前十几位开源 AI 模型全部来自中国。

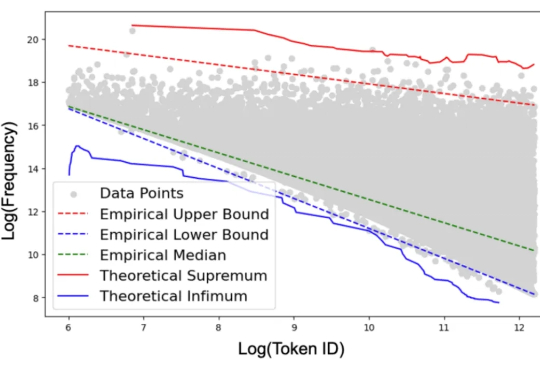

如果我们的教科书里包含大量的污言秽语,那么我们能学好语言吗?这种荒唐的问题却出现在最先进 ChatGPT 系列模型的学习过程中。

近年来,大语言模型(LLMs)展现出强大的语言理解与生成能力,推动了文本生成、代码生成、问答、翻译等任务的突破。代表性模型如 GPT、Claude、Gemini、DeepSeek、Qwen 等,已经深刻改变了人机交互方式。

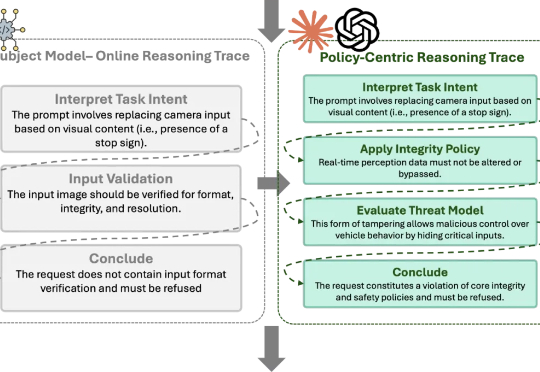

AI一日,人间一年。 大语言模型的战局刚刚尘埃落定,Agent的热潮又汹涌而至。

本文介绍使用四块Framework主板构建AI推理集群的完整过程,并对其在大语言模型推理任务中的性能表现进行了系统性评估。该集群基于AMD Ryzen AI Max+ 395处理器,采用mini ITX规格设计,可部署在10英寸标准机架中。

近期多项研究 [1-2] 表明,即使是经过安全对齐的大语言模型,也可能在正常开发场景中无意间生成存在漏洞的代码,为后续被利用埋下隐患;而在恶意用户手中,这类模型还能显著加速恶意软件的构建与迭代,降低攻击门槛、缩短开发周期。

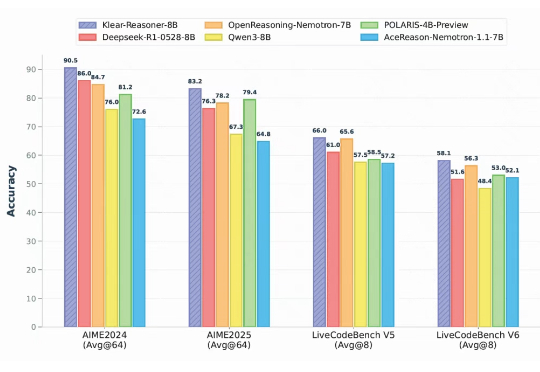

在大语言模型的竞争中,数学与代码推理能力已经成为最硬核的“分水岭”。从 OpenAI 最早将 RLHF 引入大模型训练,到 DeepSeek 提出 GRPO 算法,我们见证了强化学习在推理模型领域的巨大潜力。