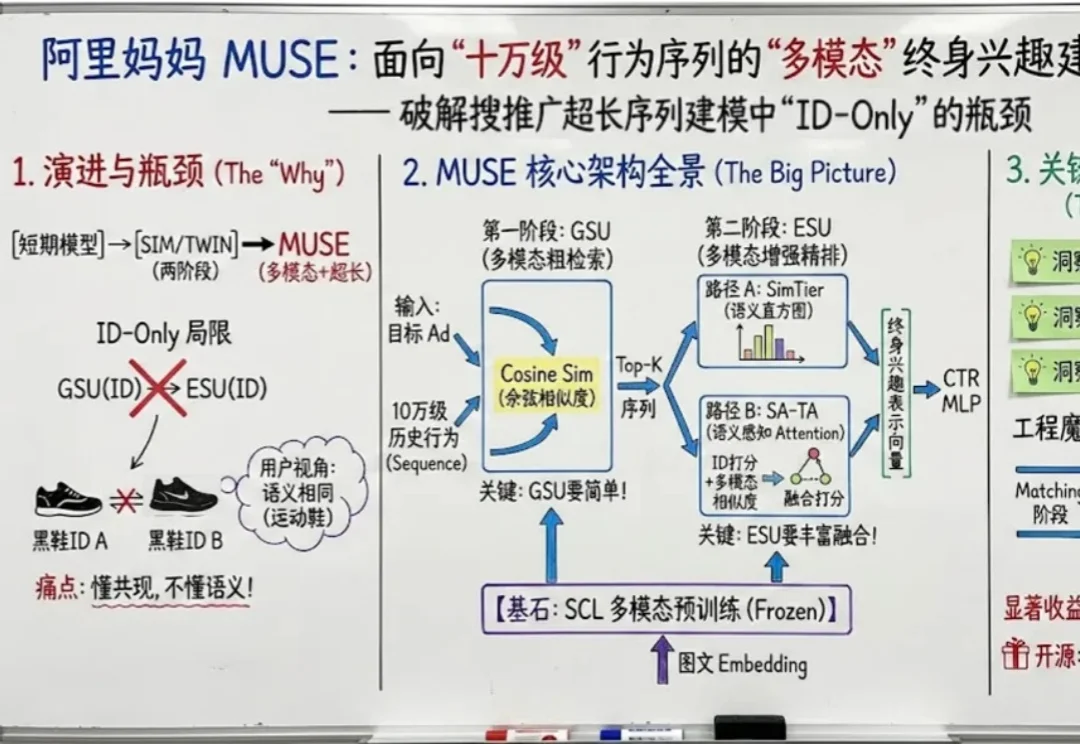

阿里妈妈发布MUSE:用多模态搞定十万级超长行为序列,并开源Taobao-MM数据集

阿里妈妈发布MUSE:用多模态搞定十万级超长行为序列,并开源Taobao-MM数据集如果把用户在互联网上留下的每一个足迹都看作一段记忆,那么现在的推荐系统大多患有 “短期健忘症”。

如果把用户在互联网上留下的每一个足迹都看作一段记忆,那么现在的推荐系统大多患有 “短期健忘症”。

走上了堪称是“最佳 AI 转型路径”之后,他也在读研期间和合作者针对 AI 记忆开展了一项研究,借此发明出一种名为 LightMem(轻量记忆)的技术。在 LongMemEval 和 LoCoMo 这两个专门用于考察 AI 长期记忆能力的基准测试上,LightMem 回答问题的准确率全面超越之前的冠军模型,最高提升了 7% 以上,在某些数据集上甚至提升了将近 30%。

最近研究发现,大模型在判断逻辑谬误时容易「想太多」,误报正常句子,但在确定有谬误后,其分类能力较强。研究人员构建了首个高质量英文逻辑谬误基准SMARTYPAT-BENCH,并开发了基于Prolog的逻辑谬误自动生成框架SMARTYPAT,为大模型逻辑能力评估提供新思路,可用于谬误识别、辩论教育等领域。

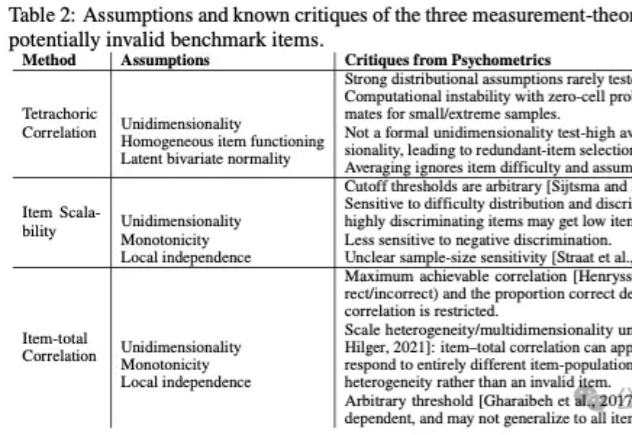

基准测试(Benchmarks)在人工智能的发展进程中扮演着至关重要的角色,构成了评价生成式模型(Generative Models)性能的事实标准。对于从事模型训练与评估的AI研究者而言,GSM8K、MMLU等数据集的数据质量直接决定了评估结论的可靠性。

卡内基梅隆揭秘美国AI产业链:谁能扼住AI的喉咙?OpenAI和迪士尼如何捆绑,AMD、软银和英伟达究竟在下哪盘棋?卡内基梅隆大学刚刚抛出一颗「产业核弹」:首个系统刻画数据、算力、模型、资本乃至人才流向的AI供应链数据集。

具身智能的Scaling Law正蓄势待发。

华中科技大学团队推出首个水下多模态大模型NAUTILUS,支持8种水下场景理解任务,并开源145万图文对的NautData数据集。模型通过视觉特征增强模块解决水下图像模糊和颜色失真问题,性能超越现有模型,恶劣环境下表现更佳。

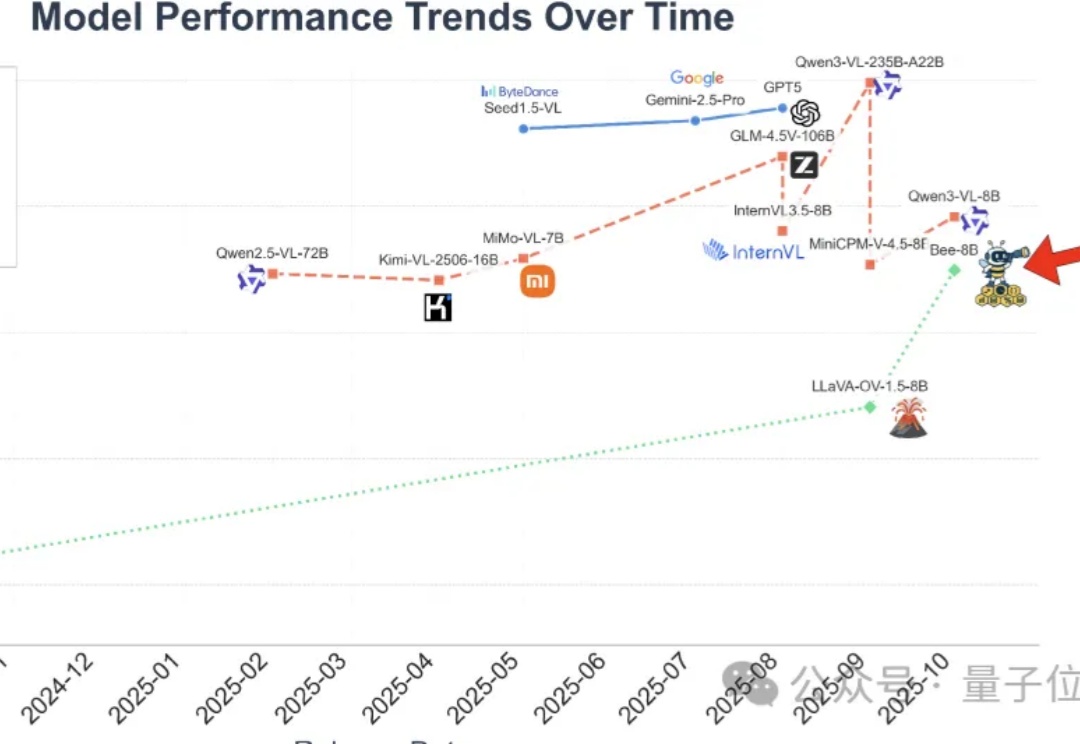

全开源多模态大模型(MLLM)的性能,长期被闭源和半开源模型“卡脖子”。

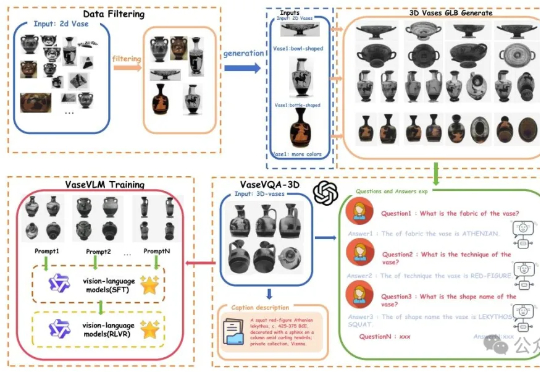

现在AI都懂文物懂历史了。一项来自北京大学的最新研究引发关注:他们推出了全球首个面向古希腊陶罐的3D视觉问答数据集——VaseVQA-3D,并配套推出了专用视觉语言模型VaseVLM。这意味着,AI正在从“识图机器”迈向“文化考古Agent”。

数据集蒸馏是一种用少量合成数据替代全量数据训练模型的技术,能让模型高效又节能。WMDD和GUARD两项研究分别解决了如何保留原始数据特性并提升模型对抗扰动能力的问题,使模型在少量数据上训练时既准确又可靠。