FDA对偶锚点:模型知识迁移的新视角——从参数空间到输入空间

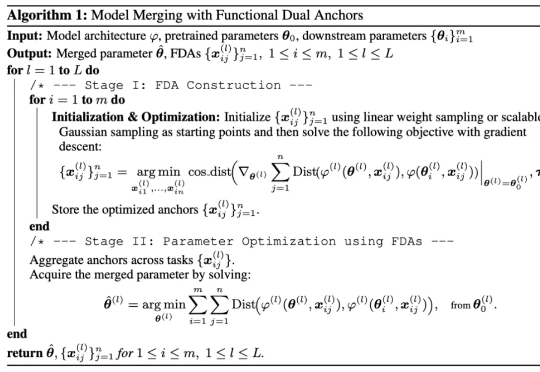

FDA对偶锚点:模型知识迁移的新视角——从参数空间到输入空间研究者们提出了 FDA(Model Merging with Functional Dual Anchors)——一个全新的模型融合框架。与传统的参数空间操作不同,FDA 将专家模型的参数知识投射到输入-表征空间中的合成锚点,通过功能对偶的方式实现更高效的知识整合。

研究者们提出了 FDA(Model Merging with Functional Dual Anchors)——一个全新的模型融合框架。与传统的参数空间操作不同,FDA 将专家模型的参数知识投射到输入-表征空间中的合成锚点,通过功能对偶的方式实现更高效的知识整合。

多模态大语言模型(MLLM)在目标定位精度上被长期诟病,难以匹敌传统的基于坐标回归的检测器。近日,来自 IDEA 研究院的团队通过仅有 3B 参数的通用视觉感知模型 Rex-Omni,打破了这一僵局。

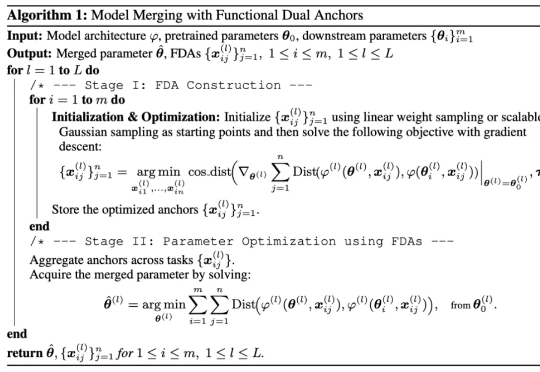

近日,来自北京大学与BeingBeyond的研究团队提出DemoHLM框架,为人形机器人移动操作(loco-manipulation)领域提供一种新思路——仅需1次仿真环境中的人类演示,即可自动生成海量训练数据,实现真实人形机器人在多任务场景下的泛化操作,有效解决了传统方法依赖硬编码、真实数据成本高、跨场景泛化差的核心痛点。

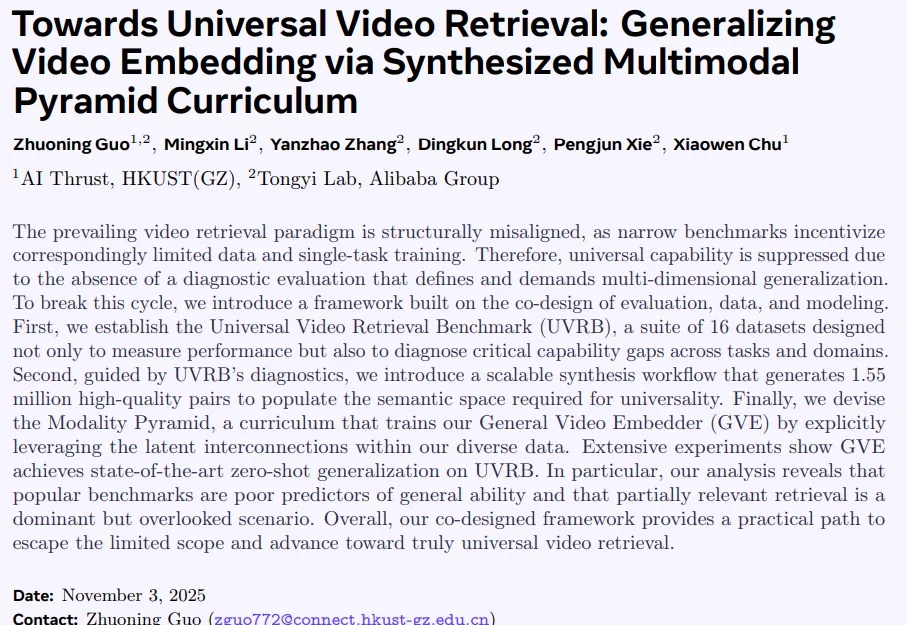

当前视频检索研究正陷入一个闭环困境:以MSRVTT为代表的窄域基准,长期主导模型在粗粒度文本查询上的优化,导致训练数据有偏、模型能力受限,难以应对真实世界中细粒度、长上下文、多模态组合等复杂检索需求。

今日,科技圈爆出了一则重磅猛料。11月12日消息,@新浪科技从知情人士处获悉,字节跳动的Seed研究员任赜宇于昨日离职,离职原因为“多次泄密遭公司开除” 。

微软AI负责人Mustafa Suleyman表示,只有生物体才能具备意识,开发者和研究人员应该停止追求让AI具有意识。

人工智能搜索初创公司You.com 首席执行官 、Salesforce 前首席科学家理查德·索彻,计划为其即将主理的新人工智能研究初创公司募集约 10 亿美元资金,两名曾与 You.com 高管交流的消息人士透露。索彻在采访中表示,他将继续执掌 You.com。

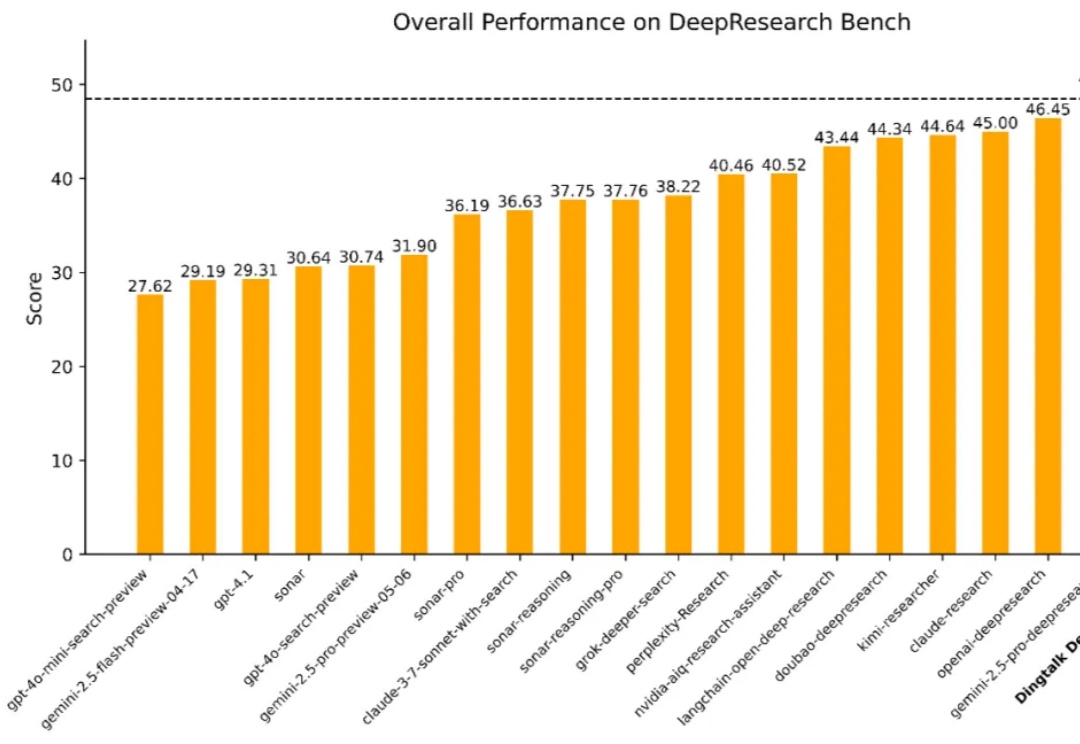

在数字经济浪潮中,企业对于高效、精准的信息获取与决策支持的需求日益迫切。从前沿科学探索到行业趋势分析,再到企业级决策支持,一个能够从海量异构数据源中提取关键知识、执行多步骤推理并生成结构化或多模态输出的「深度研究系统」正变得不可或缺。

浙江大学和新加坡南洋理工大学新研究旨在探索空间碳中和数据中心的可行性。太空环境具备两大独特优势:丰富的太阳能可为计算设备提供清洁稳定的电力;接近绝对零度的深空环境则为服务器废热提供了理想的散热条件。

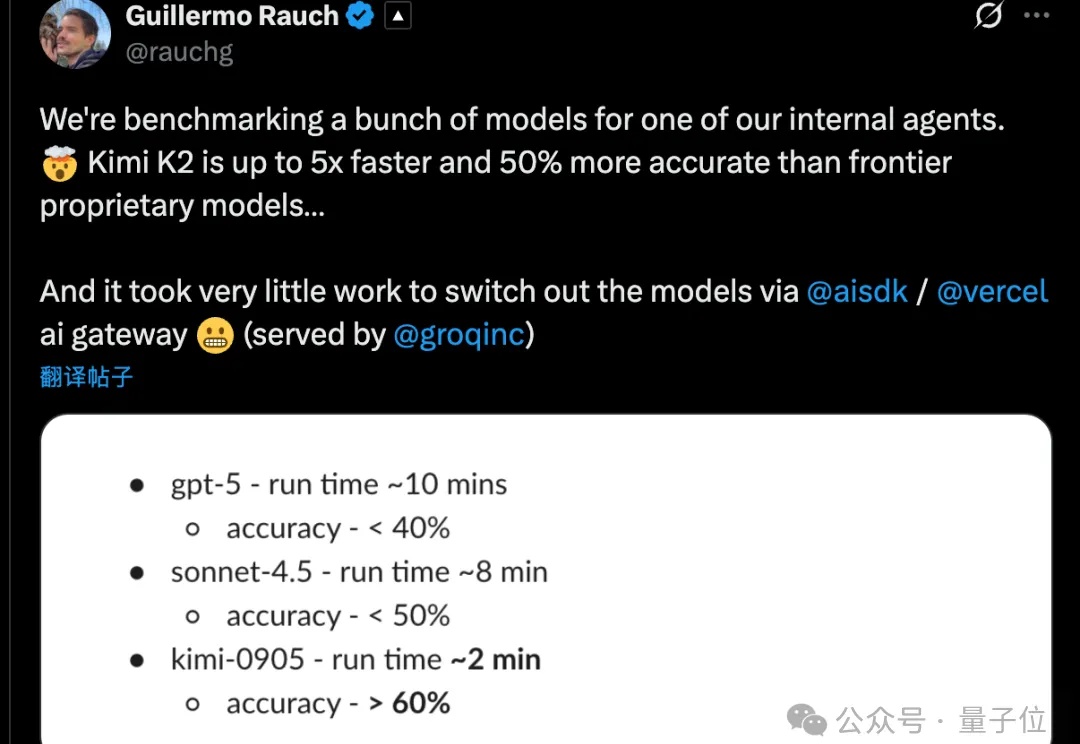

Kimi K2 Thinking训练真的只花了460万美元?杨植麟亲自带队,月之暗面创始团队出面回应了。这不是官方数据。训练成本很难计算,因为其中很大一部分用于研究和实验。他们还透露训练使用了配备Infiniband的英伟达H800,GPU数量也比巨头的少,但充分利用了每一张卡。