不会用命令行?Claude Code图形化界面完全指南

不会用命令行?Claude Code图形化界面完全指南面对苍白的CLI终端界面,有些深度依赖IDE的使用者,用Claude Code还是会不习惯的。于是我找了蛮多的资料,看看有没有适合新手的GUI工具。

面对苍白的CLI终端界面,有些深度依赖IDE的使用者,用Claude Code还是会不习惯的。于是我找了蛮多的资料,看看有没有适合新手的GUI工具。

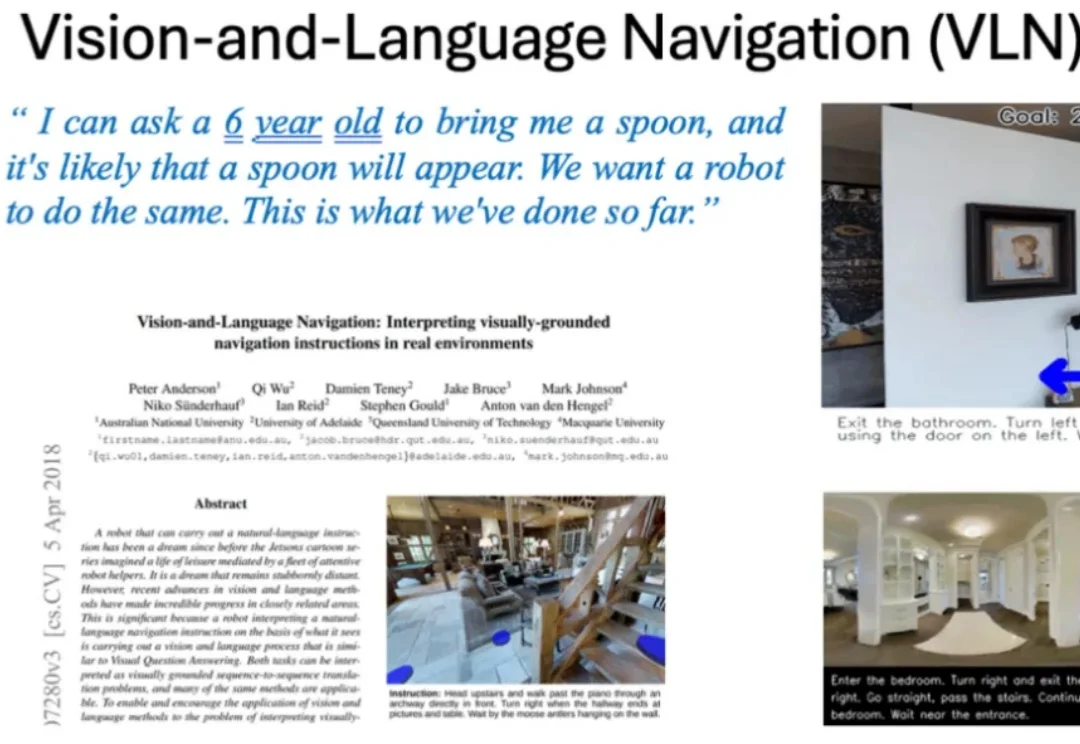

告别碎片化!以全栈之姿,开启具身导航的 2026 新篇章。

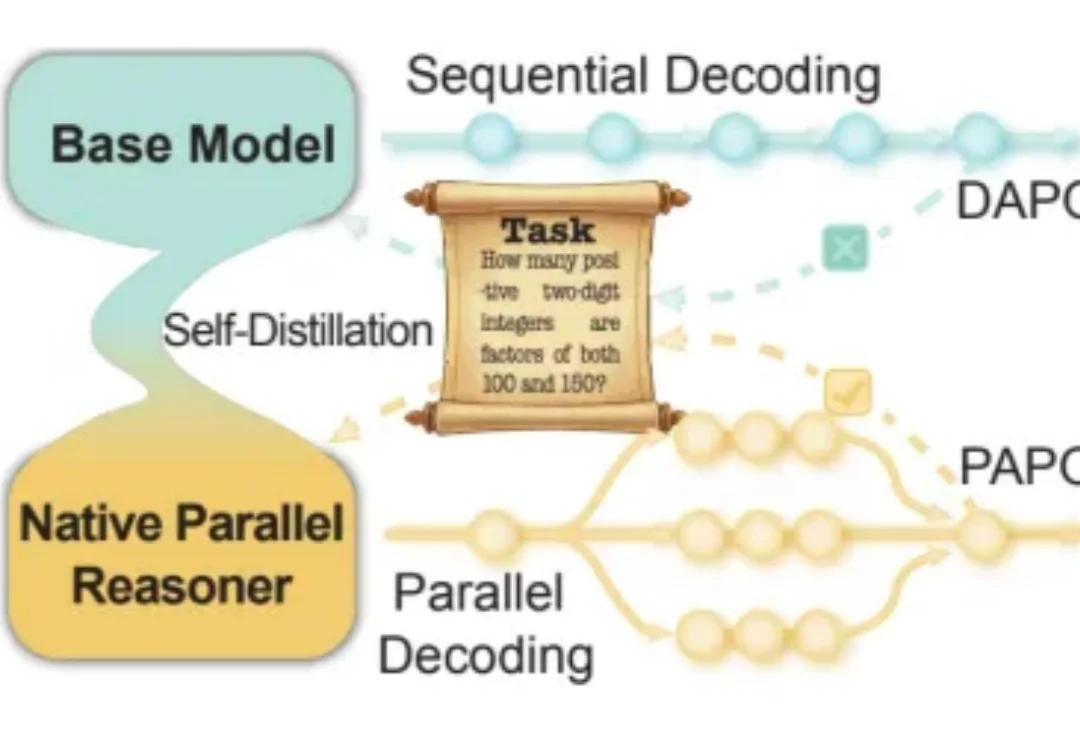

近年来,大语言模型在「写得长、写得顺」这件事上进步飞快。但当任务升级到真正复杂的推理场景 —— 需要兵分多路探索、需要自我反思与相互印证、需要在多条线索之间做汇总与取舍时,传统的链式思维(Chain-of-Thought)往往就开始「吃力」:容易被早期判断带偏、发散不足、自我纠错弱,而且顺序生成的效率天然受限。

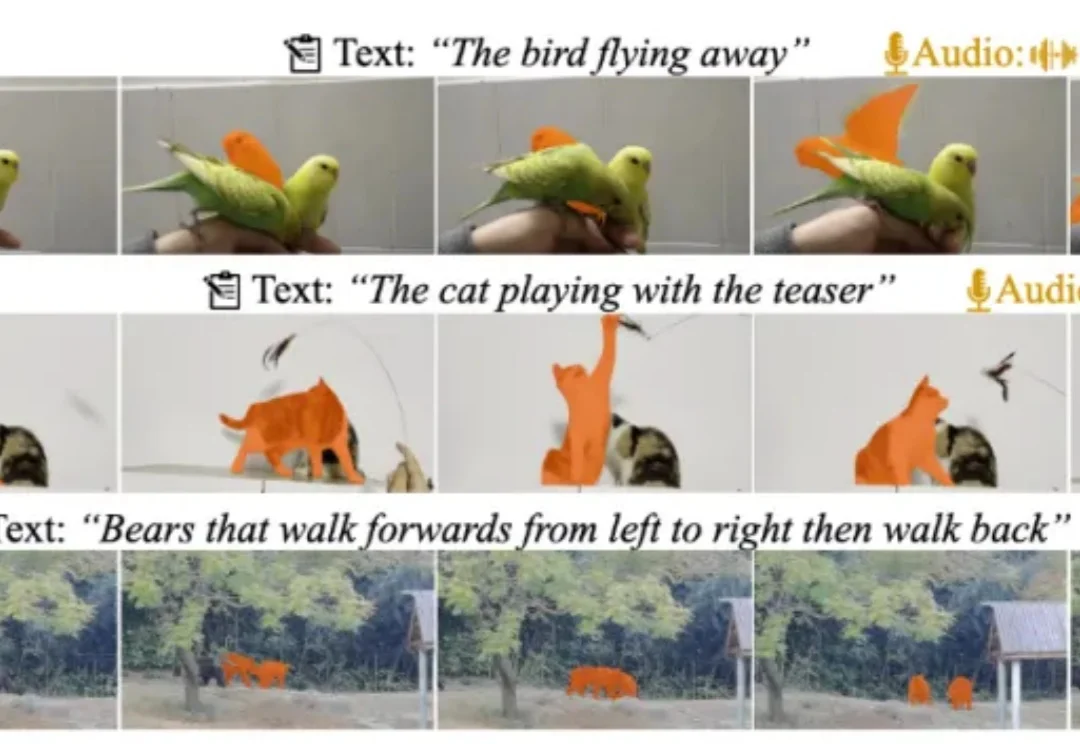

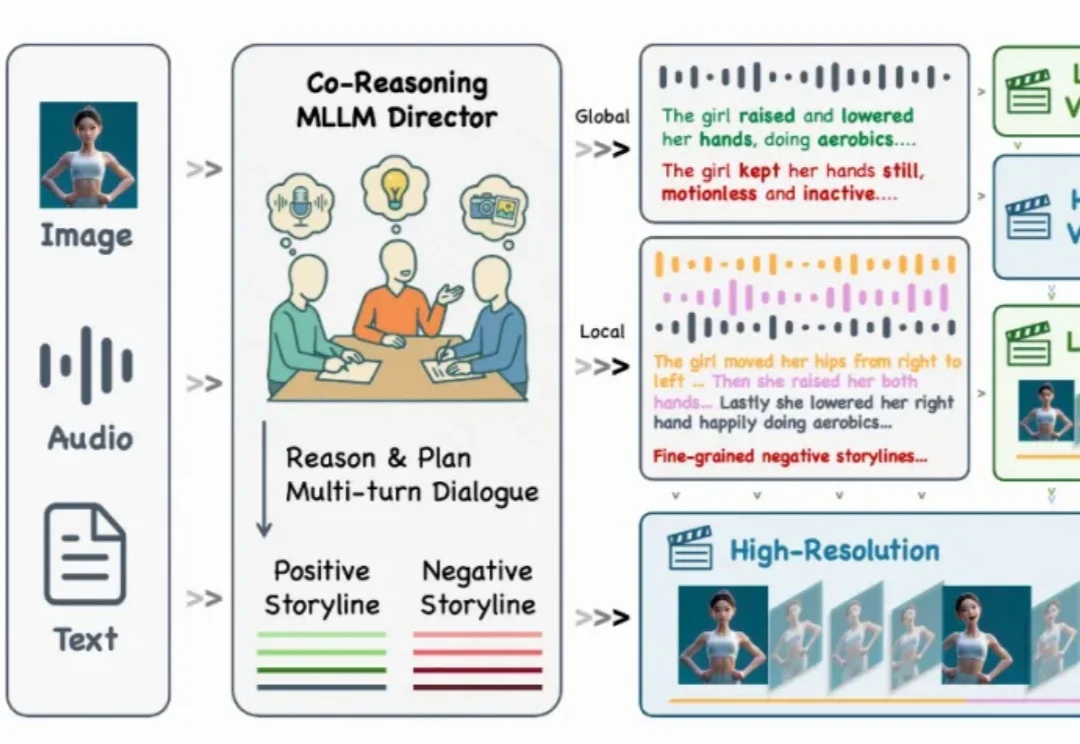

近日,多模态视频理解领域迎来重磅更新!由复旦大学、上海财经大学、南洋理工大学联合打造的 MeViSv2 数据集正式发布,并已被顶刊 IEEE TPAMI 录用。

当模型学会「左右互搏」的那一刻,平庸的模仿时代结束了,真正的硅基编程奇迹刚刚开始。

近年来,多模态大语言模型正在经历一场快速的范式转变,新兴研究聚焦于构建能够联合处理和生成跨语言、视觉、音频以及其他潜在感官模态信息的统一全模态大模型。此类模型的目标不仅是感知全模态内容,还要将视觉理解和生成整合到统一架构中,从而实现模态间的协同交互。

近日,部分L3级自动驾驶车型已经通过工信部批准正式上路,这标志着这我国自动驾驶产业的新阶段。

编辑|张倩、陈陈 当智能体(Agent)开始深度介入人类世界,关于豆包 AI 手机的讨论可能只是个开始。 在此之前,手机、电脑软件都是给人用的 —— 人负责一步步操作,系统负责把信息存好、算好。但现在

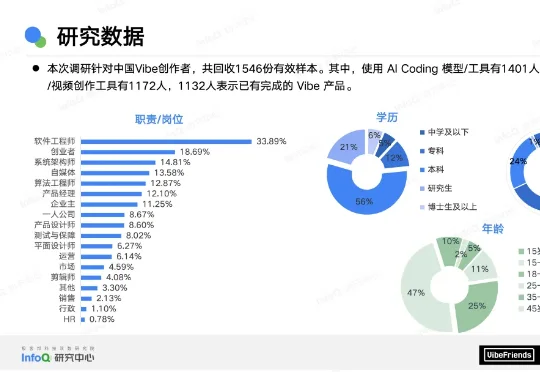

开发周期被打破了。曾需数月打磨的 MVP,如今近七成可在一个月内上线;曾需十人协作的产研流程,如今超七成由三人以下小团队完成。AI Coding 工具已不再是辅助,而是主力:仅 1% 的创作者仍完全手写代码,近六成将多数乃至全部编码交予 AI。效率的跃升前所未有,但随之而来的是一个尖锐的问题:快,是否等于有价值?

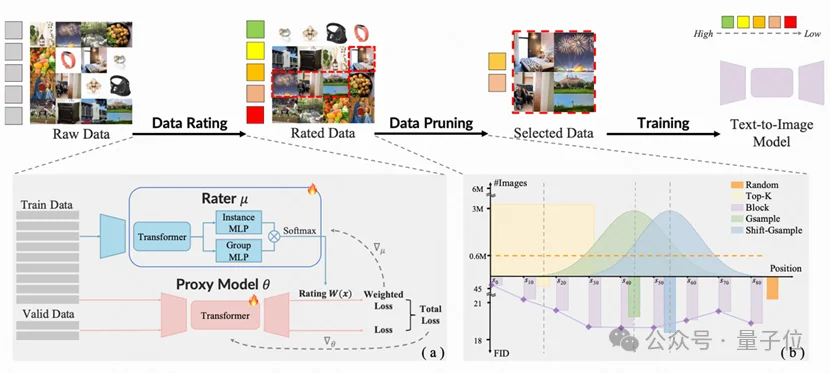

由香港大学丁凯欣领导,联合华南理工大学周洋以及快手科技Kling团队共同完成的这项研究,开发出了一个名为“炼金师”(Alchemist)的AI系统。它就像一位挑剔的大厨,能从海量图片数据中精准挑选出最有价值的一半。

现在生成一个视频,比你刷视频还要快。

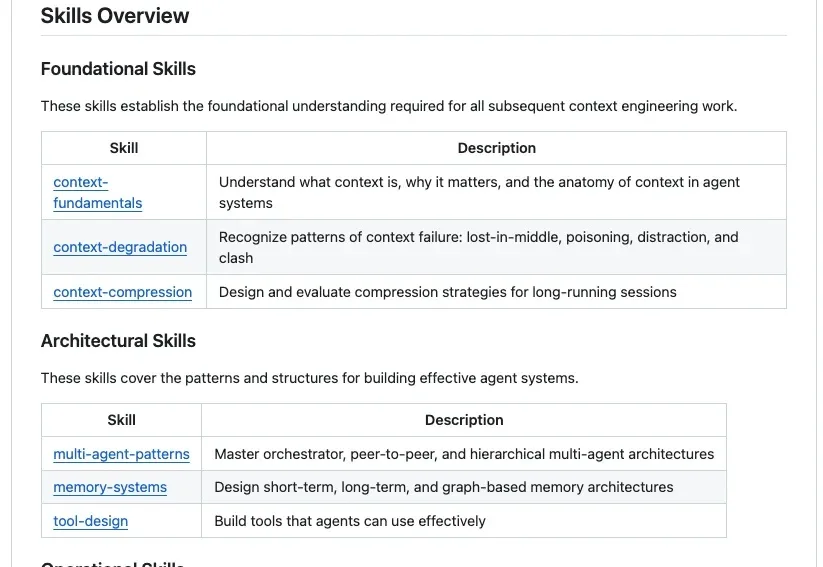

GitHub上最近出现了一个非常火的项目Agent-Skills-for-Context-Engineering,发布不到一周就斩获了2.3k Stars。为什么它能瞬间引爆社区?因为站在2025年末的节点上,我们已经受够了那些只存在于大厂白皮书里的Context Engineering(上下文工程) 理论。

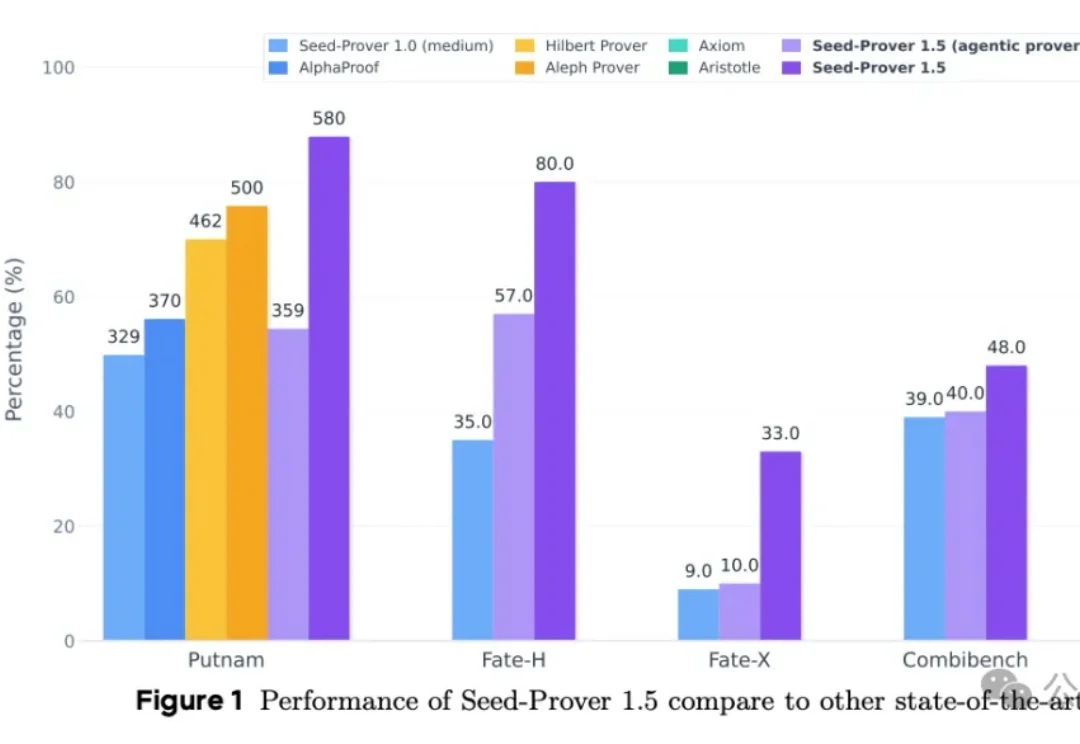

字节最新数学推理专用模型,刚刚刷新战绩:拿下IMO金牌成绩。

AI提供1%的灵感,人类提供99%汗水!密歇根州立大学物理学家许道辉,在AI启发下,重新思考量子力学本质,在顶刊《物理快报B》上发表了相关结论。

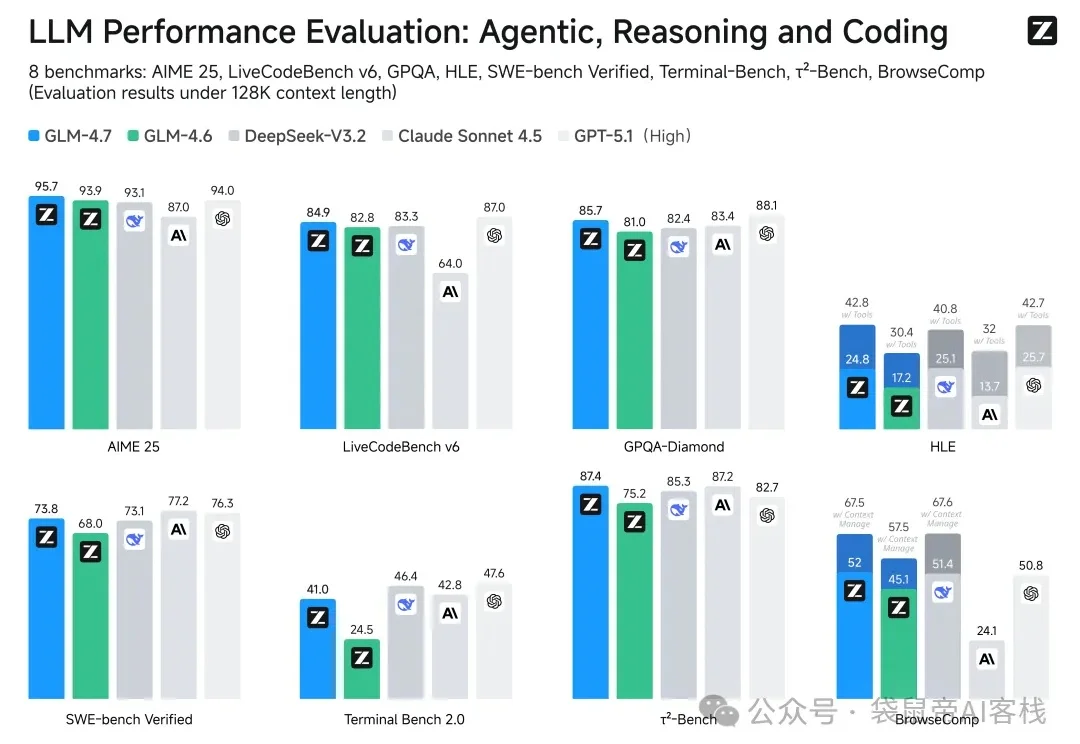

大家好,我是被智谱卷到的袋鼠帝。 昨天智谱刚把GLM-4.7放出来,群里就有老哥找我写文章了..

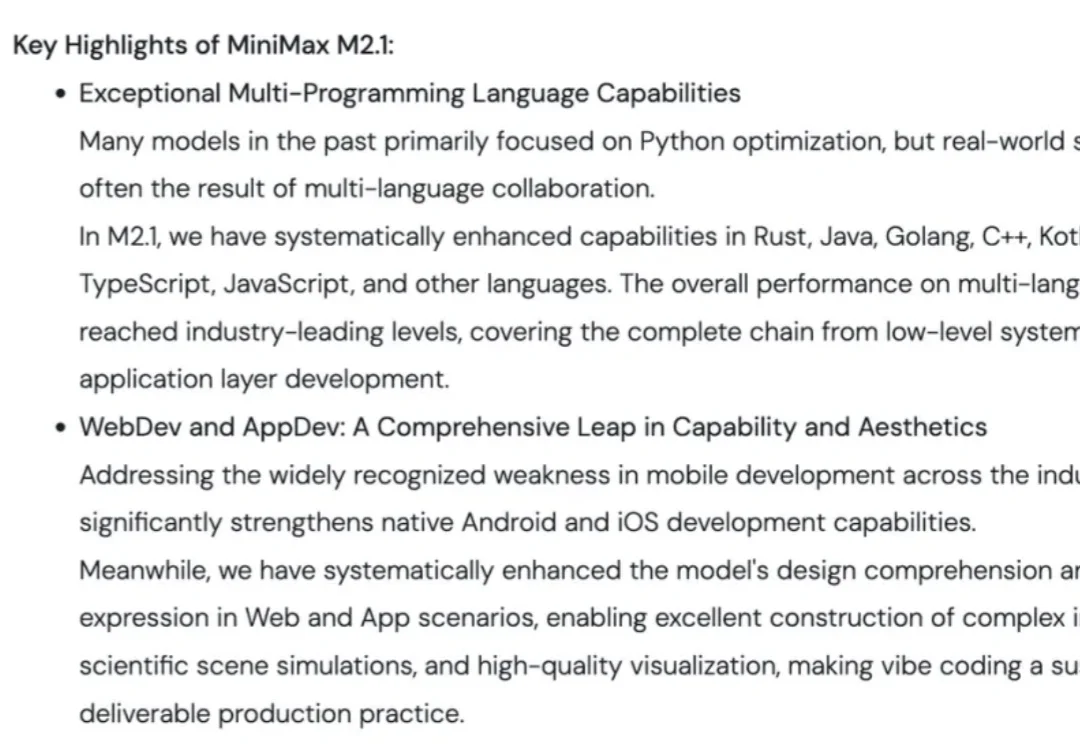

前脚刚听完罗永浩和 MiniMax 创始人闫俊杰的超长播客,然后就看到 MiniMax M2.1 发布了。

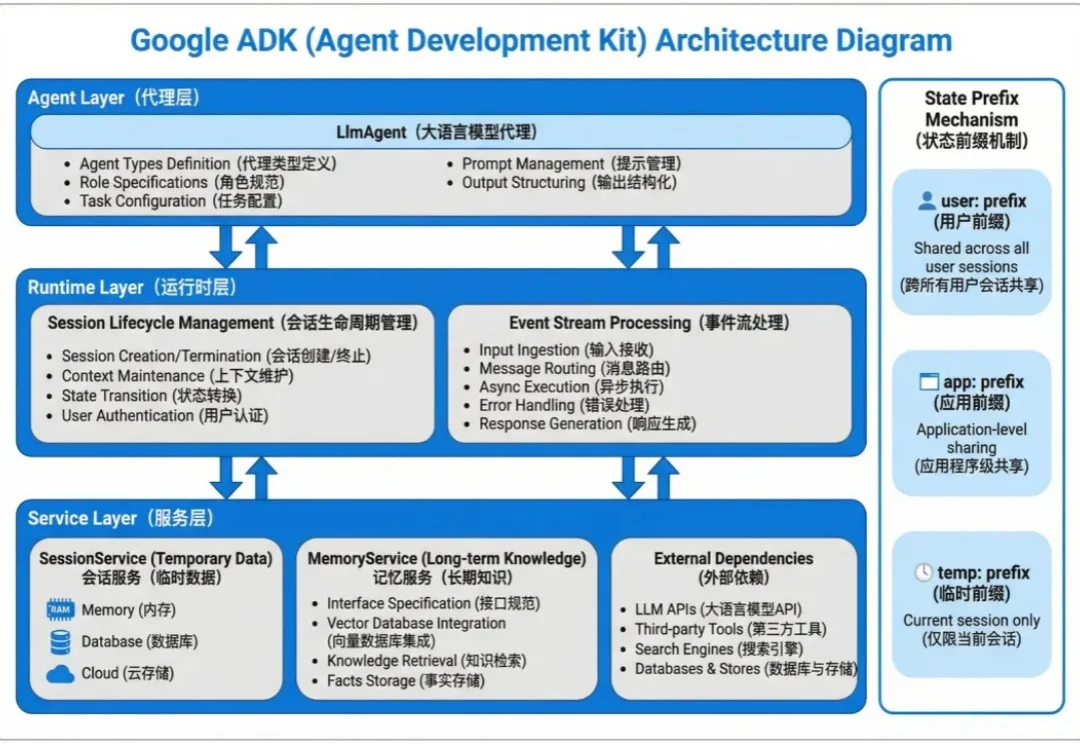

Agent 的状态数据分两种:会话内的临时上下文和跨会话的长期知识。

在生成式AI(GenAI)的推动下,2025年标志着行业从“震撼期”正式步入“深水区”。这并非资本的泡沫,而是计算范式从CPU向GPU的根本性迁移——数据中心正进化为实时生产智能的“AI工厂”。相比于模型参数的单纯竞赛,AI应用带来的“任务执行”能力与直观体验,让人切身感受到从“信息检索”向“智能生成”的范式跃迁。

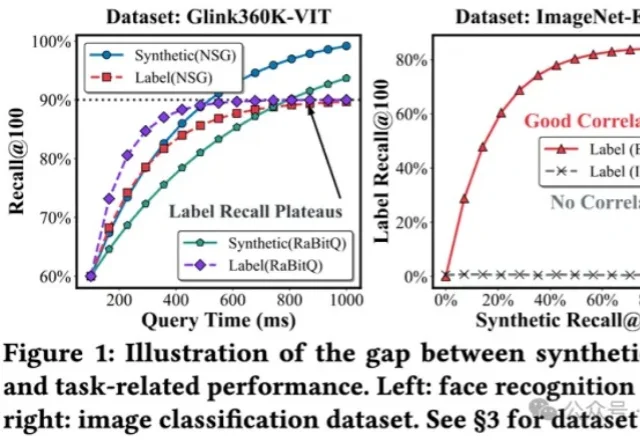

将多模态数据纳入到RAG,甚至Agent框架,是目前LLM应用领域最火热的主题之一,针对多模态数据最自然的召回方式,便是向量检索。

刚刚,由SciMaster团队推出的AI机器学习专家ML-Master 2.0,基于国产开源大模型DeepSeek,在OpenAI权威基准测试MLE-bench中一举击败Google、Meta、微软等国际顶流,刷新全球SOTA,再次登顶!目前该功能已在SciMaster线上平台开放waiting list,欢迎申请体验。

英伟达让AI仅靠「看直播」就学会了通用游戏操作。虚拟世界已成为物理智能的黑客帝国,看4万小时直播学会几乎所有游戏!

Epoch AI年终大盘点来了!出乎意料的是,AI没有停滞,反而变快了。

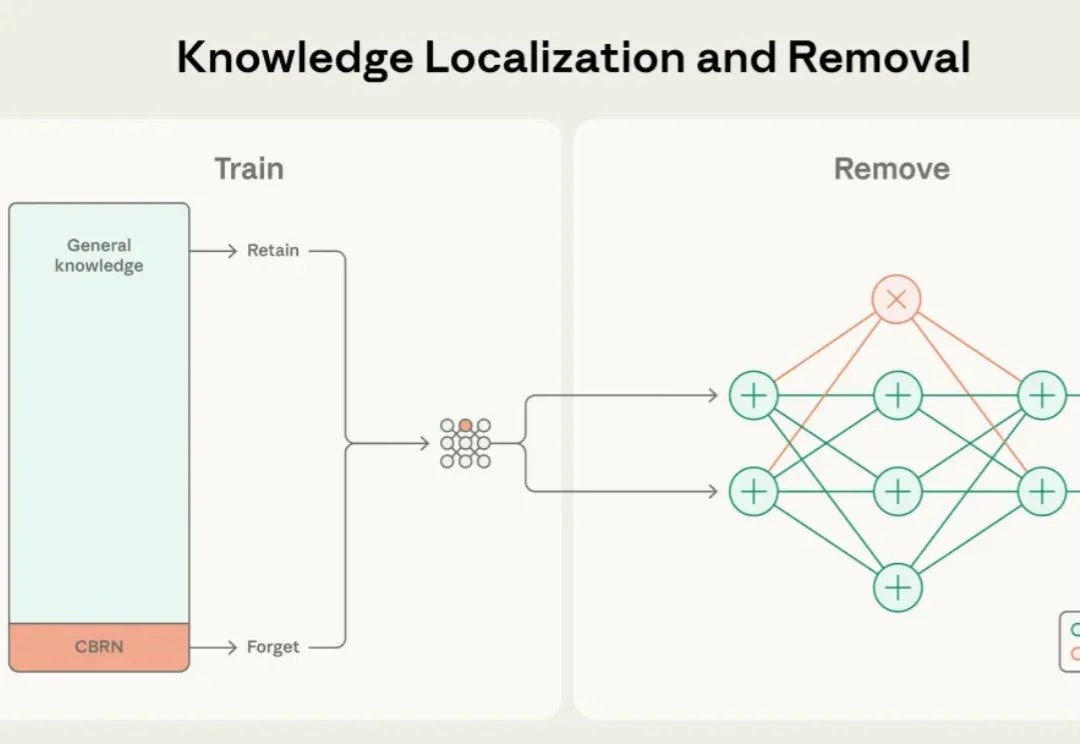

近年来,大语言模型的能力突飞猛进,但随之而来的却是愈发棘手的双重用途风险(dual-use risks)。当模型在海量公开互联网数据中学习时,它不仅掌握语言与推理能力,也不可避免地接触到 CBRN(化学、生物、放射、核)危险制造、软件漏洞利用等高敏感度、潜在危险的知识领域。

智谱作为「大模型第一股」赴港上市前夕,直接掏出了旗舰模型GLM-4.7并开源!

热门LoRA首次内置,控光换镜头实测可用。

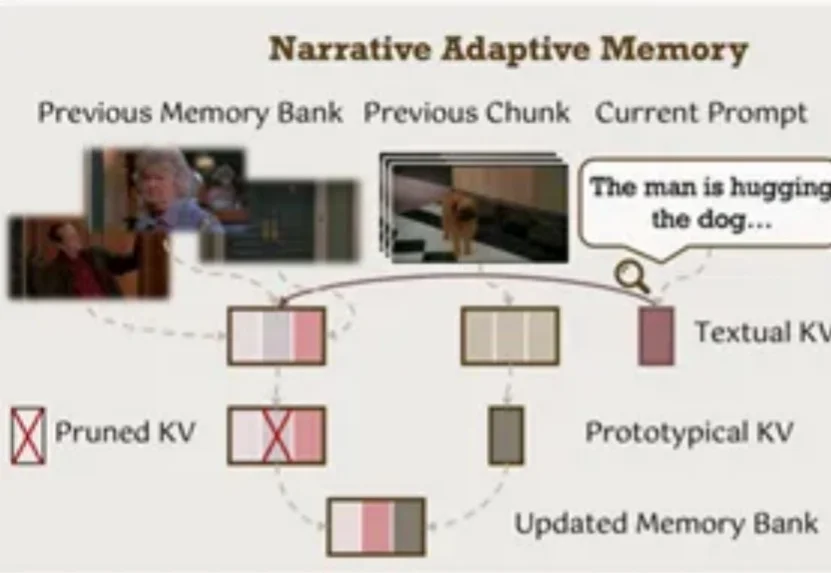

视频生成模型总是「记性不好」?生成几秒钟后物体就变形、背景就穿帮?北大、中大等机构联合发布EgoLCD,借鉴人类「长短时记忆」机制,首创稀疏KV缓存+LoRA动态适应架构,彻底解决长视频「内容漂移」难题,在EgoVid-5M基准上刷新SOTA!让AI像人一样拥有连贯的第一人称视角记忆。

在代码大模型(Code LLMs)的预训练中,行业内长期存在一种惯性思维,即把所有编程语言的代码都视为同质化的文本数据,主要关注数据总量的堆叠。然而,现代软件开发本质上是多语言混合的,不同语言的语法特性、语料规模和应用场景差异巨大。

多模态大语言模型(MLLMs)已成为AI视觉理解的核心引擎,但其在真实世界视觉退化(模糊、噪声、遮挡等)下的性能崩溃,始终是制约产业落地的致命瓶颈。

你是否曾被AI视频生成的不连贯性所困扰?

还记得几个月前那个能随着音乐节拍自然舞动的 KlingAvatar 数字人吗?现在,它迎来了史诗级进化!