深入AI Agent内核: Google gemini-cli 源码深度解构

深入AI Agent内核: Google gemini-cli 源码深度解构随着大语言模型与开发工具链的深度融合,命令行终端正被重塑为开发者的AI协作界面。本文以 Google gemini-cli 为范本,通过源码解构,系统性分析其 Agent 内核、ReAct 工作流、工具调用与上下文管理等核心模块的实现原理。为希望构建终端 Agent 的开发者,提供工程实现的系统化参考。

随着大语言模型与开发工具链的深度融合,命令行终端正被重塑为开发者的AI协作界面。本文以 Google gemini-cli 为范本,通过源码解构,系统性分析其 Agent 内核、ReAct 工作流、工具调用与上下文管理等核心模块的实现原理。为希望构建终端 Agent 的开发者,提供工程实现的系统化参考。

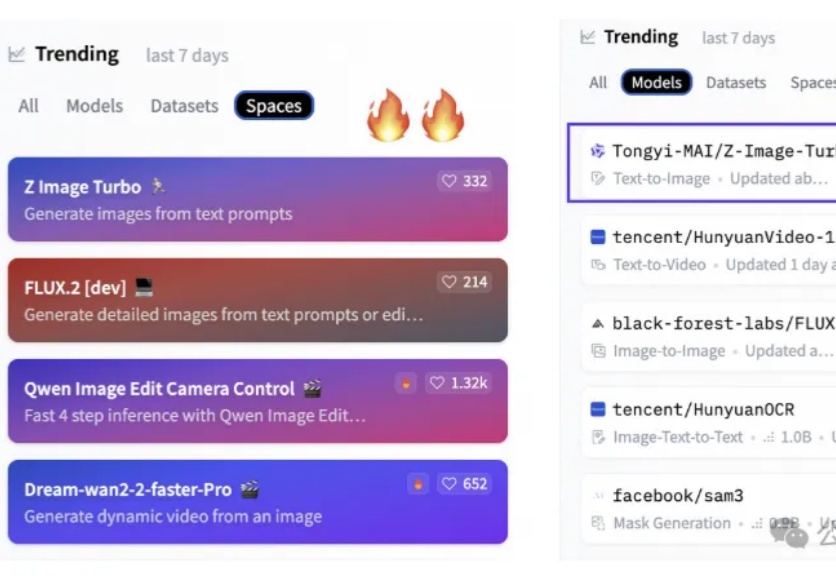

6B小模型,首日下载量高达50万次,上线不到两天直接把HuggingFace两个榜单都冲了个第一。

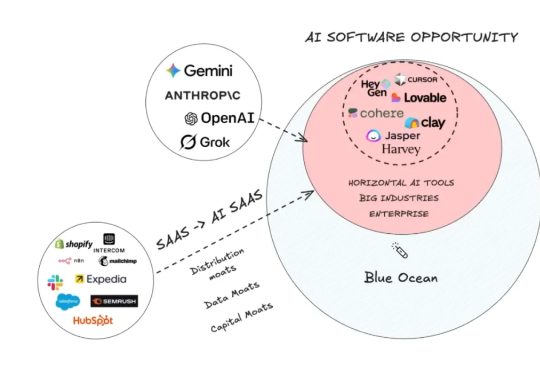

为什么 AI 让小众市场突然变得值钱了!Ben 提出了一个非常关键的洞察:软件革命催生了 6500 亿美元的软件市场,但 AI 是第一个真正能够自动化劳动力的技术,这意味着我们现在面对的是一个 10 万亿美元的劳动力市场,仅在美国就有这么大的规模。到目前为止,只有 0.2% 的劳动力市场被自动化了。这个数字让我震惊,因为它意味着我们还处在这场革命的最初阶段,99.8% 的机会还在等待被发掘。

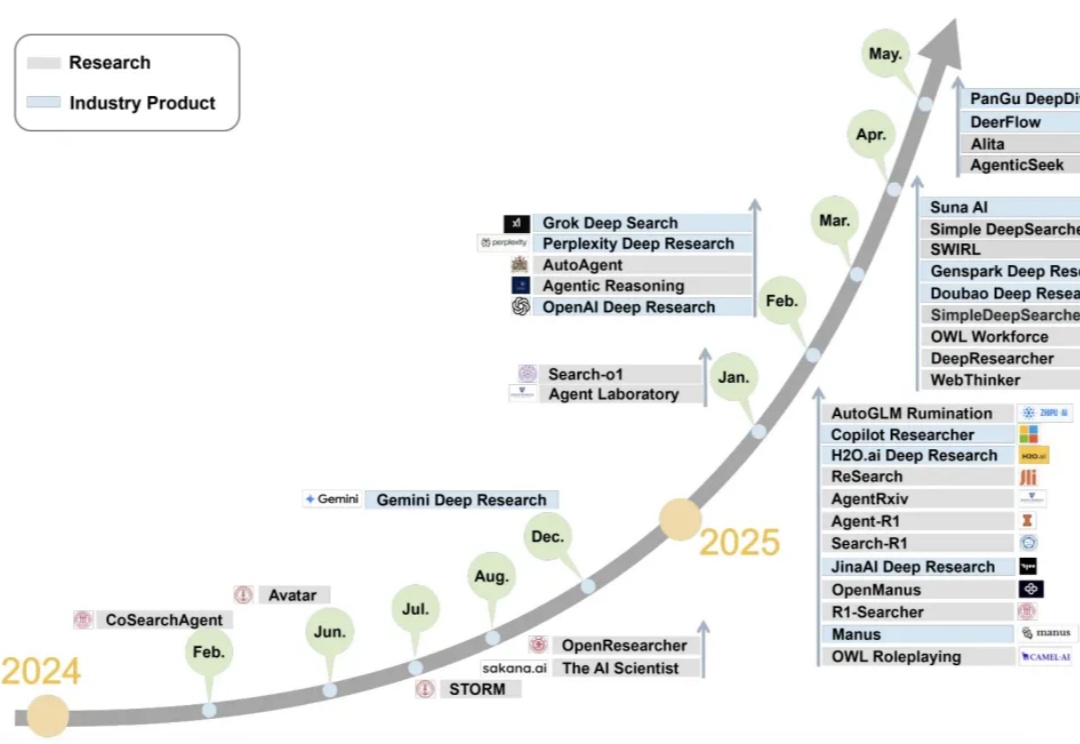

如果AI的终极使命是拓展人类认知的边界,那么“研究”——这项系统性探索未知的核心活动,无疑是其最重要的试金石。2024年,AI Agent技术迎来突破性进展,一个名为 Deep Research(深度研究) 的方向正以前所未有的速度站上风口,成为推动“AI应用元年”的真正引擎。

在当前的情感计算研究中,存在一个显著的“断层”:我们拥有越来越精准的情感识别算法(输入端),也有了逼真的语音和面部生成技术(输出端),但连接这两端的“中间层”却鲜有人问津。机器能识别出你在愤怒,也能模拟出抱歉的语气,但它真的理解愤怒的起因吗?它能基于这种理解去调整后续的决策逻辑吗?

当AI开始学会「摸鱼」,整个行业都该警醒了。

一般人和 ChatGPT 聊天时,往往不会在意要不要讲究礼貌。但来自爱荷华大学的一项最新研究显示:即便回答内容几乎相同,对 ChatGPT 粗鲁无礼也会让你花费更高的输出成本。

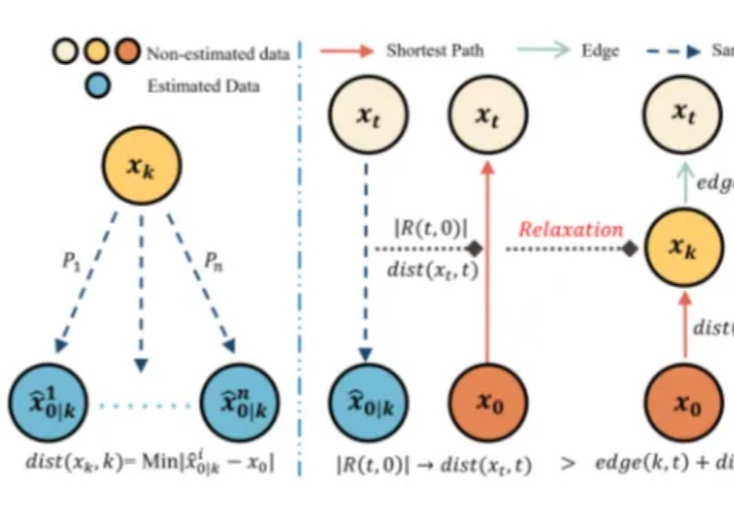

从“在线训练”到“离线建图”,扩散模型速度再突破!

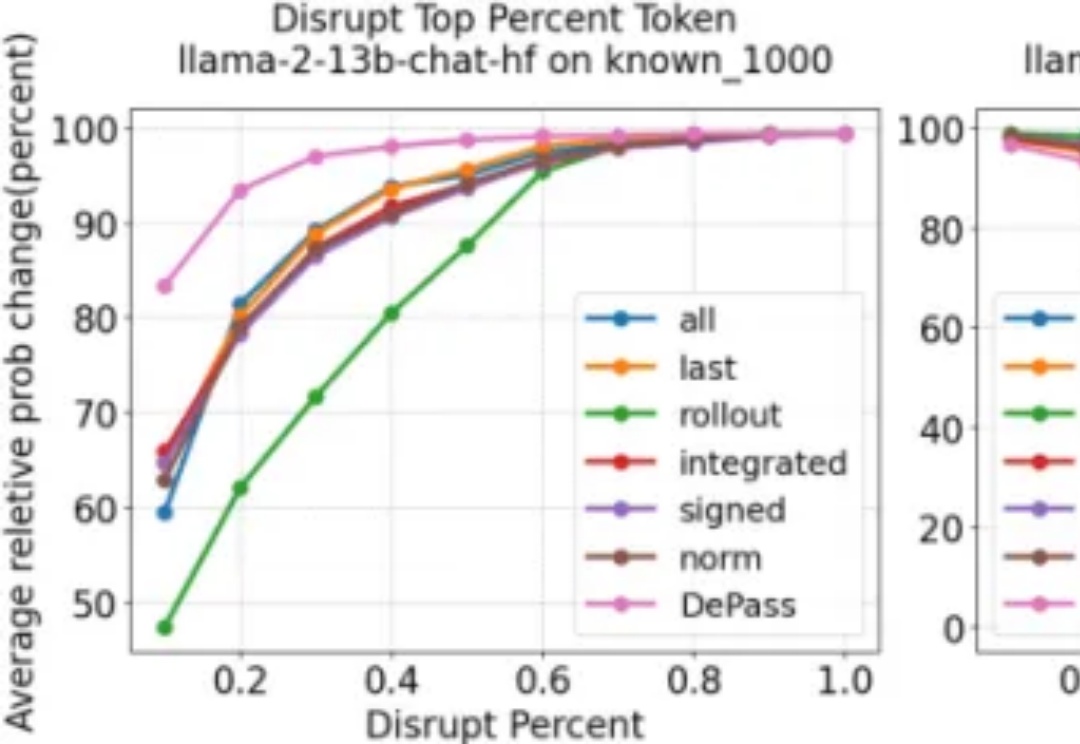

随着大型语言模型在各类任务中展现出卓越的生成与推理能力,如何将模型输出精确地追溯到其内部计算过程,已成为 AI 可解释性研究的重要方向。然而,现有方法往往计算代价高昂、难以揭示中间层的信息流动;同时,不同层面的归因(如 token、模型组件或表示子空间)通常依赖各自独立的特定方法,缺乏统一且高效的分析框架。

Hi,早上好。 我是洛小山,和你聊聊 AI 应用的降本增效。

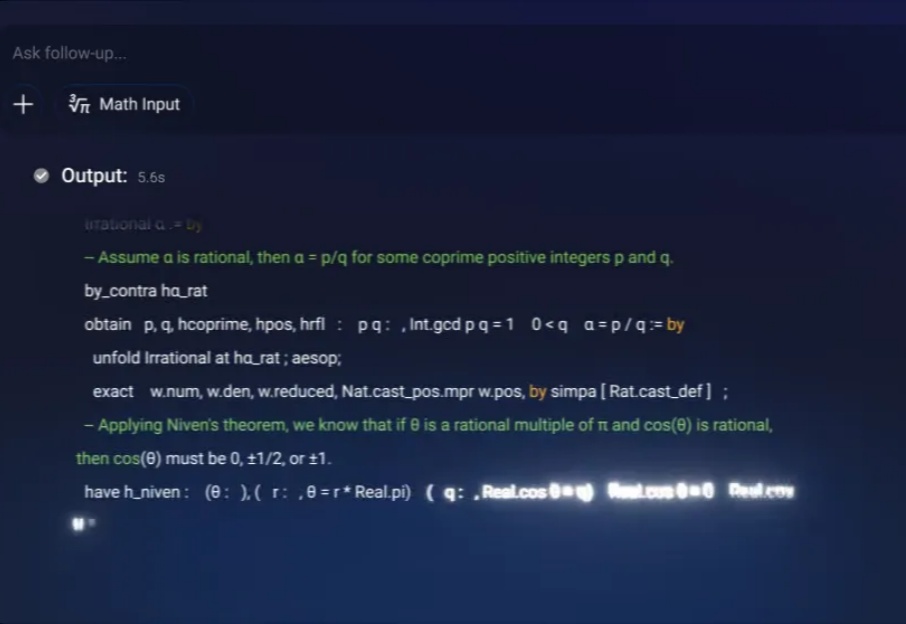

刚刚,Erdos 问题 #124 的一个弱化版本被证明。

我们能否像《头号玩家》那样伸手就能触摸到虚拟世界?像《阿凡达》那样植物和动物仿佛就在眼前飞舞?这不再只是科幻。11 月 26 日,在一篇最新 Nature 论文中,来自复旦大学团队和上海人工智能实验室的研究人员打造出一款名为 EyeReal 的裸眼 3D 显示器。

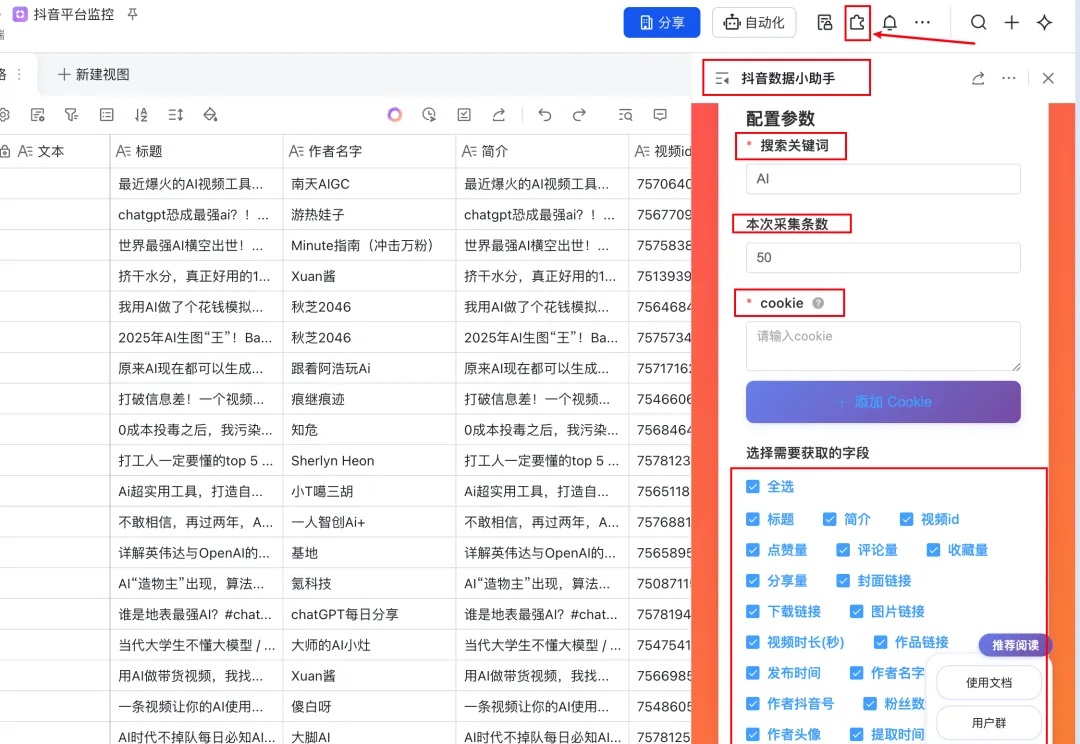

你好,我是袋鼠帝 我最近几乎天天都在用飞书多维表格,使用频率贼高,这玩意儿用起来是真滴爽。

观猹社区里聚集着一群富有创意、动手能力又特别强的创造者。他们来自不同的行业和背景,却在这里形成了某种微妙的共识:认真做产品、诚实写评价、乐于分享想法。

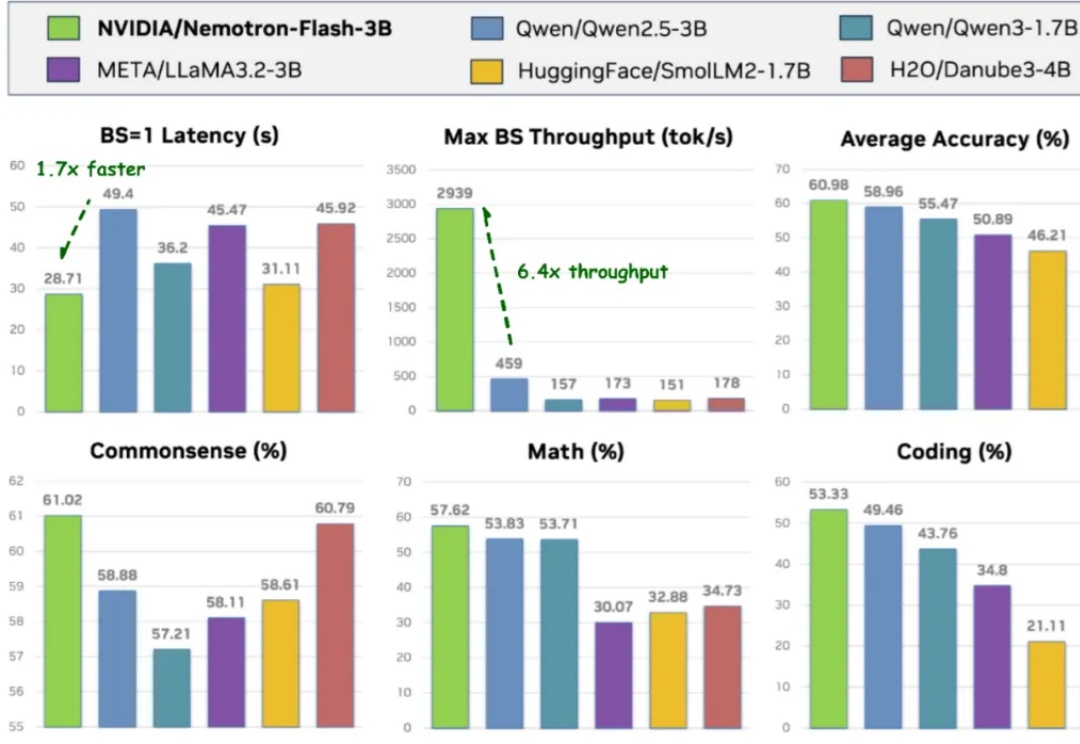

导读 过去两年,小语言模型(SLM)在业界备受关注:参数更少、结构更轻,理应在真实部署中 “更快”。但只要真正把它们跑在 GPU 上,结论往往令人意外 —— 小模型其实没有想象中那么快。

在大语言模型(LLM)的研究浪潮中,绝大多数工作都聚焦于优化模型的输出分布 —— 扩大模型规模、强化分布学习、优化奖励信号…… 然而,如何将这些输出分布真正转化为高质量的生成结果 —— 即解码(decoding)阶段,却没有得到足够的重视。

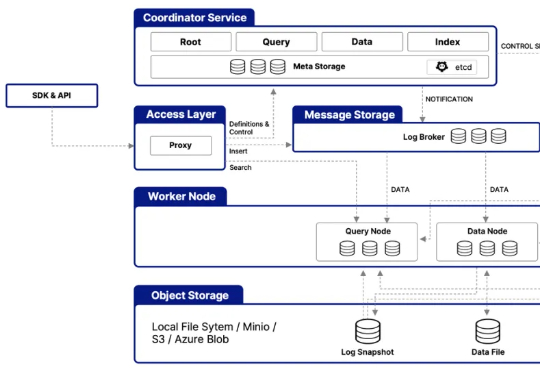

在架构层面,Milvus 2.6 大幅简化系统架构,整合多个核心组件 —— 例如将原有的 Coordinator 组件(含 RootCoord、QueryCoord、DataCoord)统一整合为 MixCoord,并将 IndexNode 与 DataNode 合并为单一组件。这些调整不仅降低了系统复杂度,更显著提升了系统的可维护性与横向扩展性。

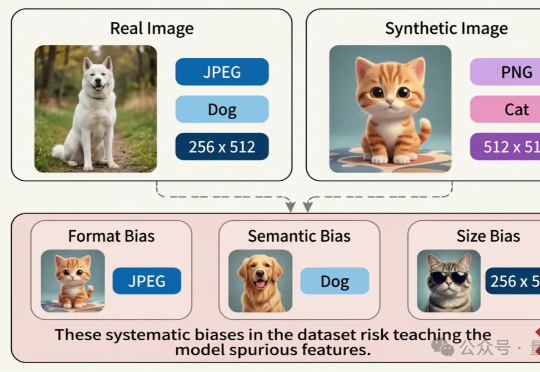

近日,腾讯优图实验室联合华东理工大学、北京大学等研究团队在A生成图像检测(AI-Generated Image Detection)泛化问题上展开研究,提出Dual Data Alignment(双重数据对齐,DDA)方法,从数据层面系统性抑制“偏差特征”,显著提升检测器在跨模型、跨数据域场景下的泛化能力。

本文第一作者为刘禹宏,上海交通大学人工智能专业本科四年级学生,相关研究工作于上海人工智能实验室科研实习期间完成。通讯作者为王佳琦、臧宇航,在该研究工作完成期间,均担任上海人工智能实验室研究员。

a16z 指出:“模型开发的进展正在简化整个基础设施栈,使得语音智能体具备更低延迟和更高性能。这一提升主要出现在过去六个月内,得益于新一代对话模型的出现。”基于这些趋势,Deepgram 与 Opus Research 合作开展的《2025 语音 AI 状况调查报告》,基于 400 位商业领袖的洞察,涵盖十多个行业,分析了语音 AI 的应用现状与关键特性。

CB Insights 发布的《2025 Future Tech Hotshots:Scouting Reports》报告,结合生成式 AI 分析与专有 Mosaic 评分体系,从全球海量初创企业中遴选出 45 家最具潜力的科技公司。

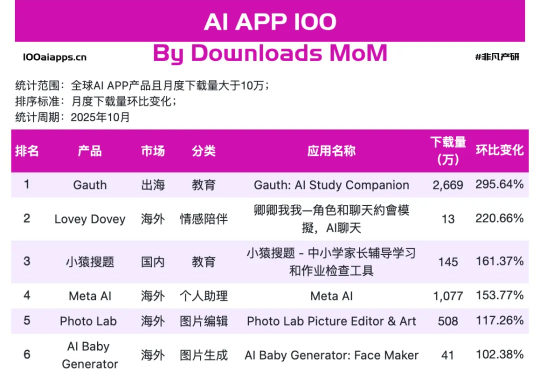

但当我们把视线从焦点模型上,挪到手机里AI应用真实数据上,就会发现一幅不同的画面。可以看到在非凡产研 10 月 AI App 增速榜上,跑得最快的那 17 个,并不是万事皆可聊的通用助手,而是一群看上去有点普通、甚至有点土气的小应用,其中Gauth、Starry、Knowunity、AI Baby Generator已经连续两个月上榜了。

人工智能研究的最新目标,尤其是在追求“通用人工智能”(AGI)的实验室中,是一个被称为“世界模型”(world model)的概念:这是一种AI内部携带的环境表征,就像一个计算型的雪球玻璃球。AI系统可以借助这个简化的内部模型,在真正执行任务之前,先对预测和决策进行评估。

大模型推理的爆发,实际源于 scaling 范式的转变:从 train-time scaling 到 test-time scaling(TTS),即将更多的算力消耗部署在 inference 阶段。典型的实现是以 DeepSeek r1 为代表的 long CoT 方法:通过增加思维链的长度来获得答案精度的提升。那么 long CoT 是 TTS 的唯一实现吗?

智东西11月28日报道,刚刚,快手开源其新一代旗舰多模态大模型Keye-VL-671B-A37B。该模型基于DeepSeek-V3-Terminus打造,拥有6710亿个参数,在保持基础模型通用能力的前提下,对视觉感知、跨模态对齐与复杂推理链路进行了升级,实现了较强的多模态理解和复杂推理能力。

而今天,来自 UIUC、华盛顿大学等机构的一群研究人员,通过一篇重磅论文《推理的认知基础及其在大型语言模型中的体现》,为这个“认知鸿沟”画出了一张精确的微观解剖图。

REG 是一种简单而有效的方法,仅通过引入一个 class token 便能大幅加速生成模型的训练收敛。其将基础视觉模型(如 DINOv2)的 class token 与 latent 在空间维度拼接后共同加噪训练,从而显著提升 Diffusion 的收敛速度与性能上限。在 ImageNet 256×256 上,

腾讯混元大模型团队正式发布并开源HunyuanOCR模型!这是一款商业级、开源且轻量(1B参数)的OCR专用视觉语言模型,模型采用原生ViT和轻量LLM结合的架构。目前,该模型在抱抱脸(Hugging Face)趋势榜排名前四,GitHub标星超过700,并在Day 0被vllm官方团队接入。

RAG效果不及预期,试试这10个上下文处理优化技巧。对大部分开发者来说,搭一个RAG或者agent不难,怎么把它优化成生产可用的状态最难。在这个过程中,检索效率、准确性、成本、响应速度,都是重点关注问题。

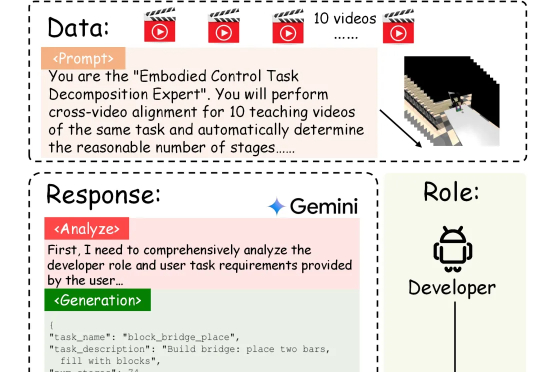

具身智能的「ChatGPT时刻」还没到,机器人的「幻觉」却先来了?在需要几十步操作的长序列任务中,现有的VLA模型经常「假装在干活」,误以为任务完成。针对这一痛点,北京大学团队提出自进化VLA框架EvoVLA。该模型利用Gemini生成「硬负样本」进行对比学习,配合几何探索与长程记忆,在复杂任务基准Discoverse-L上将成功率提升了10.2%,并将幻觉率从38.5%大幅降至14.8%。