破解机器人「慢半拍」难题:南洋理工解决VLA致命短板,动态世界断层领先

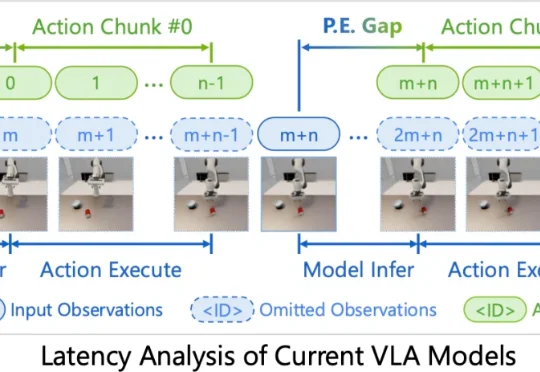

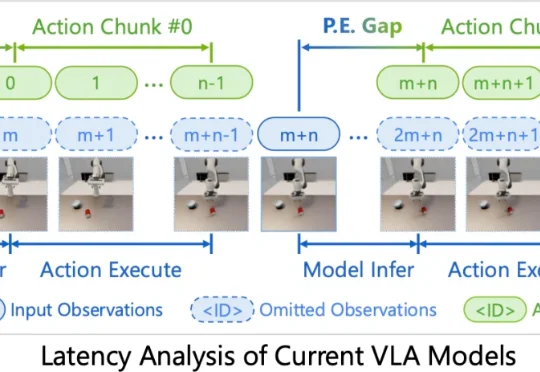

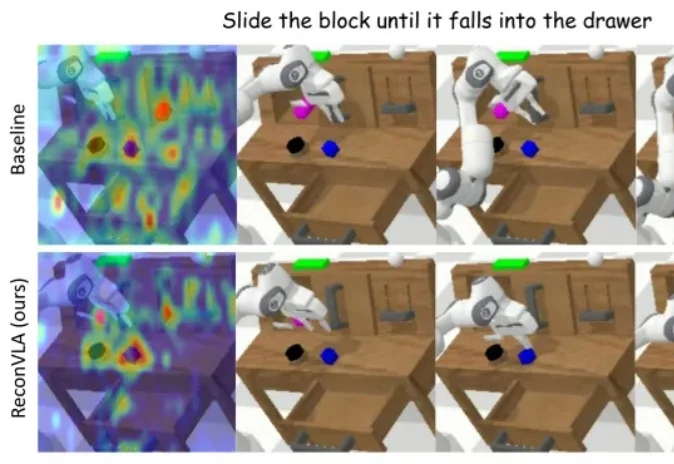

破解机器人「慢半拍」难题:南洋理工解决VLA致命短板,动态世界断层领先当物体在滚动、滑动、被撞飞,机器人还在执行几百毫秒前的动作预测。对动态世界而言,这种延迟,往往意味着失败。

当物体在滚动、滑动、被撞飞,机器人还在执行几百毫秒前的动作预测。对动态世界而言,这种延迟,往往意味着失败。

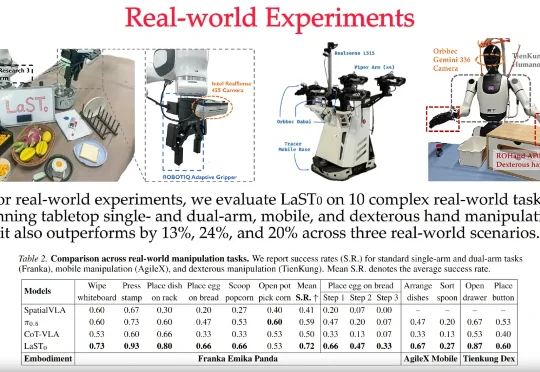

LaST₀团队 投稿 量子位 | 公众号 QbitAI 近日,至简动力、北京大学、香港中文大学、北京人形机器人创新中心提出了一种名为LaST₀的全新隐空间推理VLA模型,在基于Transformer混

不做 VLA;不做遥操,以可穿戴设备采真实数据。

从3000小时到整整20000小时。

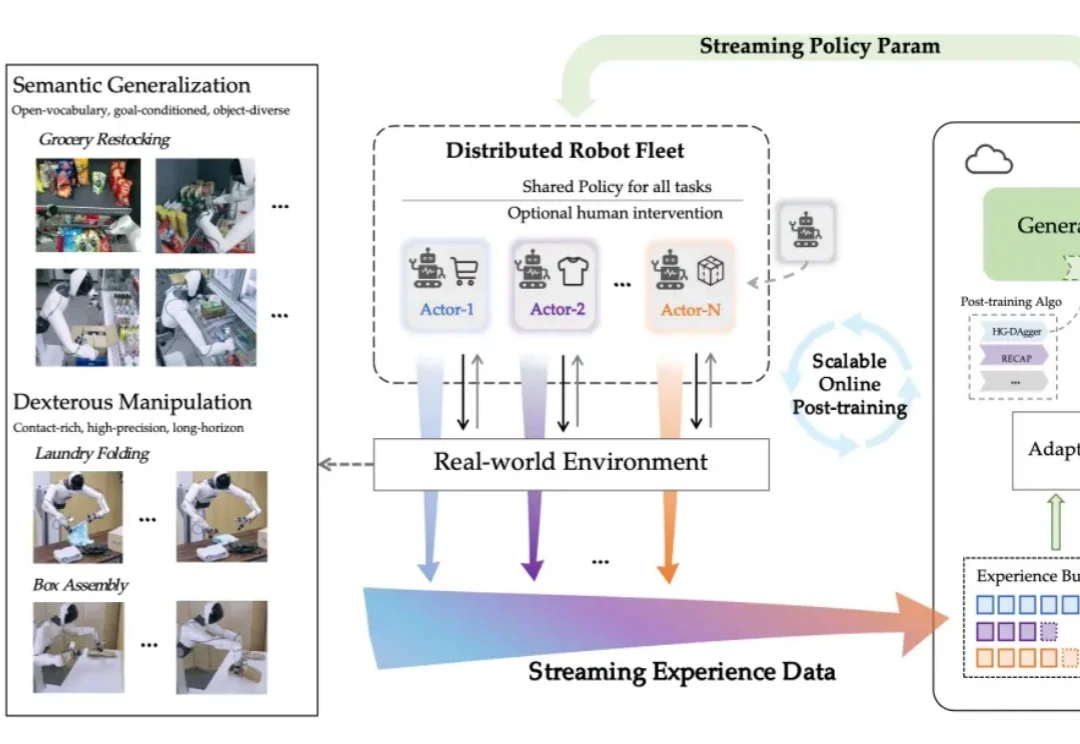

在长期以来的 AI 研究版图中,具身智能虽然在机器人操作、自动化系统与现实应用中至关重要,却常被视为「系统工程驱动」的研究方向,鲜少被认为能够在 AI 核心建模范式上产生决定性影响。

全球榜单中唯一成功率超过50%的模型。今日,千寻智能正式开源自研VLA基础模型Spirit v1.5,就在前一天,该模型在全球具身智能模型评测平台RoboChallenge上,综合评测斩获第一。

对于电子产品,我们已然习惯了「出厂即巅峰」的设定:开箱的那一刻往往就是性能的顶点,随后的每一天都在折旧。

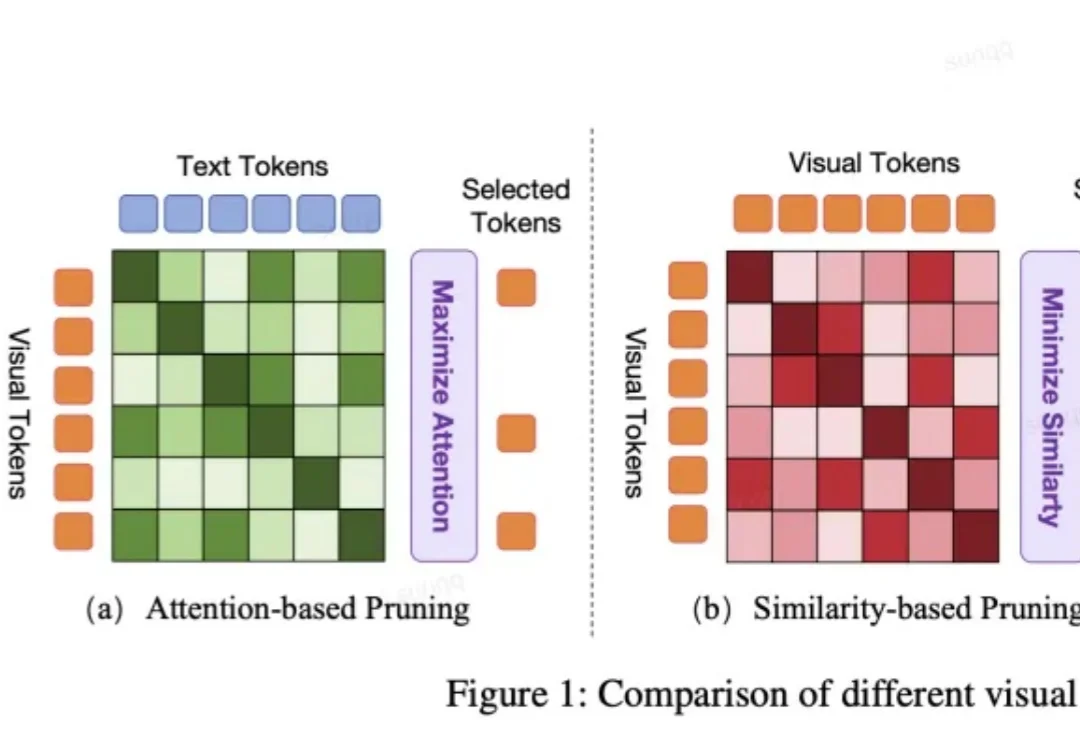

VLA 模型正被越来越多地应用于端到端自动驾驶系统中。然而,VLA 模型中冗长的视觉 token 极大地增加了计算成本。但现有的视觉 token 剪枝方法都不是专为自动驾驶设计的,在自动驾驶场景中都具有局限性。

坏事儿了,中国Kung fu,好像真被机器人学走了!摊手、膀手、伏手、挥拳,一套咏春拳下来,我当场愣住,妥妥机器人届的叶问啊:这个手脚灵活到有点过分的小小机器人,正是逐际动力推出的多形态具身机器人TRON 2,起售价4.98万元,即日起正式开启预售。

视觉–语言–动作(VLA)模型在机器人场景理解与操作上展现出较强的通用性,但在需要明确目标终态的长时序任务(如乐高搭建、物体重排)中,仍难以兼顾高层规划与精细操控。