8.7万亿!史上最贵独角兽诞生,SpaceX正式官宣收购AI大模型独角兽xAI!

8.7万亿!史上最贵独角兽诞生,SpaceX正式官宣收购AI大模型独角兽xAI!今天,马斯克旗下商业航天巨头SpaceX正式官宣收购马斯克AI大模型独角兽xAI!据外媒报道,知情人士透露,SpaceX以2500亿美元(约合人民币1.7万亿)股票收购了xAI,合并后SpaceX的估值达到1.25万亿美元(约合人民币8.68万亿元)。

今天,马斯克旗下商业航天巨头SpaceX正式官宣收购马斯克AI大模型独角兽xAI!据外媒报道,知情人士透露,SpaceX以2500亿美元(约合人民币1.7万亿)股票收购了xAI,合并后SpaceX的估值达到1.25万亿美元(约合人民币8.68万亿元)。

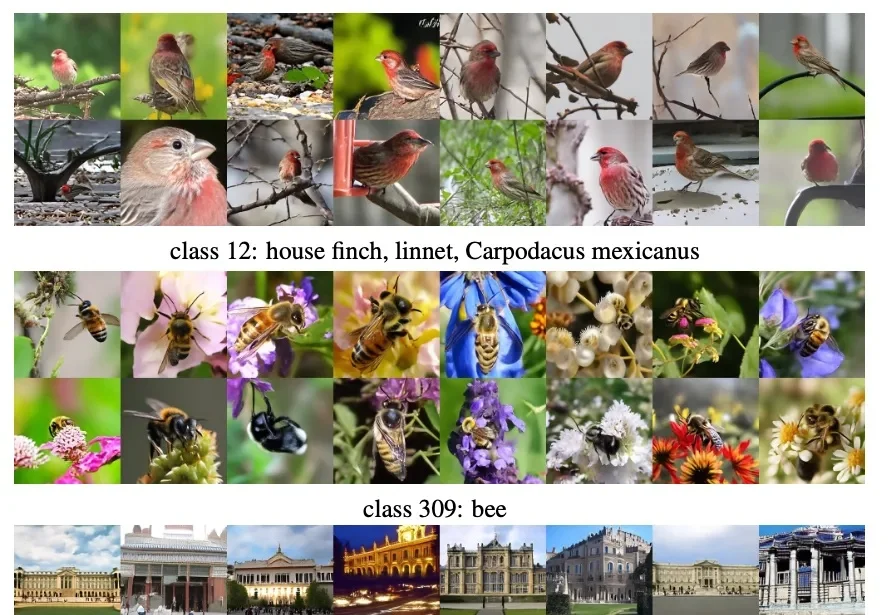

AI,是色盲吗?

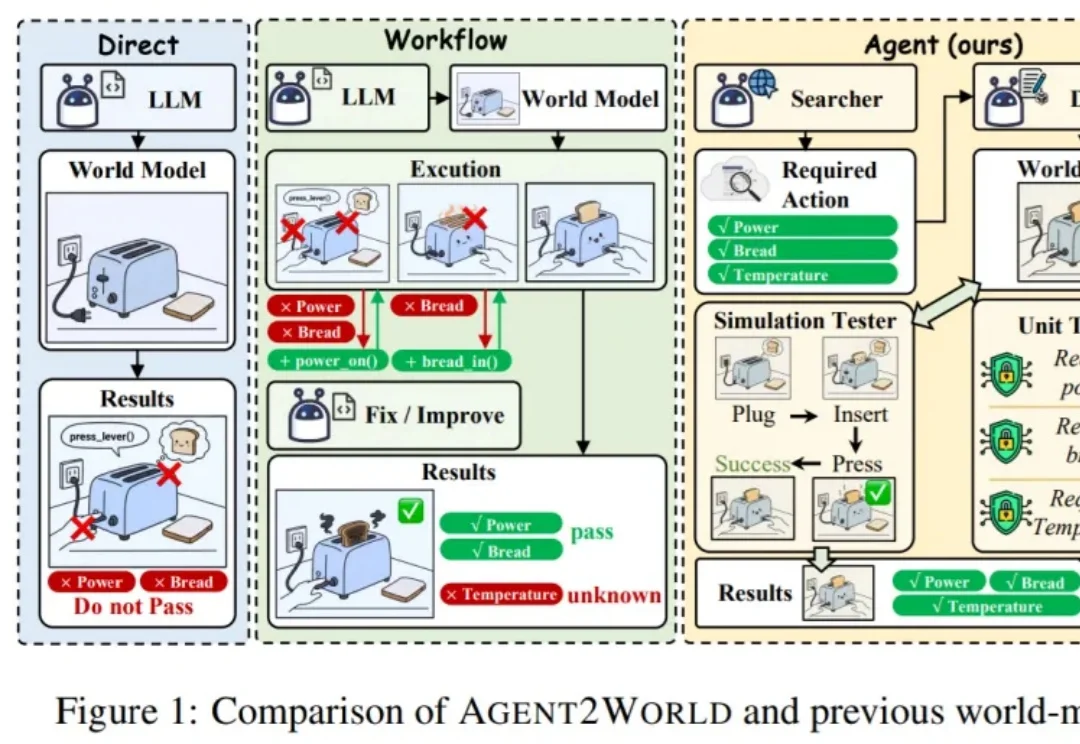

让模型真正 “能行动”,往往需要一个可执行、可验证的符号世界模型(Symbolic World Model):它不是抽象的文字描述,而是能被规划器或执行器直接调用的形式化定义 —— 例如 PDDL 领域 / 问题,或可运行的环境代码 / 模拟器。

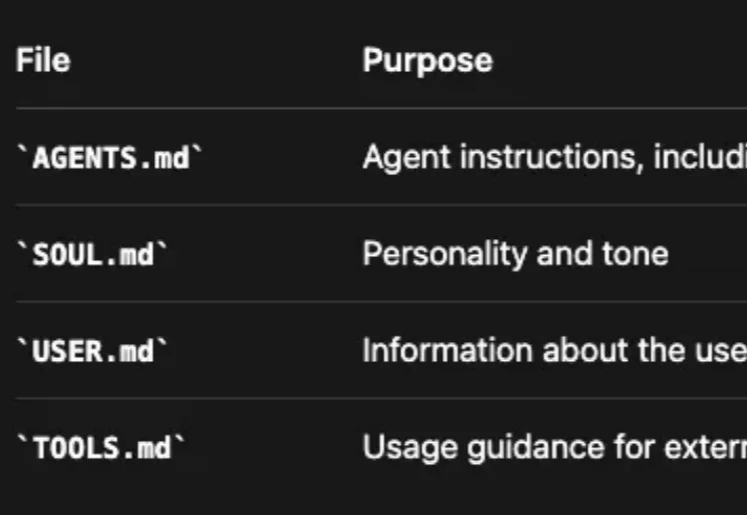

Clawdbot(现改名为 OpenClaw) 体验下来,持久的记忆管理系统很是让人惊艳——全天候保持上下文,无限期地记住对话并在此基础上持续深化互动。

何恺明,再次出手精简架构。

OpenClaw、Moltbook彻底火了。

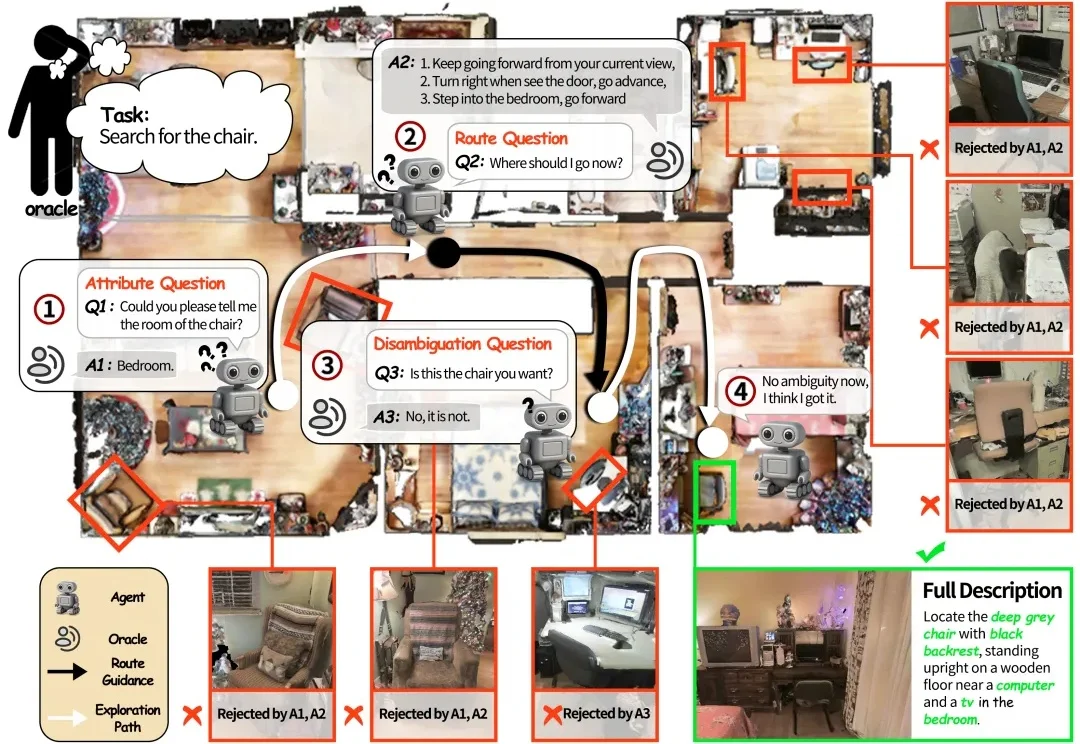

如果将一台在视觉语言导航(VLN)任务中表现优异的机器人直接搬进家庭场景,往往会遇到不少实际问题。

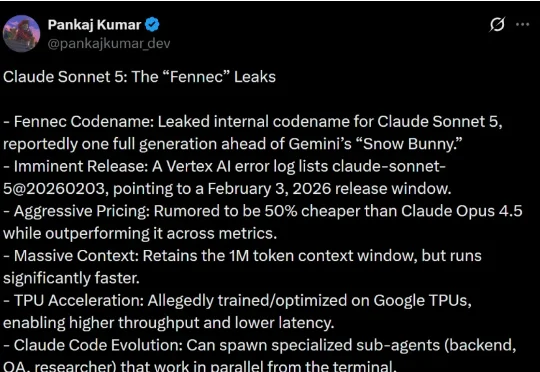

2月2日,X上一位的知名AI博主Pankaj Kumar (@pankajkumar_dev),爆料了Anthropic的下一代旗舰模型Claude Sonnet 5。这个模型代号为“Fennec”,可能在明天或者后天就要正式发布了。

就在刚刚,据《南华早报》援引知情人士最新消息,智谱 AI 计划在未来两周内,也就是春节前发布其新旗舰模型 GLM-5。与此同时,MiniMax 也预计将于春节前发布 M2.2 模型,这是在原有 M2.1 基础上进行的小幅更新,重点提升编程能力。

今日,阶跃星辰Step 3.5 Flash开源并上线,该模型在Agent场景和数学任务上能力逼近闭源模型,能够胜任复杂、长链条任务,是阶跃星辰迄今最强的开源基座模型。就在上周,阶跃星辰宣布由旷视科技联合创始人、千里科技董事长印奇正式出任董事长,并完成华勤、腾讯等参投的超50亿元B+轮融资。这也是印奇履新后,阶跃星辰在开源模型领域的首个大动作。