谷歌最新版「深度研究」反击GPT-5.2

谷歌最新版「深度研究」反击GPT-5.2昨夜,OpenAI用专家级GPT-5.2复仇Gemini 3成功!而在GPT-5.2发布前一个多小时,谷歌就率先推出全新版Gemini Deep Research Agent。谷歌对Gemini深度研究进行了重新构想,使其比以往任何时候都更加强大。

昨夜,OpenAI用专家级GPT-5.2复仇Gemini 3成功!而在GPT-5.2发布前一个多小时,谷歌就率先推出全新版Gemini Deep Research Agent。谷歌对Gemini深度研究进行了重新构想,使其比以往任何时候都更加强大。

我们以为语言是语法、规则、结构。但最新的Nature研究却撕开了这层幻觉。GPT的层级结构与竟与人大脑里的「时间印记」一模一样。当浅层、中层、深层在脑中依次点亮,我们第一次看见:理解语言,也许从来不是解析,而是预测。

白铂 博士,华为 2012 实验室理论研究部主任 信息论首席科学家

今日凌晨,比OpenAI早一个小时,谷歌甩出了3个Agent大招:Deep Research Agent功能更新,并首次向开发者开放;开源新网络研究Agent基准DeepSearchQA,旨在测试Agent在网络研究任务中的全面性;推出新交互API(Interactions API)。

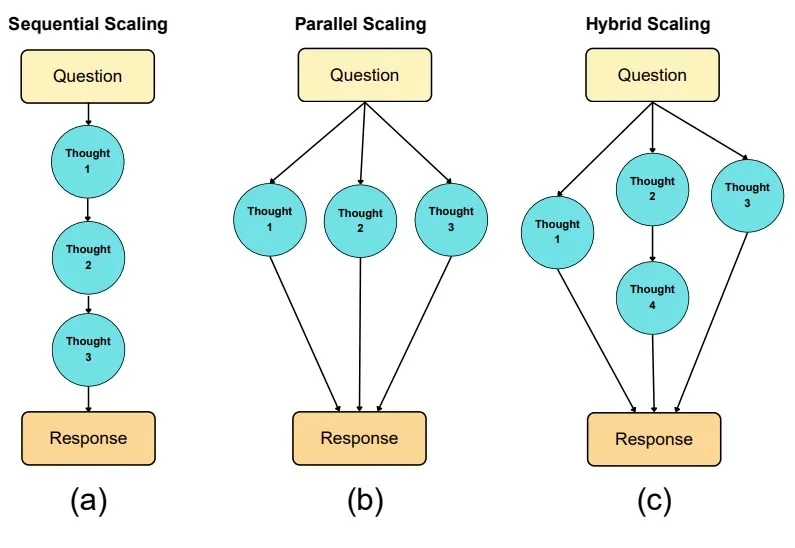

如果说大模型的预训练(Pre-training)是一场拼算力、拼数据的「军备竞赛」,那么测试时扩展(Test-time scaling, TTS)更像是一场在推理阶段进行的「即时战略游戏」。

有关大语言模型的理论基础,可能要出现一些改变了。

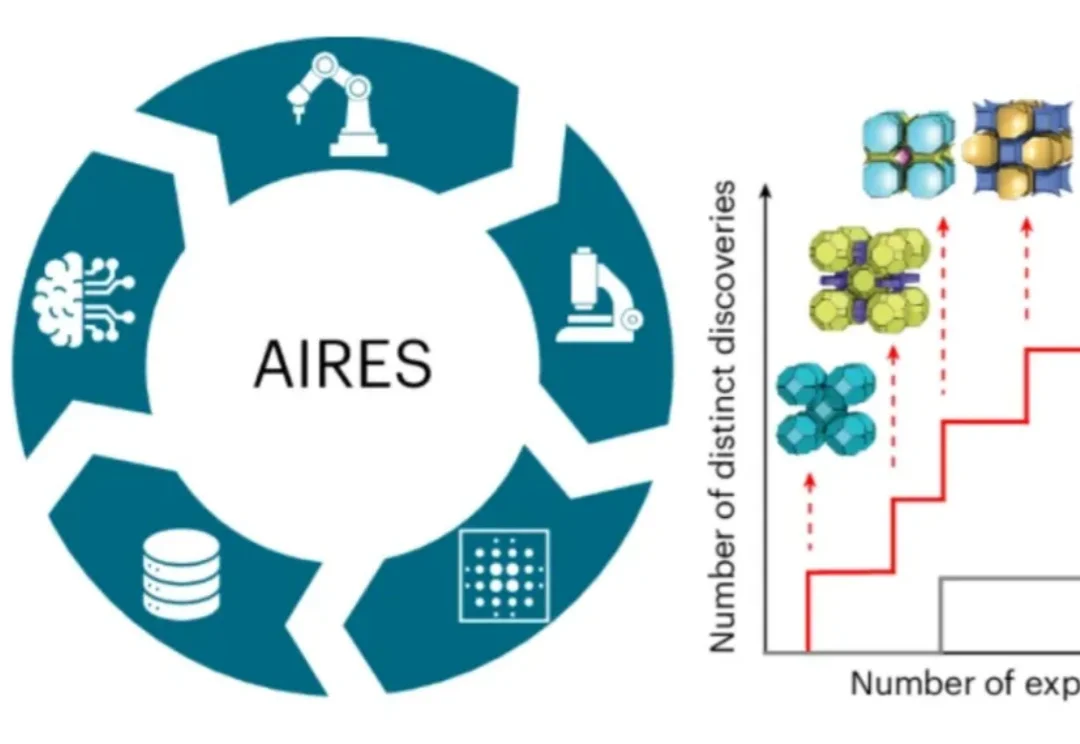

近日,师从新晋诺贝尔化学奖得主奥马尔·亚吉(Omar M. Yaghi)、目前在美国加州大学伯克利分校读博的荣自超,带领一个跨国际的研究团队,打造出名为AIRES (algorithmic iterative reticular synthesis)的机器学习指导的高通量实验平台,

宾夕法尼亚大学沃顿商学院(The Wharton School)今年发布了一系列名为《Prompting Science Reports》的重磅研究报告。他们选取了2024-2025最常用的模型(如GPT-4o, Claude 3.5 Sonnet, Gemini Pro/Flash等),在极高难度的博士级基准测试(GPQA Diamond)上进行了数万次的严谨测试。

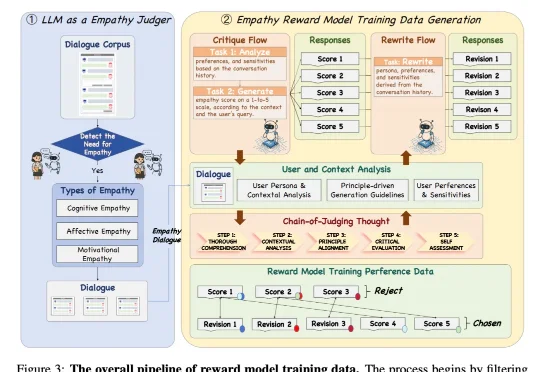

近日,来自 NatureSelect(自然选择)的研究团队 Team Echo 发布了首个情感大模型 Echo-N1,提出了一套全新的「情感模型训练方法」,成功将 RL 用在了不可验证的主观情感领域。仅 32B 参数的 Echo-N1,在多轮情感陪伴任务中胜率(Success Rate)达到 46.7%。作为对比,

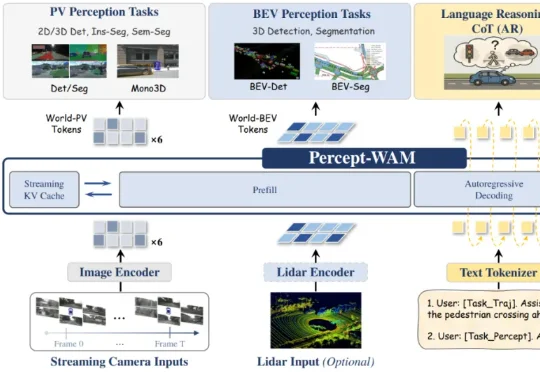

近日,来自引望智能与复旦大学的研究团队联合提出了一个面向自动驾驶的新一代大模型 ——Percept-WAM(Perception-Enhanced World–Awareness–Action Model)。该模型旨在在一个统一的大模型中,将「看见世界(Perception)」「理解世界(World–Awareness)」和「驱动车辆行动(Action)」真正打通,形成一条从感知到决策的完整链路。