中英双语、29项第一、像素级理解:360 FG-CLIP2登顶全球最强图文跨模态模型

中英双语、29项第一、像素级理解:360 FG-CLIP2登顶全球最强图文跨模态模型这年头,AI 创造的视觉世界真是炫酷至极。但真要跟细节较真儿,这些大模型的「眼力见儿」可就让人难绷了。

这年头,AI 创造的视觉世界真是炫酷至极。但真要跟细节较真儿,这些大模型的「眼力见儿」可就让人难绷了。

在日常使用电脑时,看着屏幕、点击鼠标是再自然不过的基本操作。但这种对人类明明很容易的操作方式,却成为 AI 的巨大挑战:它们视力差、动作慢、不擅长看也不擅长点。

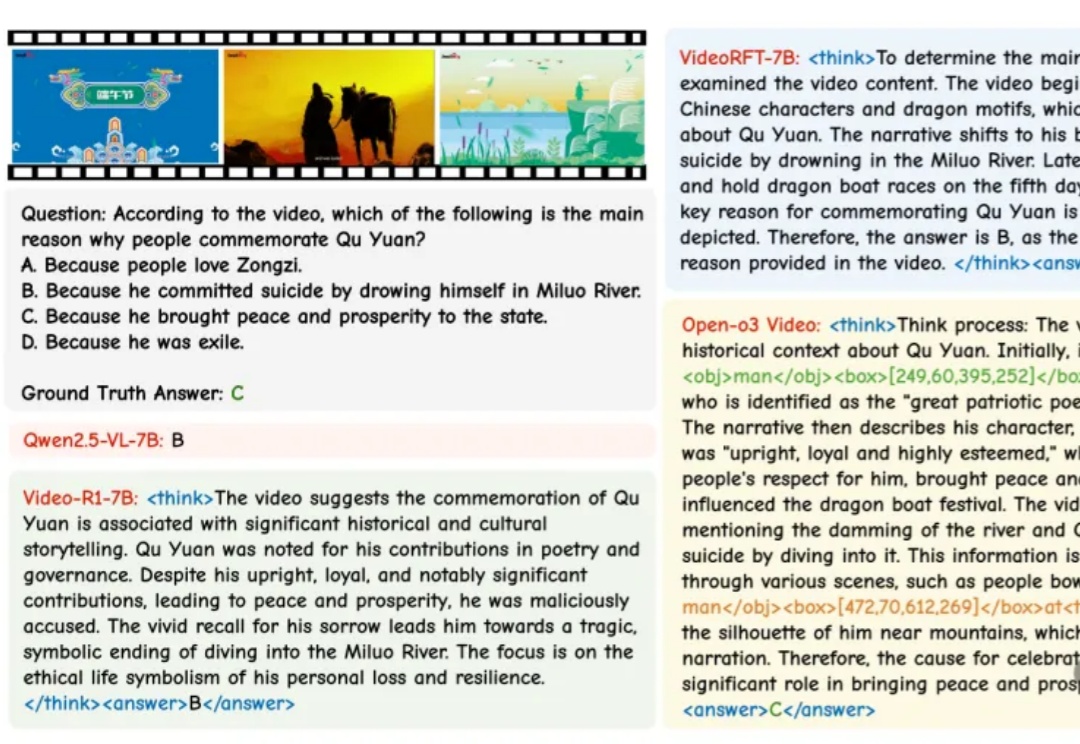

AI看视频也能划重点了!

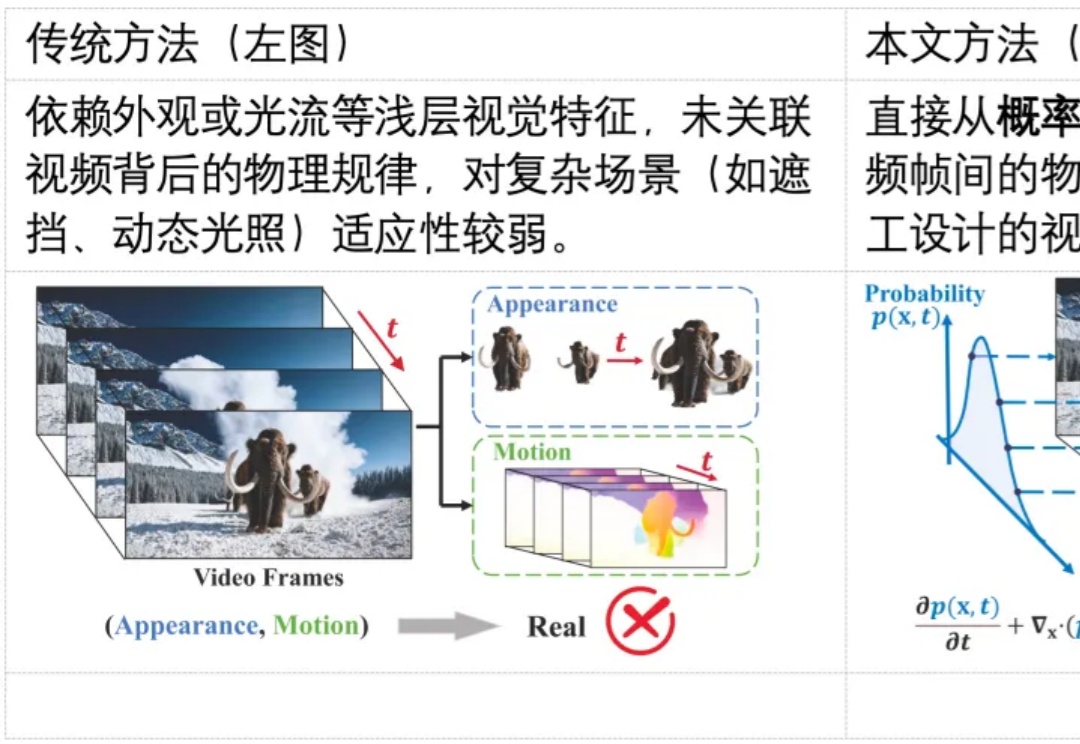

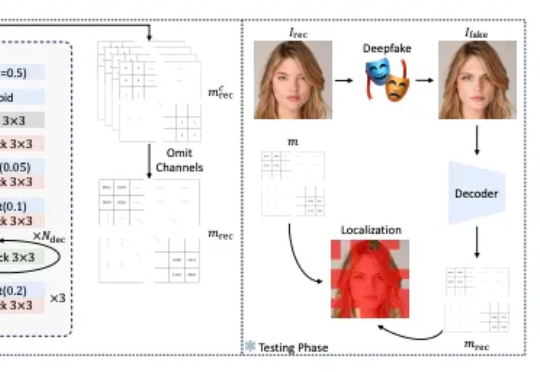

随着生成式 AI(如 Sora)的发展,合成视频几乎可以以假乱真,带来了深度伪造与虚假信息传播的风险。现有检测方法多依赖表层伪影或数据驱动学习,难以在高质量生成视频中保持较好的泛化能力。其根本原因在于,这些方法大都未能充分利用自然视频所遵循的物理规律,挖掘自然视频的更本质的特征。

陶哲轩让ChatGPT把复杂的数学论文翻译成Lean代码,与AI合作完成形式化证明。AI能理解论文、写出正确命题,却常在关键处卡壳。经过人机配合,终于生成1125行被验证的证明。

如果你也在做 RAG 或智能体应用,大概经历过这些瞬间:文档切得太碎,答案失去上下文;切得太大,又召回不准;加了更多提示词,效果可能更不稳定。

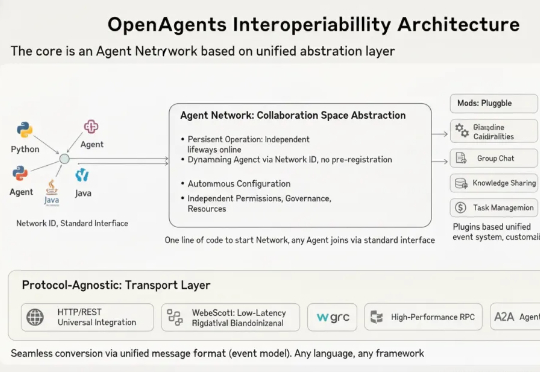

静态编排 VS 动态编排,谁是多agent系统最优解?通常来说,面对简单问题,采用react模式的单一agent就能搞定。可遇到复杂问题,单一agent就会立刻出现包括但不限于以下问题:串行执行效率低:无法同时完成并行的子步骤(如 “同时爬取 A、B 两个网站的数据”)。

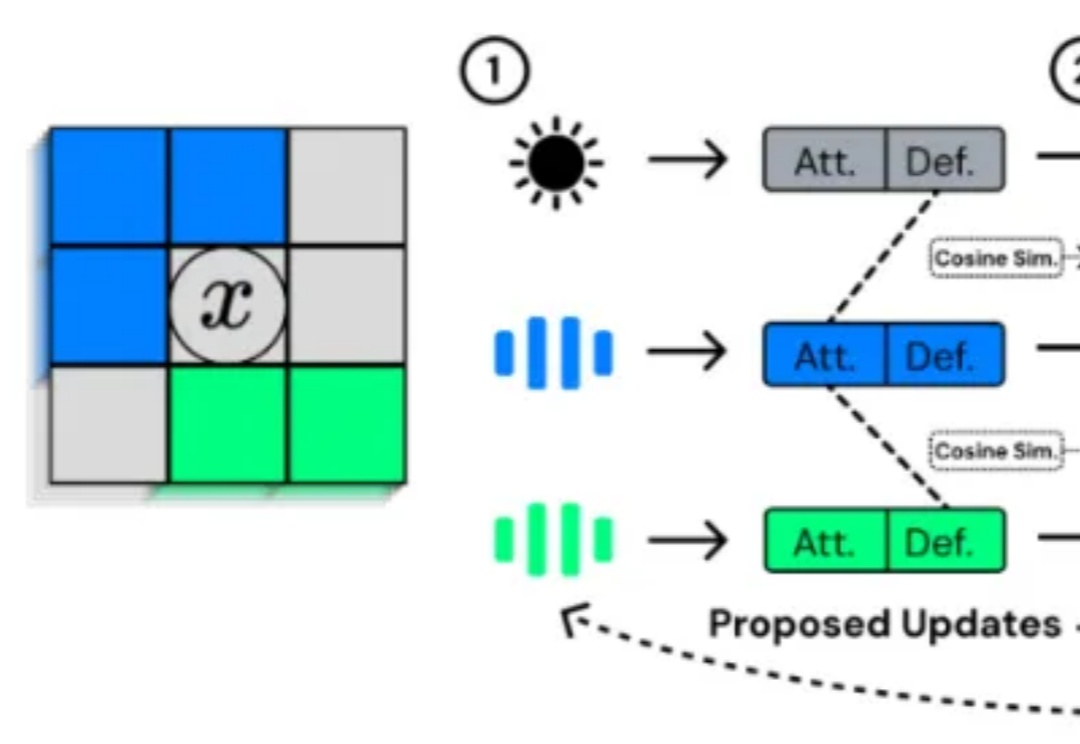

一直以来,关于人工生命(Artificial Life, ALife)的研究致力于回答这样一个问题:生命的复杂性能否在计算系统中自然涌现?

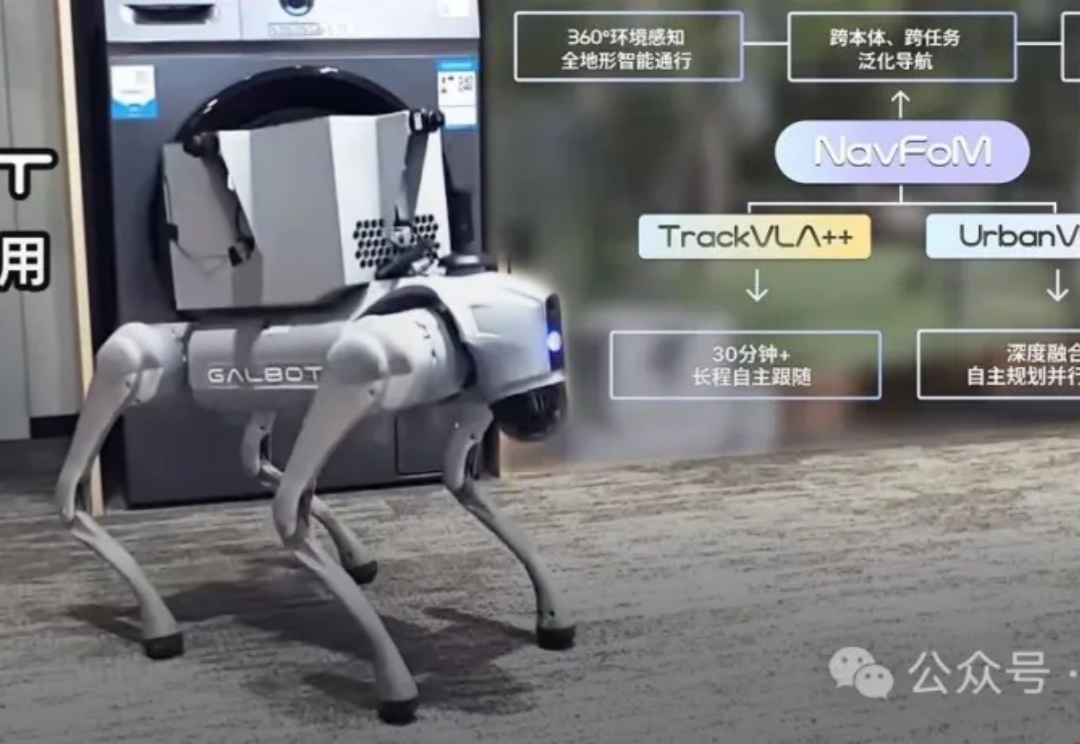

银河通用联合多所大学发布了全球首个跨本体全域环视导航基座大模型NavFoM,让机器人能自己找路,而不再依赖遥控,从而推动具身智能向规模化商业落地演进。

当前机器人领域,基础模型主要基于「视觉-语言预训练」,这样可将现有大型多模态模型的语义泛化优势迁移过来。但是,机器人的智能确实能随着算力和数据的增加而持续提升吗?我们能预测这种提升吗?

比Nano Banana更擅长P细节的图像编辑模型来了,还是更懂中文的那种。

谷歌遗珠与IBM预言:一文点醒Karpathy,扩散模型或成LLM下一步。

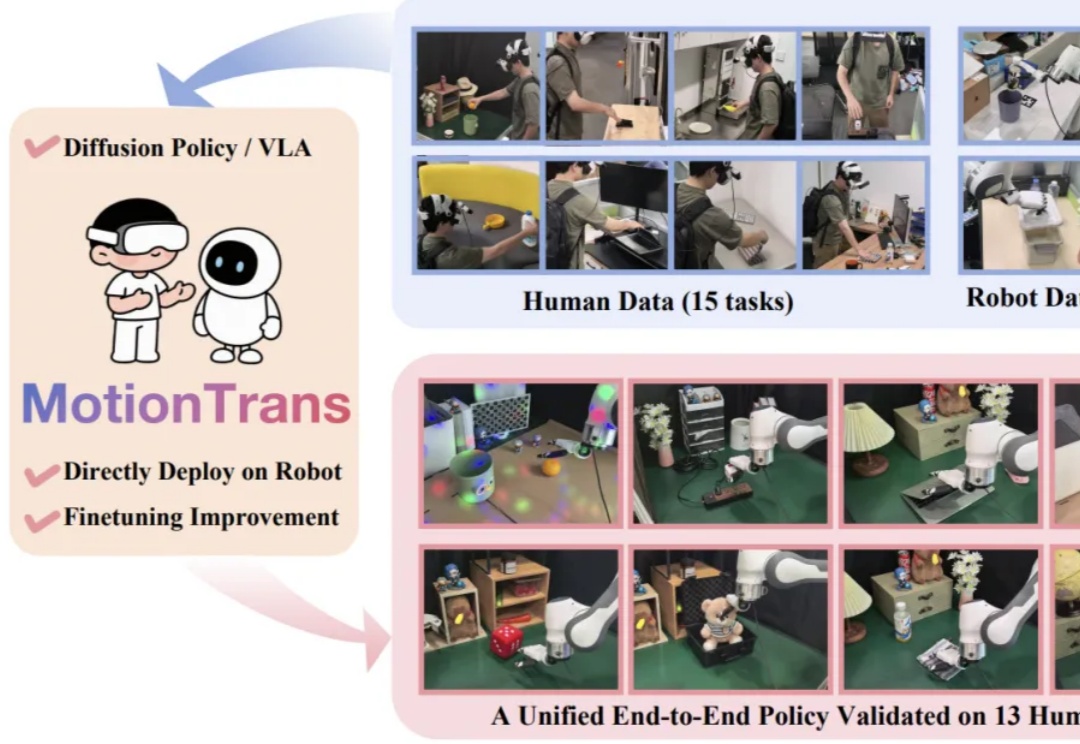

近期,Google DeepMind 发布新一代具身大模型 Gemini Robotics 1.5,其核心亮点之一便是被称为 Motion Transfer Mechanism(MT)的端到端动作迁移算法 —— 无需重新训练,即可把不同形态机器人的技能「搬」到自己身上。不过,官方技术报告对此仅一笔带过,细节成谜。

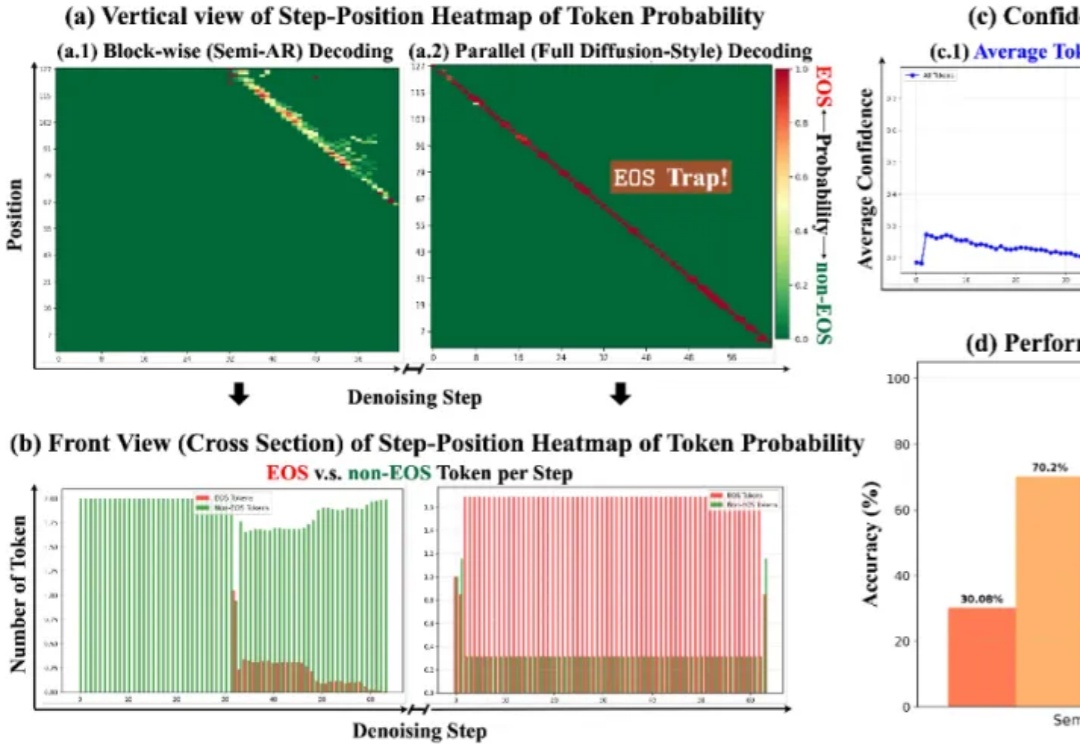

扩散大语言模型得到了突飞猛进的发展,早在 25 年 2 月 Inception Labs 推出 Mercury—— 第一个商业级扩散大型语言模型,同期人民大学发布第一个开源 8B 扩散大语言模型 LLaDA,5 月份 Gemini Diffusion 也接踵而至。

11 月 2 日,英伟达首次把 H100 GPU 送入了太空,参阅报道《英伟达发射了首个太空 AI 服务器,H100 已上天》。而刚刚谷歌宣布,他们也要让 TPU 上天。

2025 年 10 月,美股经历了一轮典型的震荡行情:月初科技股强势反弹,月中通胀数据扰动市场,10 月 10 日前后纳指单日波动超过 3%。就在这波谲云诡的市场环境中,港大黄超教授团队的开源 AI-Trader 项目正式启动实盘测试。该项目上线一周时间在 GitHub 上获得了近 8K 星标,展现了社区对 AI 自主交易技术和金融市场分析的能力高度关注。

前不久我写了一篇百度最新的OCR模型(PaddleOCR-VL)的文章反响还不错。

当AI不再只是解题机器,而能与人类并肩完成严谨的科研证明,这意味着什么?

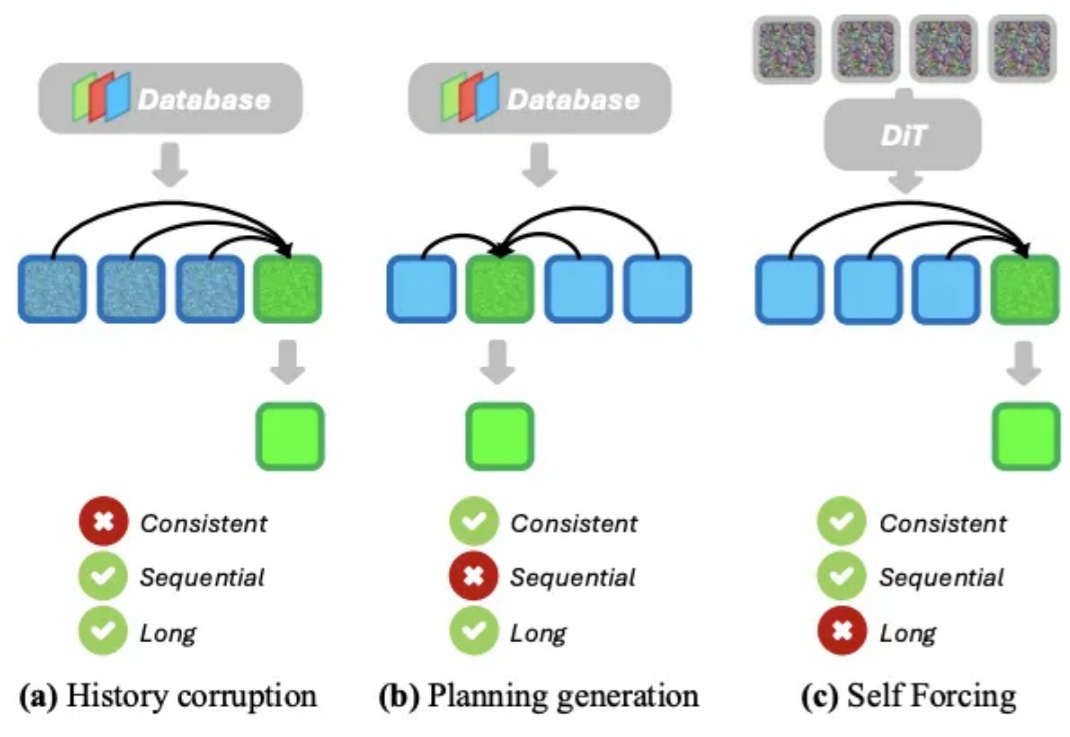

想象一下,你正在玩一款开放世界游戏,角色在无缝衔接的世界中自由漫游,游戏引擎必须实时生成一条无限长的视频流来呈现这个虚拟世界。或者,你戴着 AR 眼镜在街头行走,系统需要根据你的视线与动作,即时生成与你环境交互的画面。无论是哪种场景,都对 AI 提出了同样的要求:能实时生成高质量、长时间连贯的视频流。

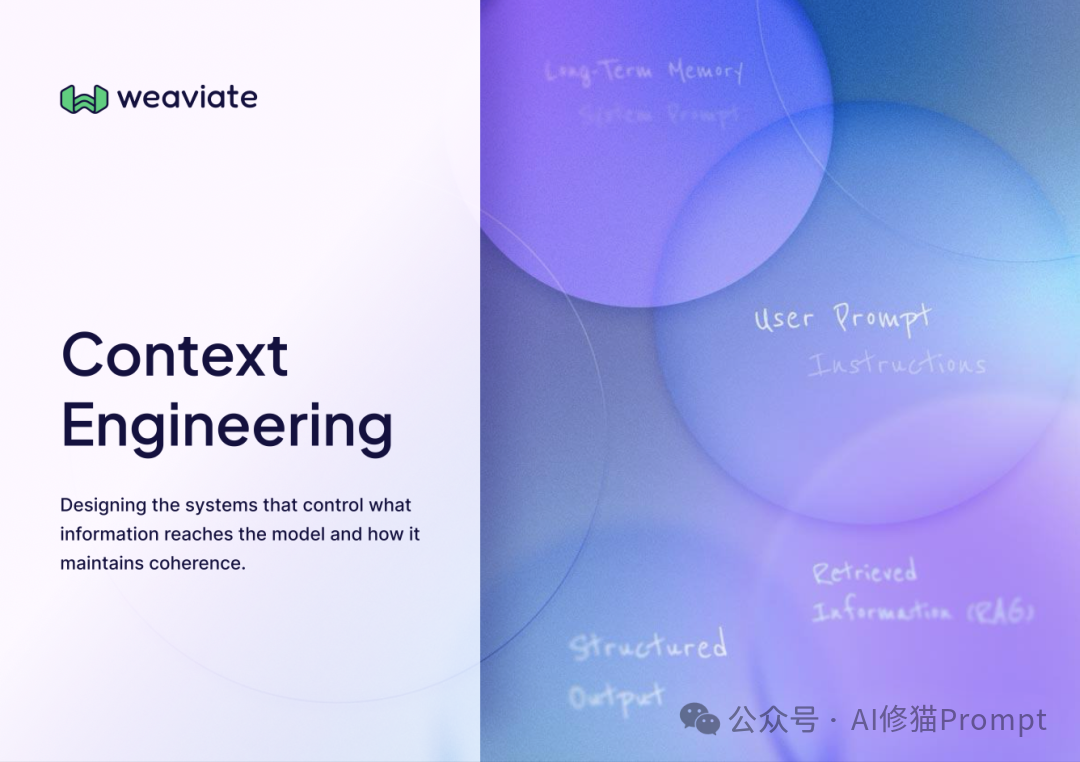

在几天前,上海交大发布了一篇名为 《上下文工程2.0:上下文工程的上下文》(Context Engineering 2.0: The Context of Context Engineering) 的重磅论文。

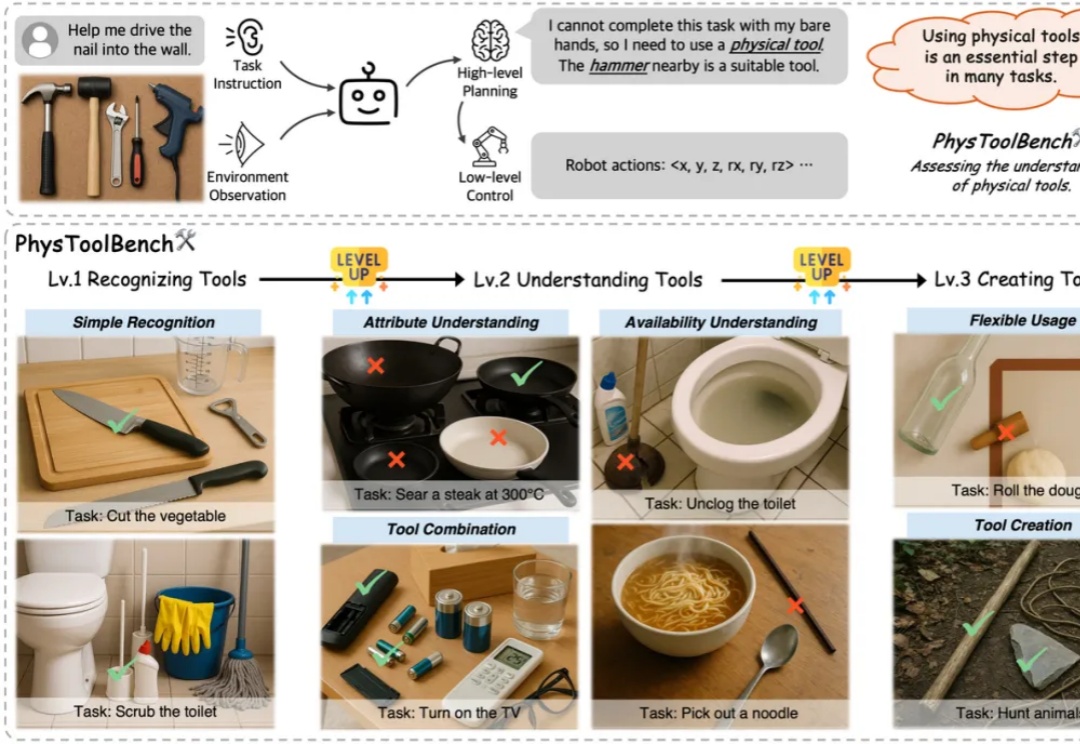

人类之所以能与复杂的物理世界高效互动,很大程度上源于对「工具」的使用、理解与创造能力。对任何通用型智能体而言,这同样是不可或缺的基本技能,对物理工具的使用会大大影响任务的成功率与效率。

同样是语义相似度结合时效性做rerank,指数衰减、高斯衰减、线性衰减怎么选? 假设你要在一个新闻应用中落地语义检索功能,让用户搜索雷军的投资版图盘点时,能自动关联顺为资本、小米战投等核心关联信息。

随着移动智能技术的飞速迭代,手机端聚合服务的AI“超级入口” 正成为行业竞争的新焦点——

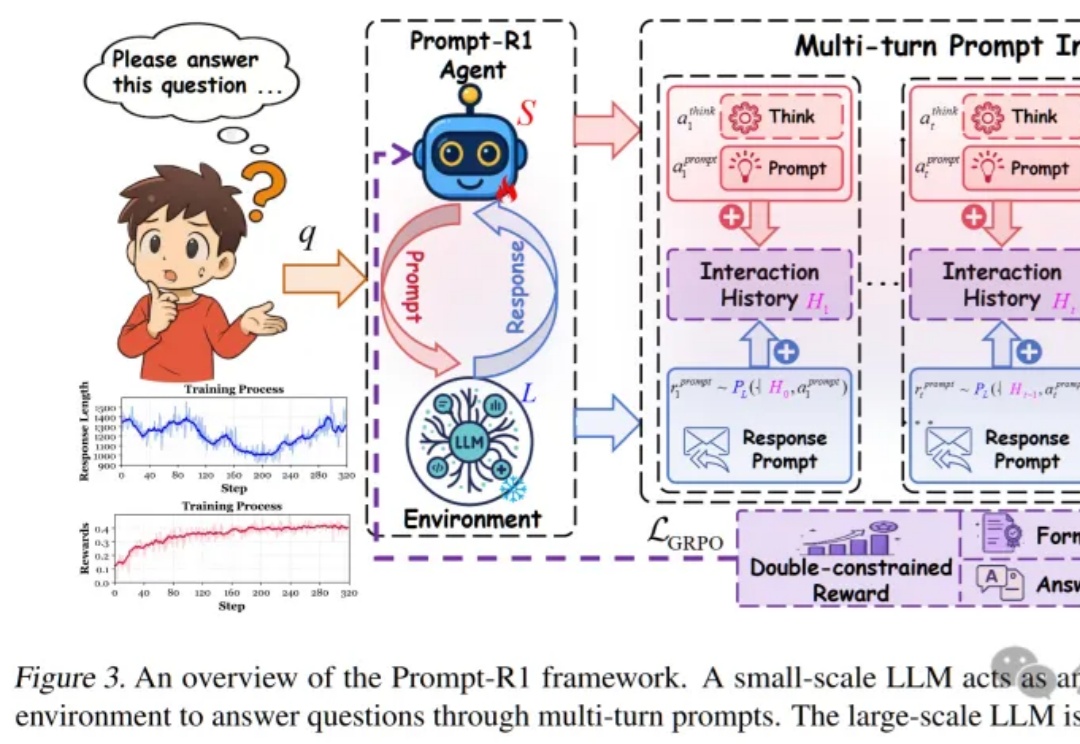

这篇论文提出了一种颠覆性的协作模式,即通过强化学习训练一个“小模型”作为智能代理(Agent),让它自动学会如何写出完美的Prompt,一步步引导任何一个“大模型”完成复杂推理,实现了真正的“AI指挥AI”。

大语言模型(LLM)的「炼丹师」们,或许都曾面临一个共同的困扰:为不同任务、不同模型手动调整解码超参数(如 temperature 和 top-p)。这个过程不仅耗时耗力,而且一旦模型或任务发生变化,历史经验便瞬间失效,一切又得从头再来。

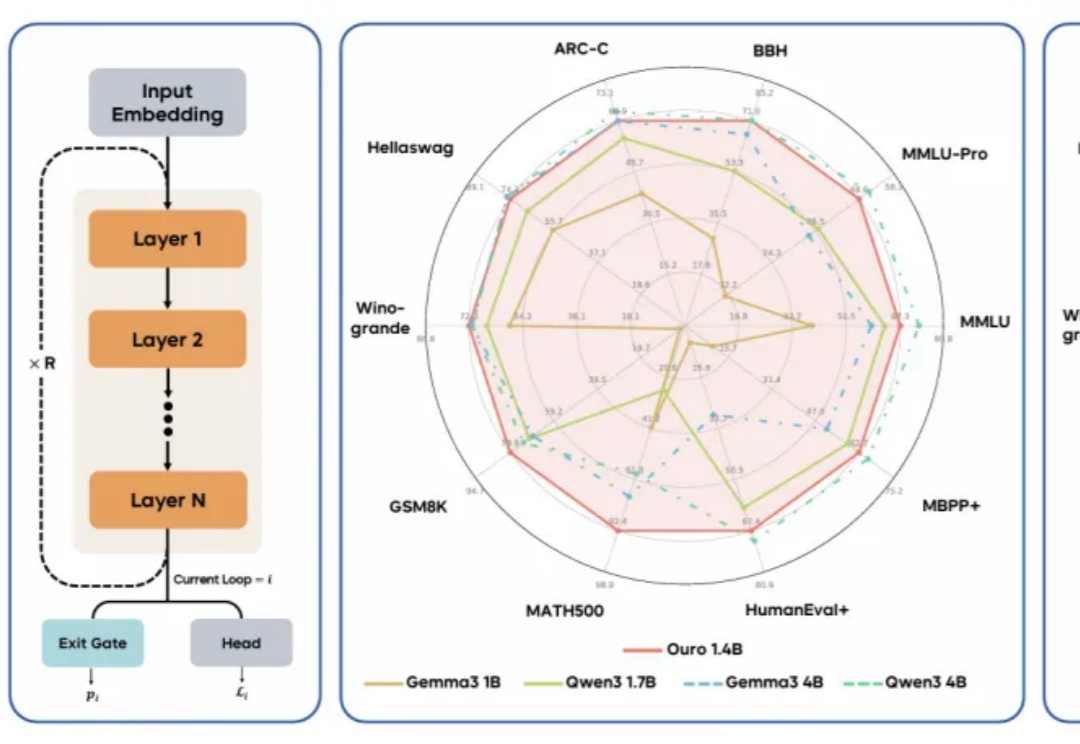

现代 LLM 通常依赖显式的文本生成过程(例如「思维链」)来进行「思考」训练。这种策略将推理任务推迟到训练后的阶段,未能充分挖掘预训练数据中的潜力。

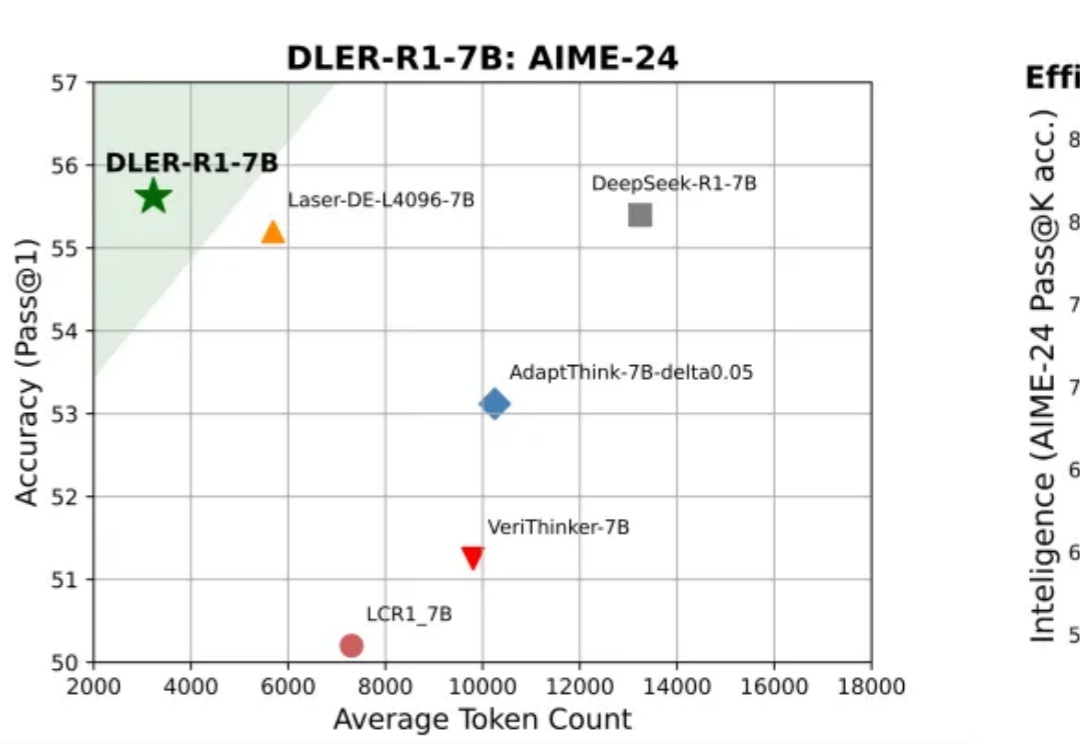

大模型推理到底要不要「长篇大论」?过去一年,OpenAI o 系列、DeepSeek-R1、Qwen 等一系列推理模型,把「长链思维」玩到极致:答案更准了,但代价是推理链越来越长、Token 消耗爆炸、响应速度骤降。

该论文提出 FractalForensics,一种基于分形水印的主动深度伪造检测与定位方法。不同于以往的水印向量,为达成伪造定位的功能,论文提出的水印以矩阵形式出现。

昨天一大早,就发现美团开源了他们首款全模态实时交互大模型:LongCat-Flash-Omni。

当下的文本生成图像扩散模型取得了长足进展,为图像生成引入布局控制(Layout-to-Image, L2I)成为可能。