Jina Reranker v3: 全新“列式”重排器,0.6B参数刷新文档检索SOTA

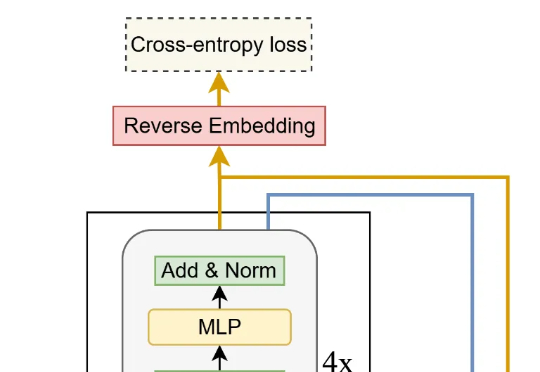

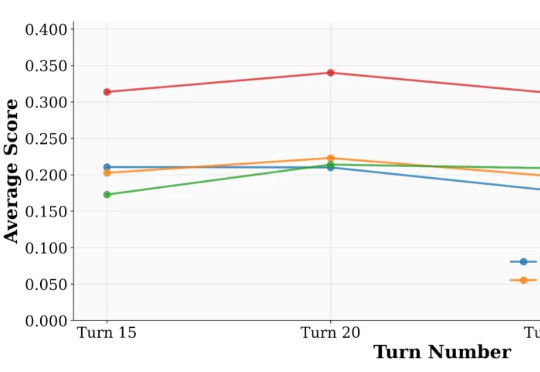

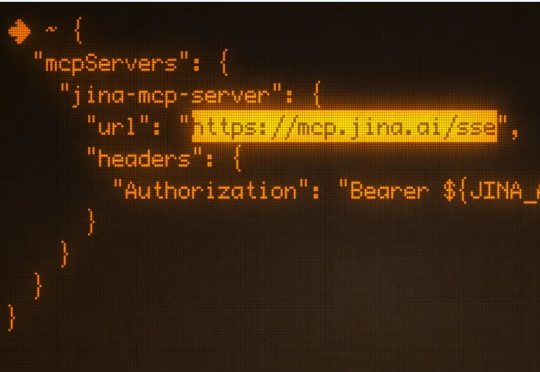

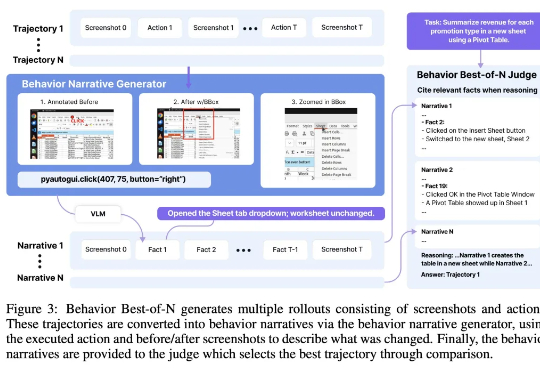

Jina Reranker v3: 全新“列式”重排器,0.6B参数刷新文档检索SOTA我们正式推出第三代重排器 Jina Reranker v3。它在多项多语言检索基准上刷新了当前最佳表现(SOTA)。这是一款仅有 6 亿参数的多语言重排模型。我们为其设计了名为 “last but not late” (中文我们译作后发先至)的全新交互机制,使其能接受 Listwise 即列式输入,在一个上下文窗口内一次性完成对查询和所有文档的深度交互。