音频-视觉全模态的未来预测,FutureOmni给出了首份答卷

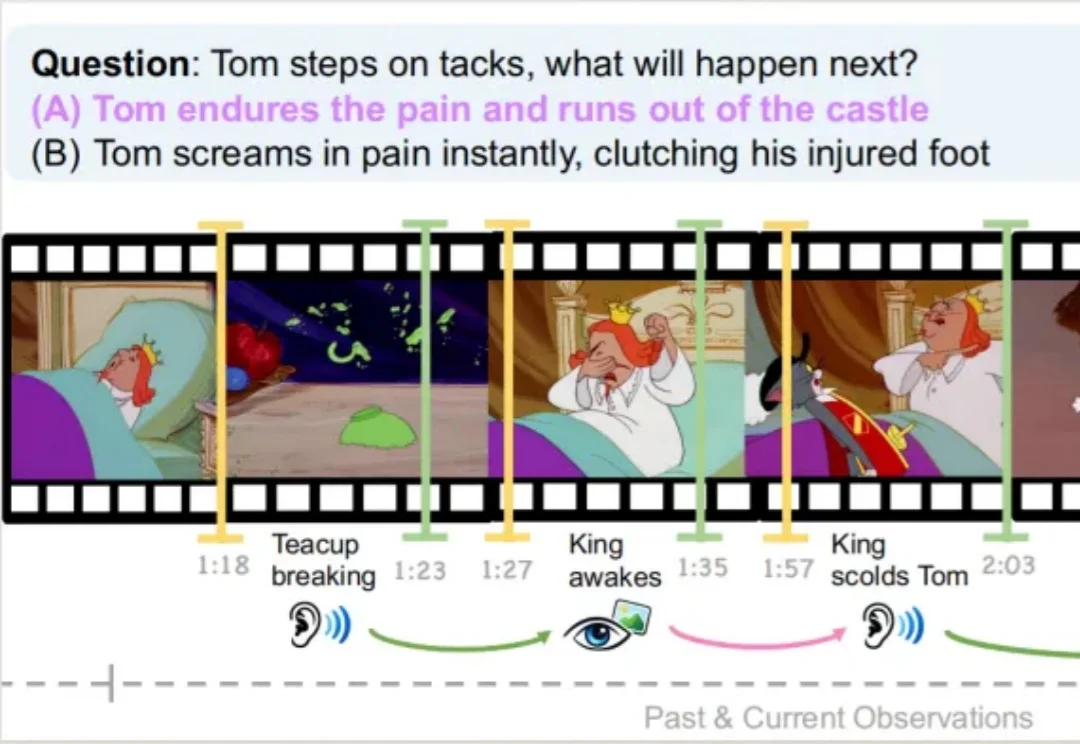

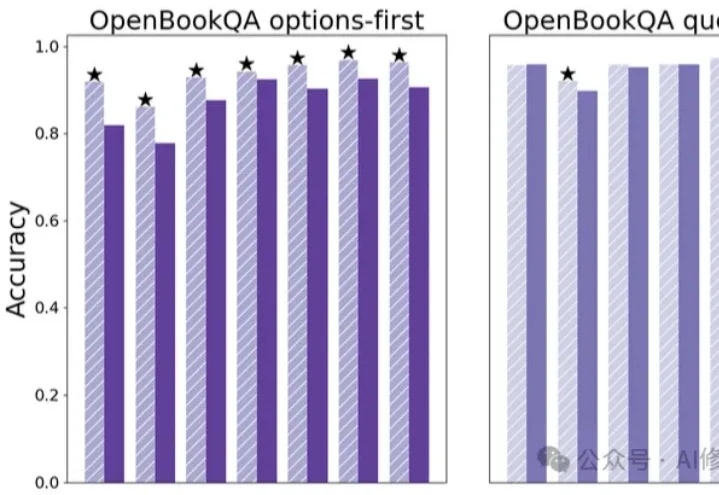

音频-视觉全模态的未来预测,FutureOmni给出了首份答卷复旦大学、上海创智学院与新加坡国立大学联合推出首个全模态未来预测评测基准 FutureOmni,要求模型从音频 - 视觉线索中预测未来事件,实现跨模态因果和时间推理。

复旦大学、上海创智学院与新加坡国立大学联合推出首个全模态未来预测评测基准 FutureOmni,要求模型从音频 - 视觉线索中预测未来事件,实现跨模态因果和时间推理。

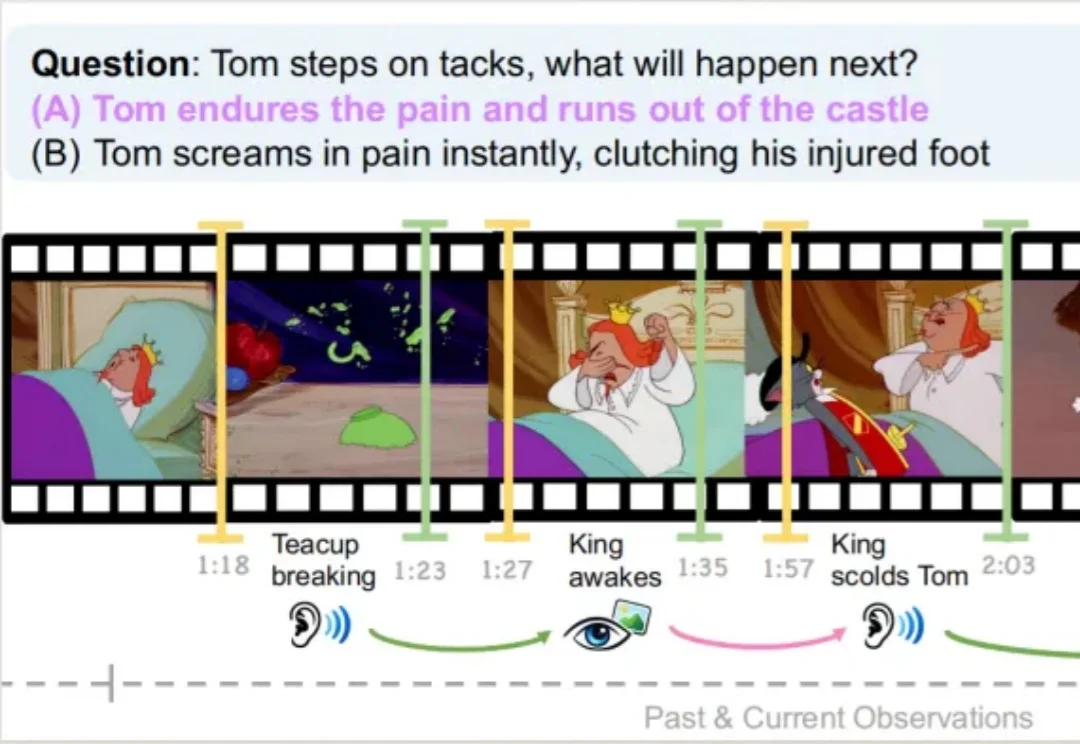

IDEA研究院张磊团队与香港科技大学谭平团队联合推出SceneMaker框架,有望攻克这一问题。 它以视启未来的万物检测模型DINO-X与光影焕像的万物3D生成模型Triverse为基础,实现了从任意开放世界图像(室内/室外/合成图等)到带Mesh的3D场景的完整重建。

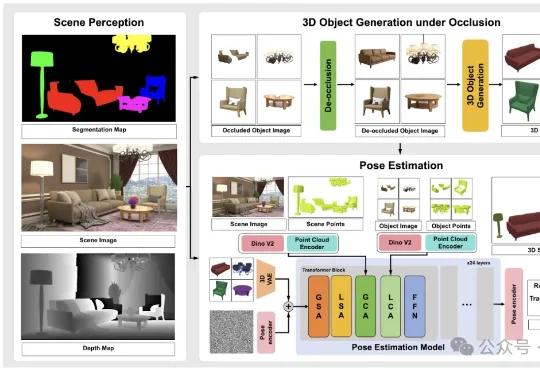

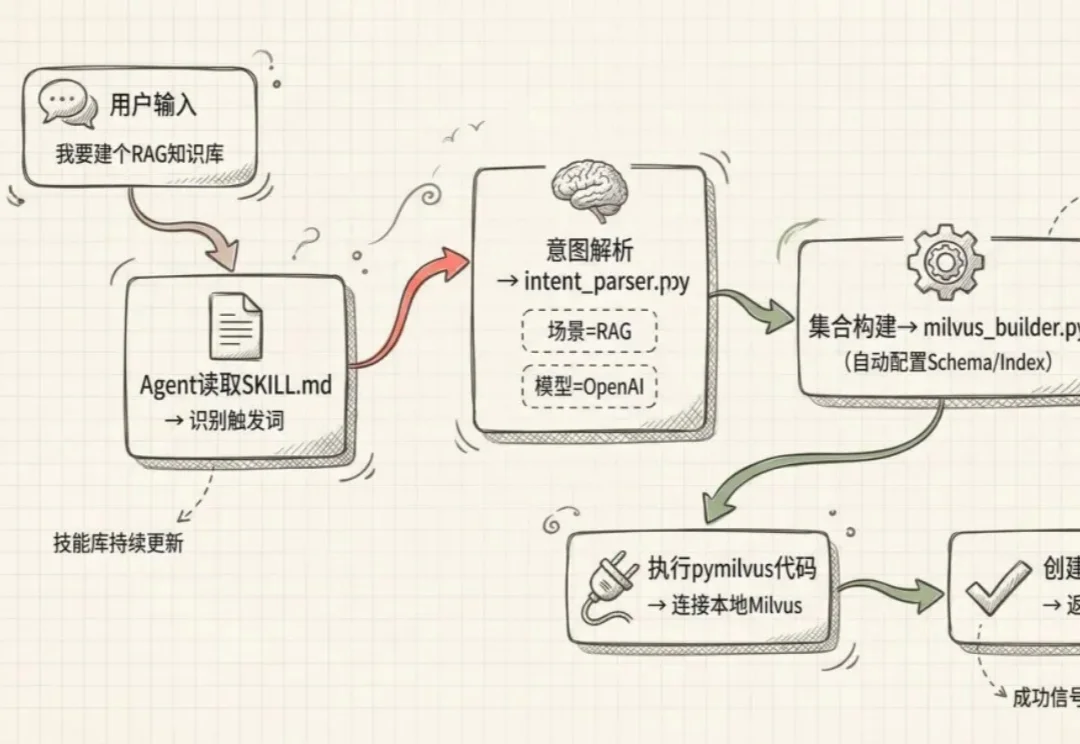

上篇文章别把整个 GitHub 装进 Skills,Skills 的正确用法发出去后,收到一些质疑:“说 skill 能做配图 prompt 不行。本来 skill 就是加载 md,没 skill 之前我们用 prompt 模板照样也是能做流程编排。” “现在大部分 skill 不就是长一点的提示词吗?为什么说'单纯靠提示词做不了'?”

这篇《Skills 的最正确用法,是将整个 Github 压缩成你自己的超级技能库》绝对是一篇绝佳的入门指南,但也要注意:这种用法,还当不起“最”正确用法。 我不是来抬杠的,而是想聊聊:怎么更好地使用

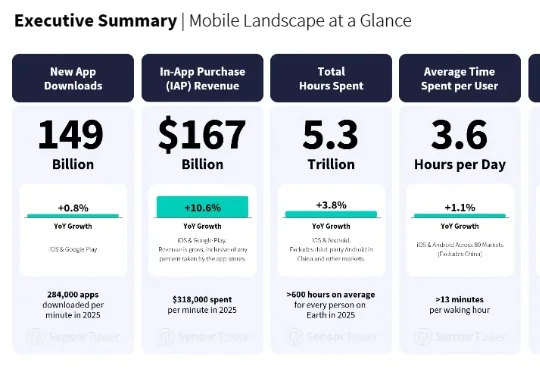

最近,移动应用数据分析商 Sensor Tower 发布了一份《State of Mobile 2026》。AI 应用的增长不但没有减速,反而更快了。AI 应用的下载量翻倍,达到 38 亿次;IAP 收入增长超过三倍,突破 50 亿美元;

编辑|Panda 在文生图模型的技术版图中,VAE 几乎已经成为共识。从 Stable Diffusion 到 FLUX,再到一系列扩散 Transformer,主流路线高度一致:先用 VAE 压缩视

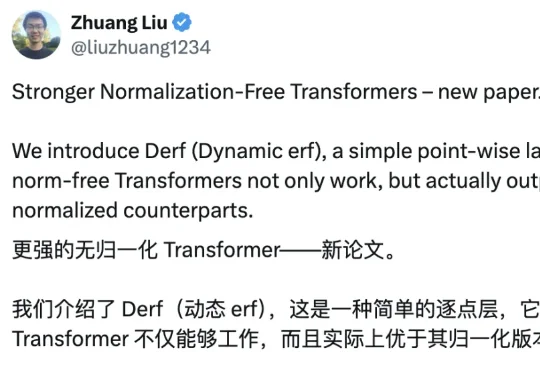

这篇新论文提出了一种非常简单的新激活层 Derf(Dynamic erf),让「无归一化(Normalization-Free)」的 Transformer 不仅能稳定训练,还在多个设置下性能超过了带 LayerNorm 的标准 Transformer。

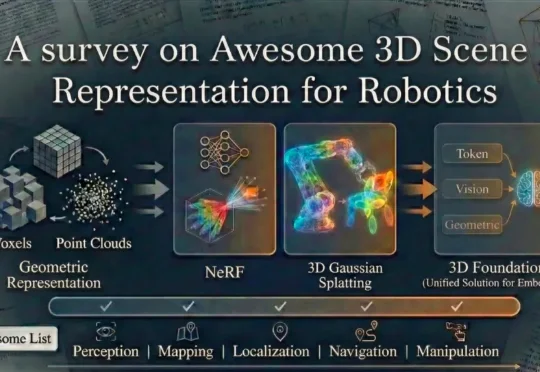

上海交通大学、波恩大学等院校的研究团队全面总结了当前机器人技术中常用的场景表示方法。这些方法包括传统的点云、体素栅格、符号距离函数以及场景图等传统几何表示方式,同时也涵盖了最新的神经网络表示技术,如神经辐射场、3D 高斯散布模型以及新兴的 3D 基础模型。

谷歌 DeepMind 发布 D4RT,彻底颠覆了动态 4D 重建范式。它抛弃了复杂的传统流水线,用一个统一的「时空查询」接口,同时搞定全像素追踪、深度估计与相机位姿。不仅精度屠榜,速度更比现有 SOTA 快出 300 倍。这是具身智能与自动驾驶以及 AR 的新基石,AI 终于能像人类一样,实时看懂这个流动的世界。

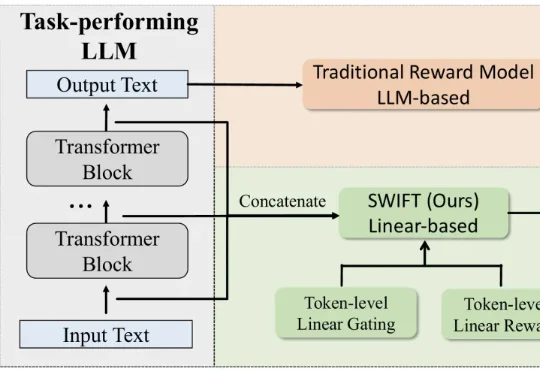

最新奖励模型SWIFT直接利用模型生成过程中的隐藏状态,参数规模极小,仅占传统模型的不到0.005%。SWIFT在多个基准测试中表现优异,推理速度提升1.7×–6.7×,且在对齐评估中稳定可靠,展现出高效、通用的奖励建模新范式。

最近 AI 编程界最火的事情,就是怎么把各种 coding 模型卷到极致了。

AAAI 2026「七龙珠」,华人团队强势霸榜!从视觉重建到因果发现,再到知识嵌入传承,新一代AI基石正在新加坡闪耀。

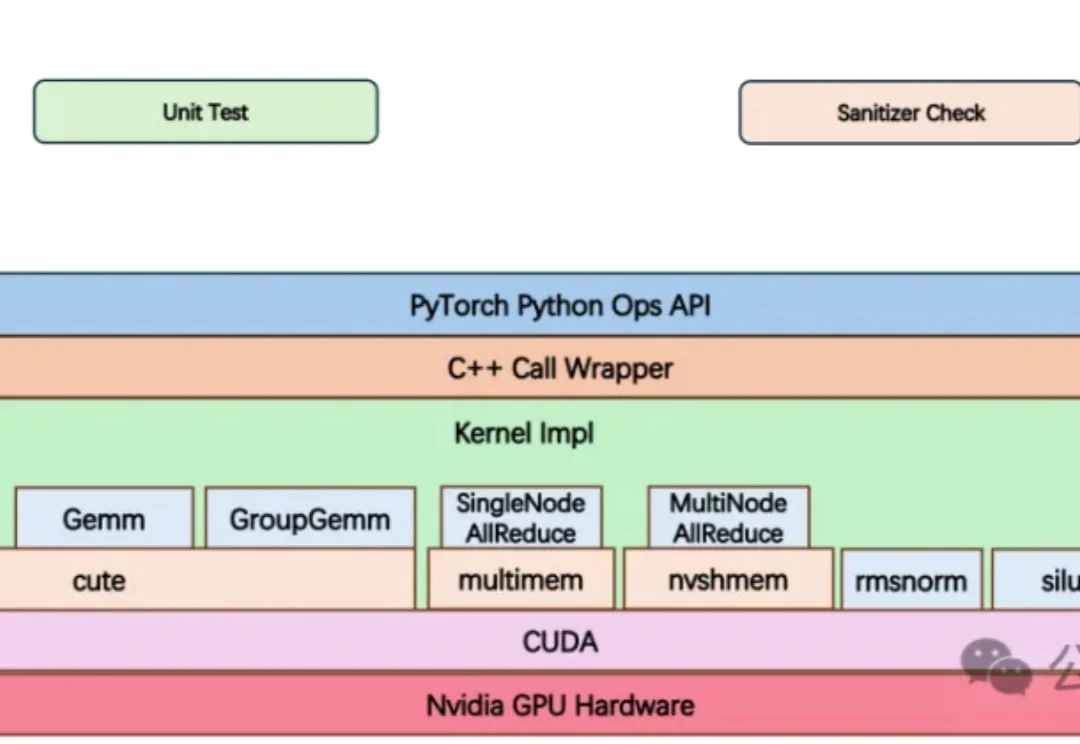

大模型竞赛中,算力不再只是堆显卡,更是抢效率。

GEM框架利用认知科学原理,从少量人类偏好中提取多维认知评估,让AI在极少标注下精准理解人类思维,提高了数据效率,在医疗等专业领域表现优异,为AI与人类偏好对齐提供新思路。

在当前的AI Research浪潮中,Autonomous Agents已经改变了我们获取信息的方式——从被动接收到主动检索。

最近群里好多朋友在问我,Gemini 生成的图片水印能不能去掉。

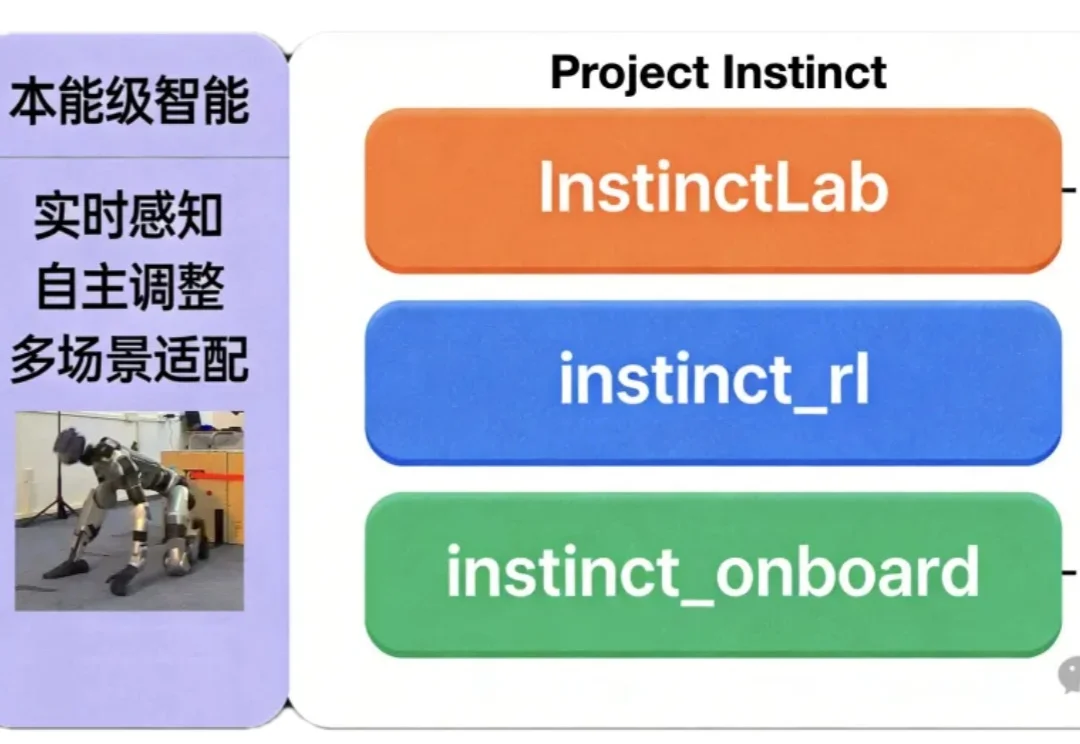

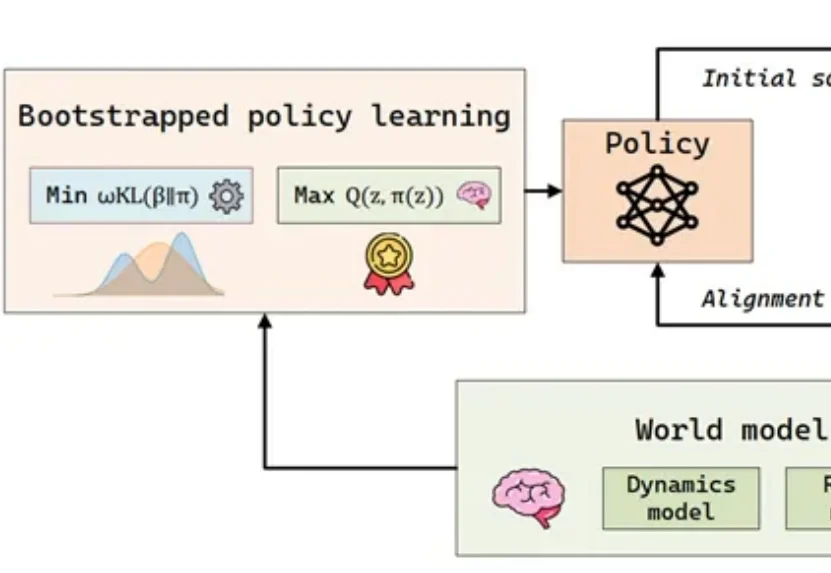

如何让机器人同时具备“本能反应”与复杂运动能力?

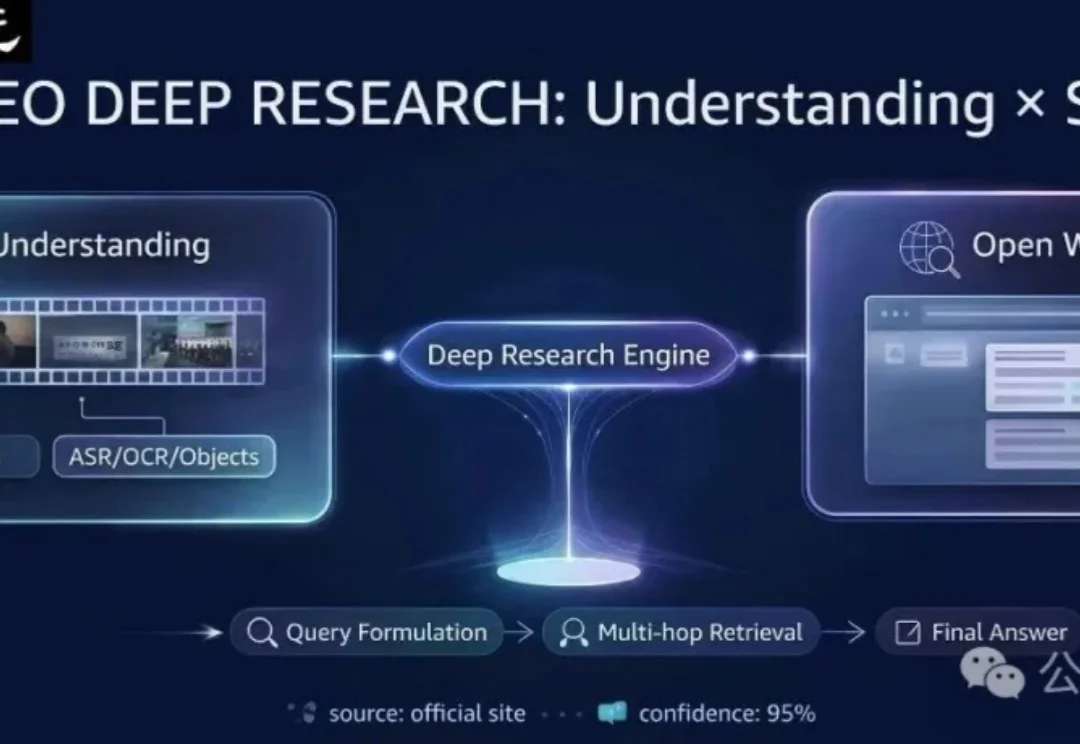

现有的多模态模型往往被困在「视频」的孤岛里——它们只能回答视频内的问题。但在真实世界中,人类解决问题往往是「看视频找线索 -> 上网搜证 -> 综合推理」。

竟然只需要一次Ctrl+V?这可能是深度学习领域为数不多的“免费午餐”。

Agent很好,但要做好工具调用能才能跑得通。

近日,中国科学技术大学(USTC)联合新疆师范大学、中关村人工智能研究院、香港理工大学,在数据驱动的多功能双连通多尺度结构逆向设计领域取得重要突破。

我经常一种票据风格的提示词帮我的内容生成图片,很多朋友一直问啥时候发。

现有AI记忆评测存在局限,如数据源单一、忽视变化本质、注入成本高等。CloneMem通过层次化生成框架构建合成人生,设计贴近真实场景的评测任务,涵盖多种问题类型。

随着大模型在单点推理上日益逼近 PhD 水平,Agent 领域迎来了新的分水岭:短程任务表现惊艳,长程任务却显乏力。为精准评估大模型的多模态理解与复杂问题解决能力,红杉中国在两周内连续发布两篇论文,旨在通过构建更科学的评估基准,预判技术演进的未来方向。

中国团队首次在全球顶尖期刊发表“大模型+医疗”领域的相关标准研究! 作为Nature体系中专注于数字医疗的旗舰期刊,《npj Digital Medicine》(JCR影响因子15.1,中科院医学大类1区Top期刊)此次收录的CSEDB研究,首次提出了一套用于评估医疗大模型真实临床能力的系统性框架。

华东师范大学Planing Lab提出APEX框架,通过自然语言指令实现学术海报的局部可控编辑,并引入「审查—调整」机制提升编辑可靠性。

在具身智能(Embodied AI)的快速发展中,样本效率已成为制约智能体从实验室环境走向复杂开放世界的瓶颈问题。

AI 真的能提升工作效率吗?

今天的 Agent,在一个独立的、短时间任务上的表现已经很不错了。

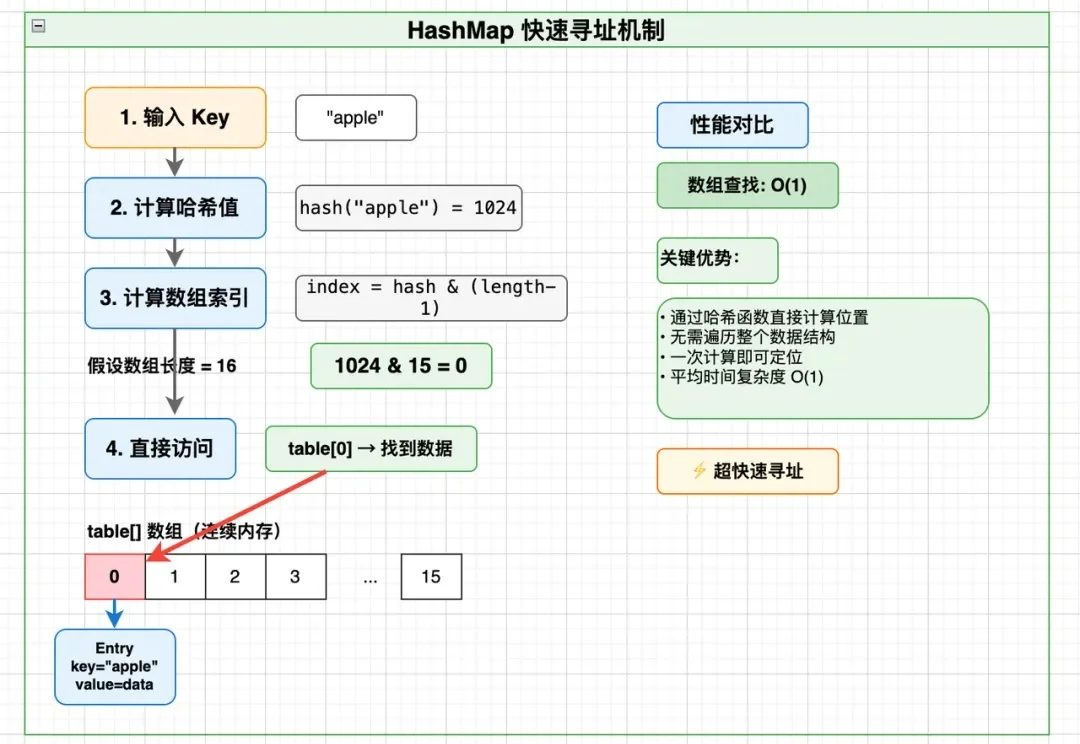

做后端、大数据、分布式存储的同学,大概率都遇到过这样的问题: