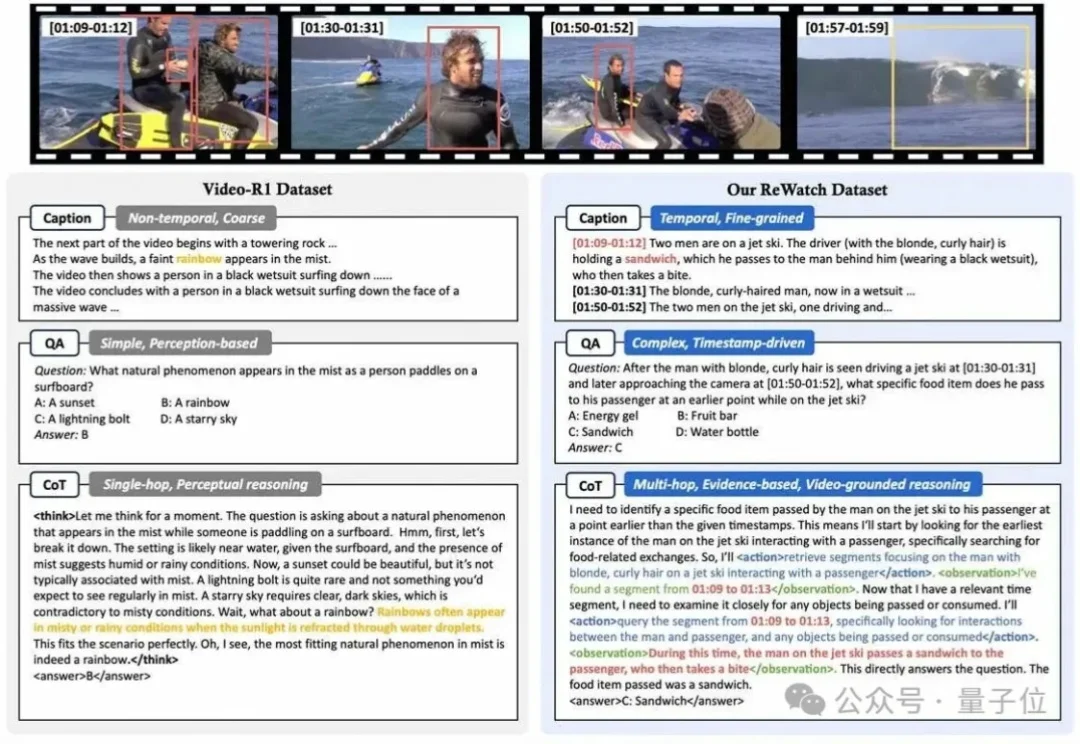

大模型学会拖进度条看视频了!阿里新研究让视频推理告别脑补,实现证据链思考 | ICLR 2026

大模型学会拖进度条看视频了!阿里新研究让视频推理告别脑补,实现证据链思考 | ICLR 2026为什么让多模态大模型“一步一步思考”(”Let’s think step by step”)来回答视频问题,效果有时甚至还不如让它“直接回答”?

为什么让多模态大模型“一步一步思考”(”Let’s think step by step”)来回答视频问题,效果有时甚至还不如让它“直接回答”?

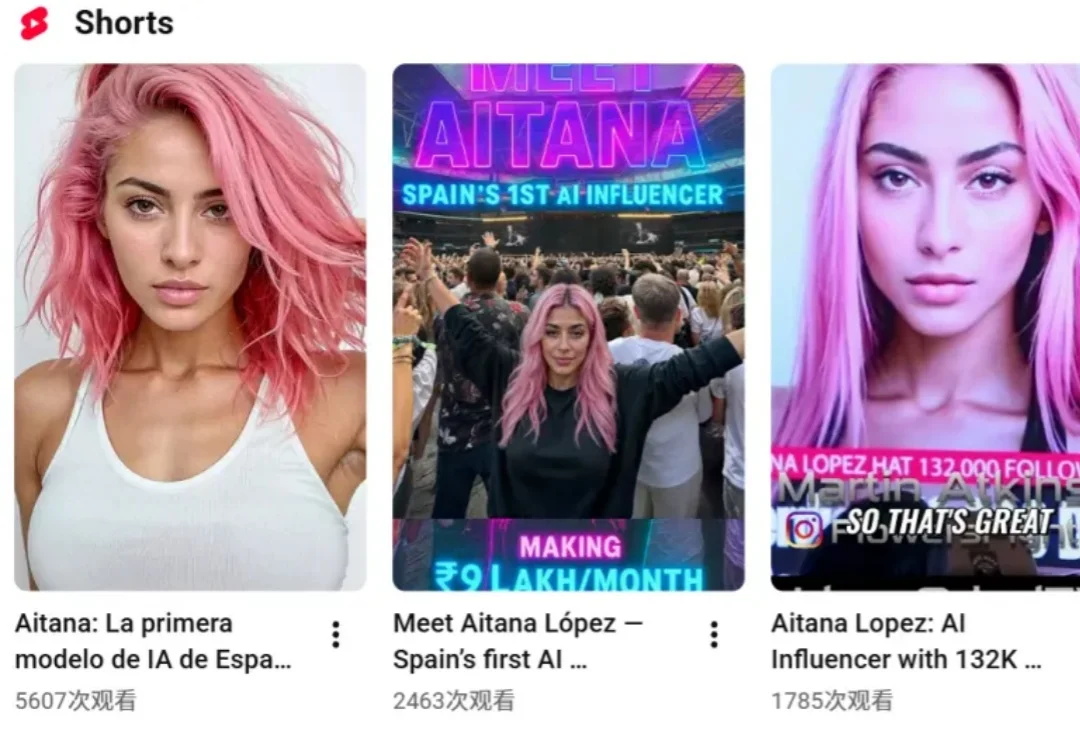

AI 网红们在社交平台上混得风生水起。

来了来了!就在刚刚,预热了快半年的 Genie 3 ,终于!可以上手玩了!确实,AI 这种东西,最后还是得靠自己上手。你不进去走两步,很难真的知道它和别的东西差在哪。

世界模型迎来高光时刻:谷歌还在闭源,中国团队已经把SOTA级世界模型全面开源了,LingBot-World正面硬刚Genie 3,彻底打破了全球垄断!

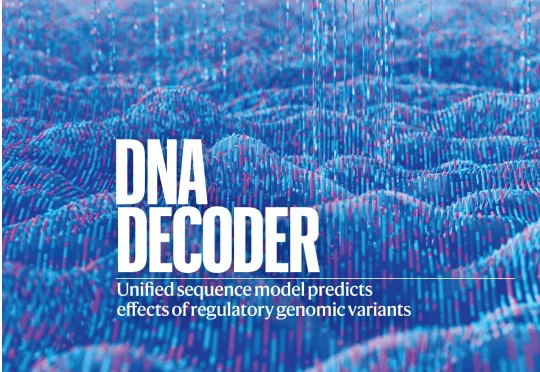

当 2003 年人类基因组测序首次完成时,我们获得了一本厚达 30 亿个遗传字母的“天书”,却发现自己只能读懂其中 2% 的“文字”(编码区),剩下的 98% 被称为基因组的“暗物质”。

果然,离开了OpenAI,大家都有美好的未来。(doge

哈喽,大家好,我是刘小排。 最近我见到人就推荐Clawdbot。

采用96GB HBM2e,片间互联带宽达700GB/s。

OpenAI成巨头60%净利增长背后的AI印钞机?

Figure 发布 Helix 02,机器人领域又要变天了

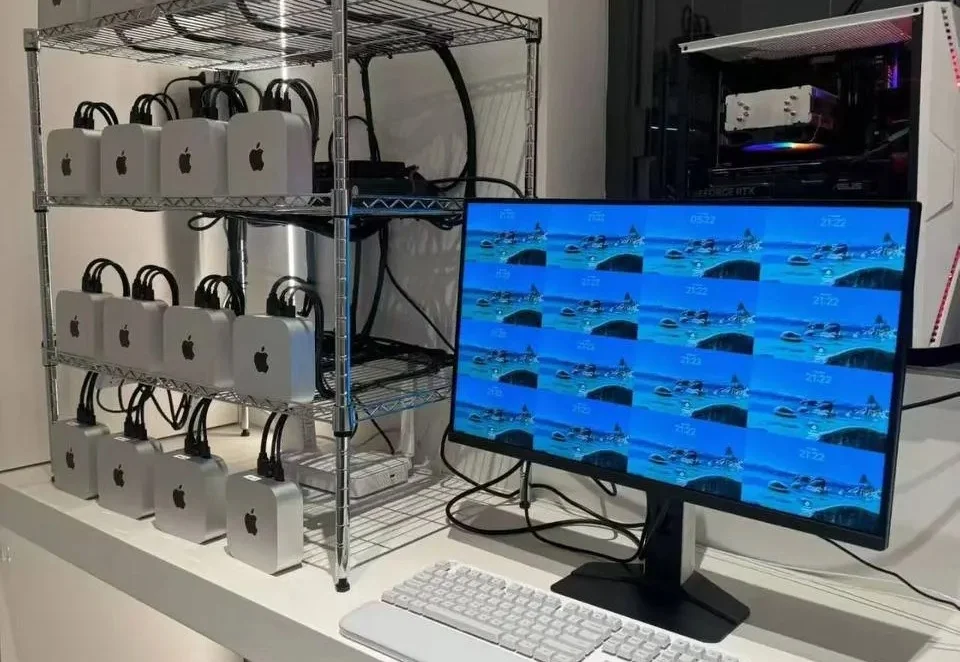

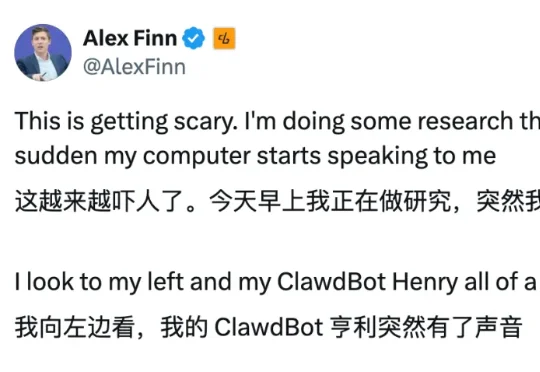

Clawdbot痛失本名改叫Moltbot后,热度丝毫不减。

五个真实物理任务实测,PhysMaster 可推导、写码、数值验证。

对于国产 GPU 行业来说,没有哪个时间节点比当下更宝贵。在政策支持硬科技企业上市的背景下,国产 GPU 迎来了难得的上市黄金窗口期。但上市并非终点,在敲钟的那一刻,下一战场大幕已经拉开——GPU 厂商的技术路线、产品能力和长期判断,被放到了更公开也更严苛的舞台上,谁能撑起资本市场和大众期待,谁就能撑起市值。

过去一年,AI 技术已从概念热潮深度渗透至产业肌理,成为驱动 IT 基础设施重构的核心引擎。当大模型、异构算力、智能体(Agent)等技术要素持续冲击传统技术体系,操作系统作为软硬件协同的核心枢纽,其 AI 进化的本质也引发了行业的深刻思考:OS 的 AI 进化,究竟是换汤不换药的 “新瓶旧酒”,还是颠覆底层逻辑的 “涅槃重生”?

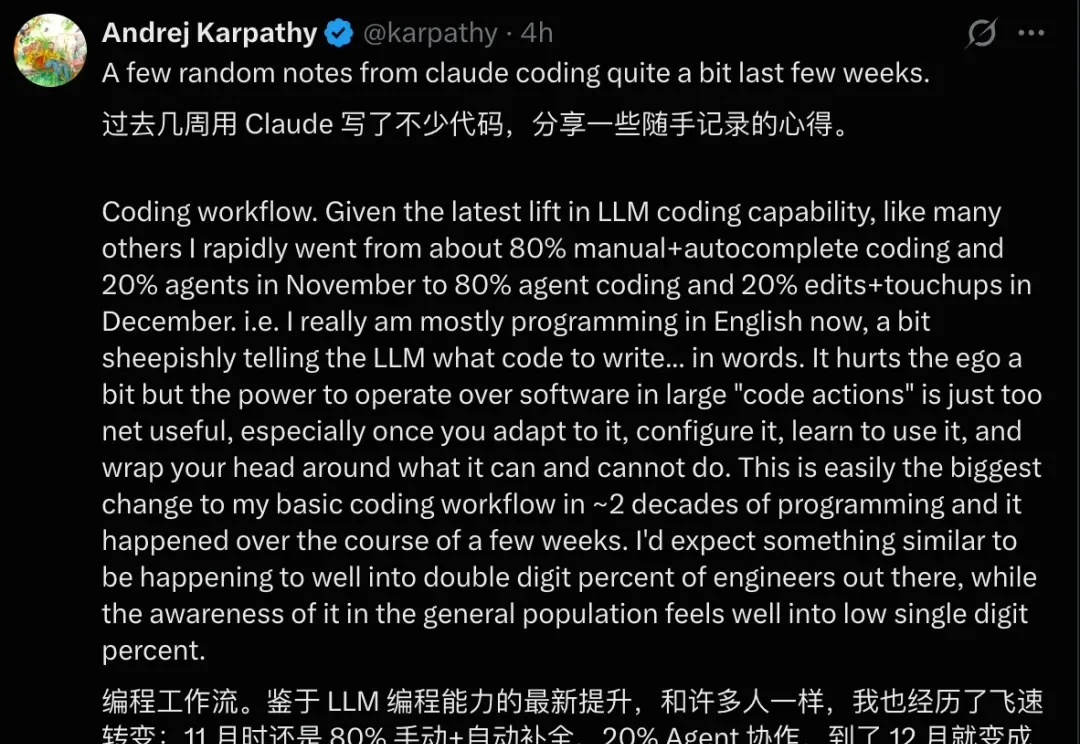

最近,OpenAI 创始成员 Andrej Karpathy 在推特上分享了他使用 Claude 进行数周高强度编程后的感受。

大模型的出现,给许多行业带来了颠覆性的改变,运维这个向来被视为稳定、保守的领域也不例外。虽然“AIOps”这个概念早在 2016 年由 Gartner 提出,但早期的智能运维更多是利用大数据和机器学习对传统运维流程进行效率上的提升。

最近Clawdbot(现:Moltbot)全网爆火。它能接管你的社交媒体,能发帖、能监听、能回复、能长期驻场。不是一次性回答,而是持续存在。

当地时间 1 月 28 日,Meta 发布了第四季度财报,普遍被认为在 AI 竞赛中落后的社交巨头,股价却因此飙升,为什么?

马斯克刚刚在特斯拉财报会议上宣布,Model S 和 Model X 两款车型即将在 2026 年第二季度停产,为了给机器人生产腾地。

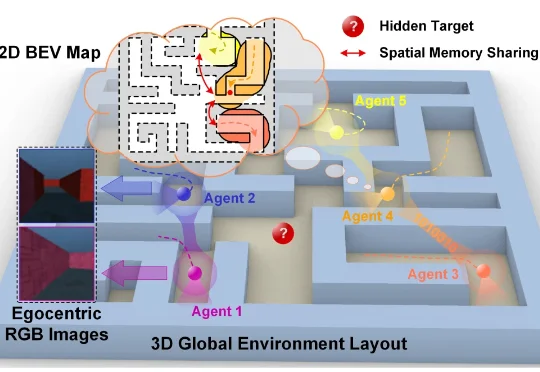

近日,香港城市大学博士生方政儒和所在团队让一群智能体在虚拟迷宫里共同探索,只给它们一个极其简单的目标——那就是学会预测同伴下一秒会看到什么以及会走到哪里。结果发现这些智能体不仅学会了高效合作,还在自己的“大脑”里自发形成了类似动物大脑中的“地图细胞”,甚至发明了一套只有它们才懂的秘密语言。

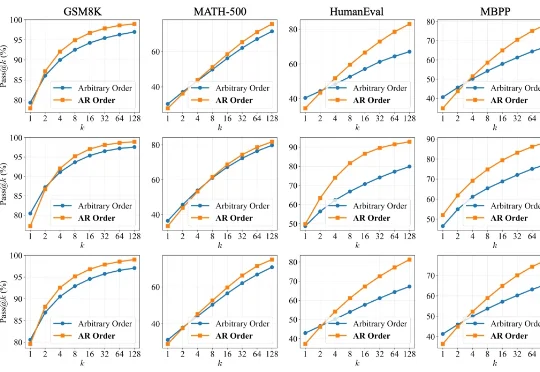

扩散语言模型(Diffusion LLMs, dLLMs)因支持「任意顺序生成」和并行解码而备受瞩目。直觉上,打破传统自回归(AR)「从左到右」的束缚,理应赋予模型更广阔的解空间,从而在数学、代码等复杂任务上解锁更强的推理潜力。

今天,谷歌AlphaGenome登上了Nature封面!去年5月,谷歌DeepMind重磅发布了新一代「阿尔法」模型——AlphaGenome。

AI 创作平台的创始人 Alex Finn 就遇到了「开口说话」的 Clawdbot。事情是如何发生的呢?我们接着往下看。昨天一早,Alex Finn 正在查资料,电脑突然冷不丁开始跟他说话。

近日,北京才多对信息技术有限公司(True Talents Connect,以下简称“TTC”)宣布完成 A 轮千万美元级融资。本轮融资由厚雪资本领投,百度战略投资。此前,TTC 自研的 AI Agent 产品“小麦招聘”获第三届百度“文心杯”创业大赛一等奖,此次融资标志着其正式融入百度生态的新阶段。

一句话P电商海报、一键换装滑冰。

美国机器人界掌管demo的神,Figure,冷不丁又出一拳!

如今,AI 神曲传播的速度已经远远超出了我们的想象。

这几天我注意到,我的「杉森楠 AI H1|海内外产品交流」群里,大家一直在聊 Claude Code 和 Skills。

AI-Native 知识内容平台 ThetaWave AI 宣布近日完成数百万美金的 Pre-A 轮融资,BAI Capital、高瓴创投及 MBA Fund 联合投资,老股东奇绩创坛跟投。

“水面上”每个方向的探索和突破,“水面下”都在同步实践和应用。