ICLR 2026|UIUC:一行代码彻底解决LLM推理的过度思考!

ICLR 2026|UIUC:一行代码彻底解决LLM推理的过度思考!2025 年 1 月 20 日,DeepSeek 发布了推理大模型 DeepSeek-R1,在学术界和工业界引发了对大模型强化学习方法的广泛关注与研究热潮。 研究者发现,在数学推理等具有明确答案的任务

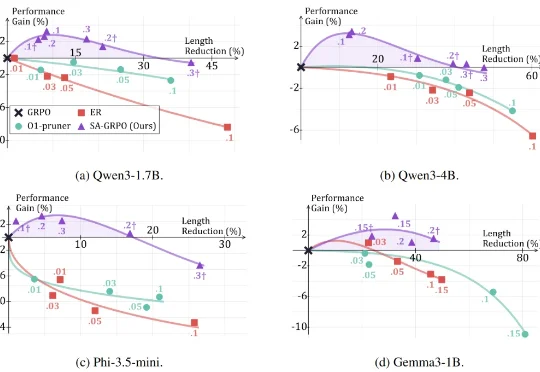

2025 年 1 月 20 日,DeepSeek 发布了推理大模型 DeepSeek-R1,在学术界和工业界引发了对大模型强化学习方法的广泛关注与研究热潮。 研究者发现,在数学推理等具有明确答案的任务

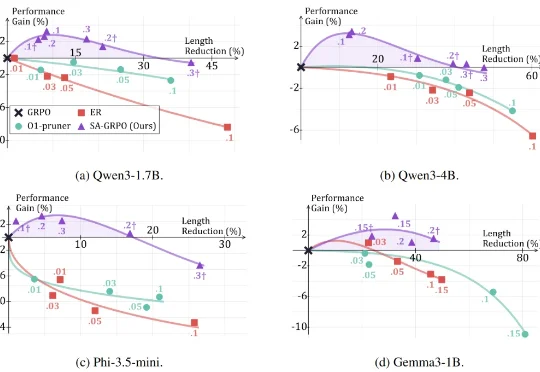

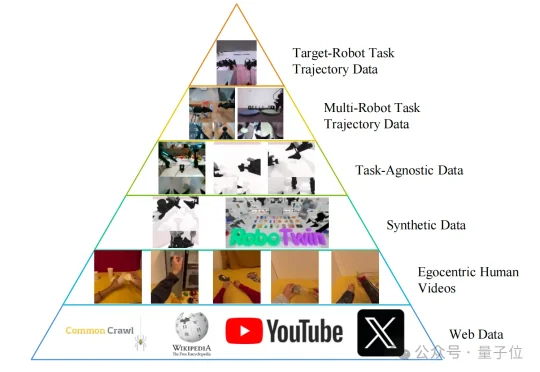

LaST₀团队 投稿 量子位 | 公众号 QbitAI 近日,至简动力、北京大学、香港中文大学、北京人形机器人创新中心提出了一种名为LaST₀的全新隐空间推理VLA模型,在基于Transformer混

随着 AI 智能体(Agent)能力日益强大,其自主行为带来的安全风险也愈发复杂。现有安全工具往往只能给出「安全 / 不安全」的简单判断,无法告知我们风险的根源。为此,上海人工智能实验室正式开源 Ag

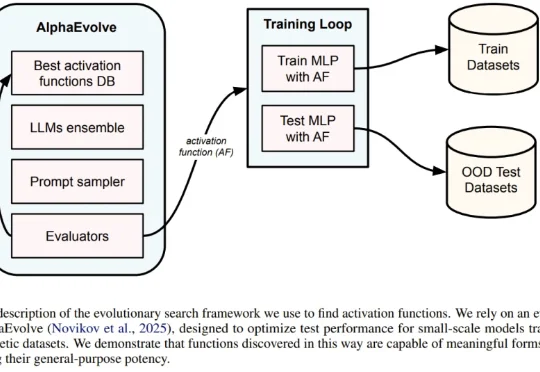

一直以来,神经网络的激活函数就像是 AI 引擎中的火花塞。从早期的 Sigmoid、Tanh,到后来统治业界的 ReLU,再到近年来的 GELU 和 Swish,每一次激活函数的演进都伴随着模型性能的提升。但长期以来,寻找最佳激活函数往往依赖于人类直觉或有限的搜索空间。

国产开源具身世界模型,直接秒了Pi-0.5,而且还是几位清华硕、博士研究生领衔推出的。这就是由生数科技联合清华大学,正式开源的大一统世界模型——Motus。

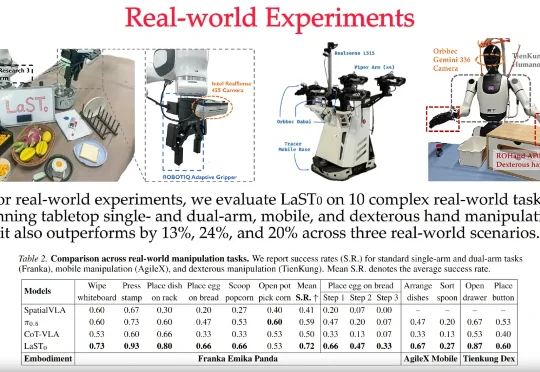

过去一年,LLM Agent几乎成为所有 AI 研究团队与工业界的共同方向。OpenAI在持续推进更强的推理与工具使用能力,Google DeepMind将推理显式建模为搜索问题,Anthropic则通过规范与自我批判提升模型可靠性。

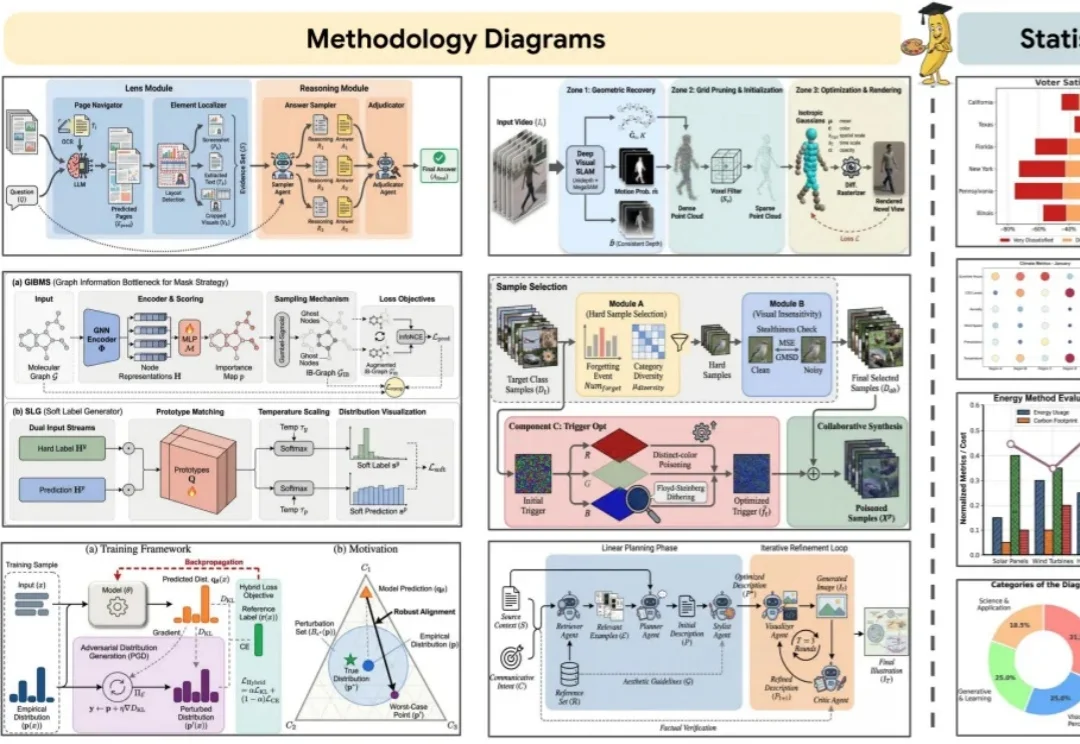

你负责写方法,AI负责画 Figure。 科研打工人,终于等来「画图解放日」。

刚刚,何恺明团队提出全新生成模型范式漂移模型(Drifting Models)。

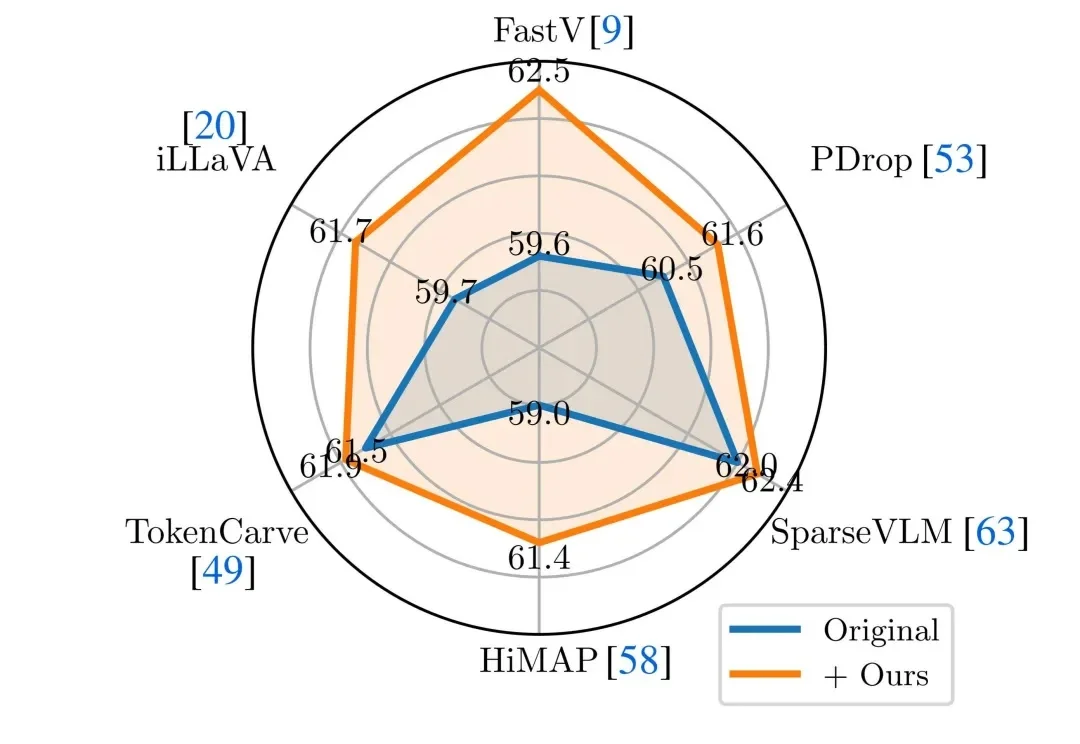

近年来,Vision-Language Models(视觉 — 语言模型)在多模态理解任务中取得了显著进展,并逐渐成为通用人工智能的重要技术路线。然而,这类模型在实际应用中往往面临推理开销大、效率受限的问题,研究者通常依赖 visual token pruning 等策略降低计算成本,其中 attention 机制被广泛视为衡量视觉信息重要性的关键依据。

扩散语言模型(Diffusion Language Models, DLLMs)因其多种潜在的特性而备受关注,如能加速的非自回归并行生成特性,能直接起草编辑的特性,能数据增强的特性。然而,其模型能力往往落后于同等规模的强力自回归(AR)模型。

开年,DeepSeek论文火遍全网,内容聚焦大模型记忆。

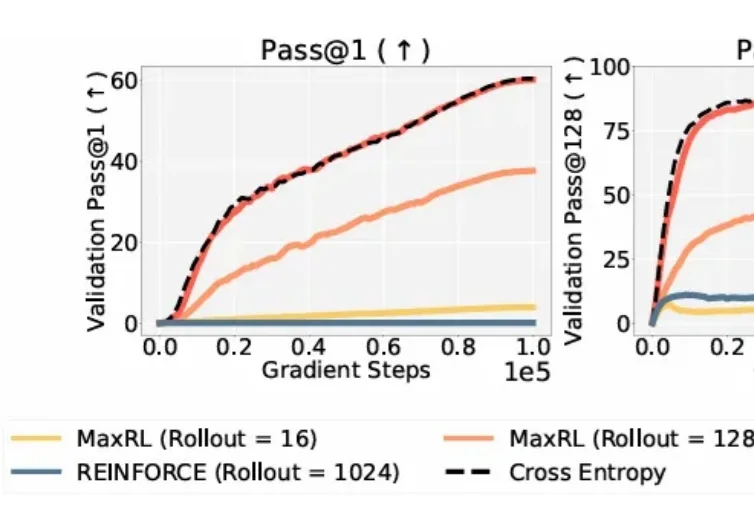

在大模型时代,从代码生成到数学推理,再到自主规划的 Agent 系统,强化学习几乎成了「最后一公里」的标准配置。

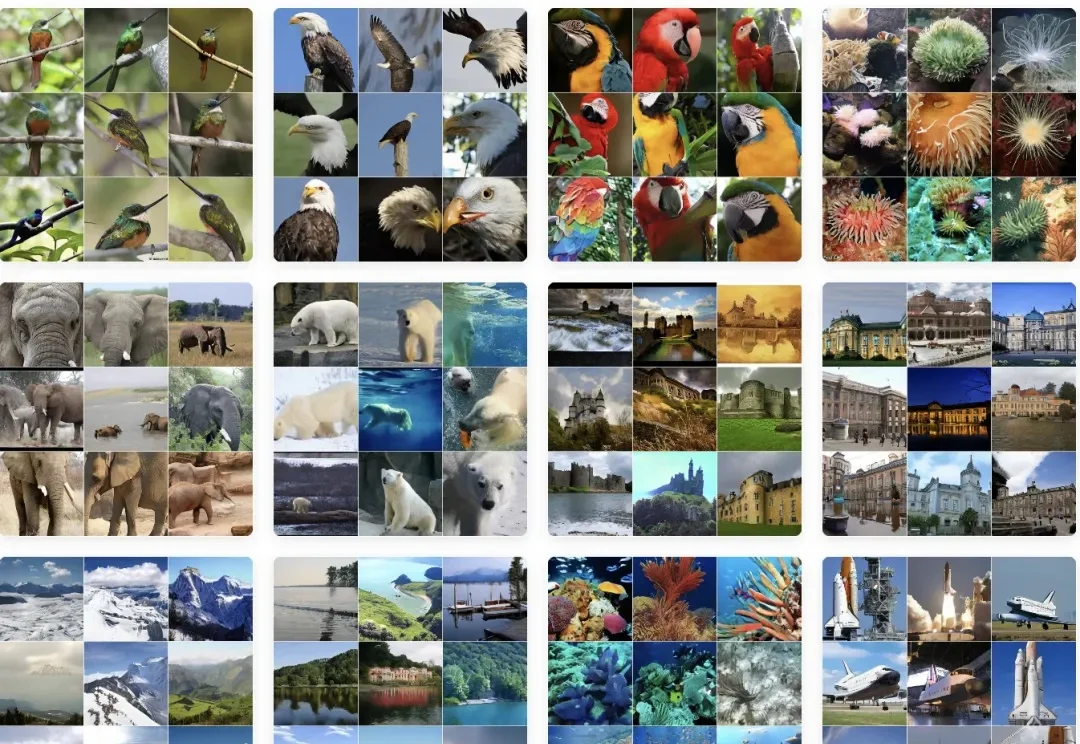

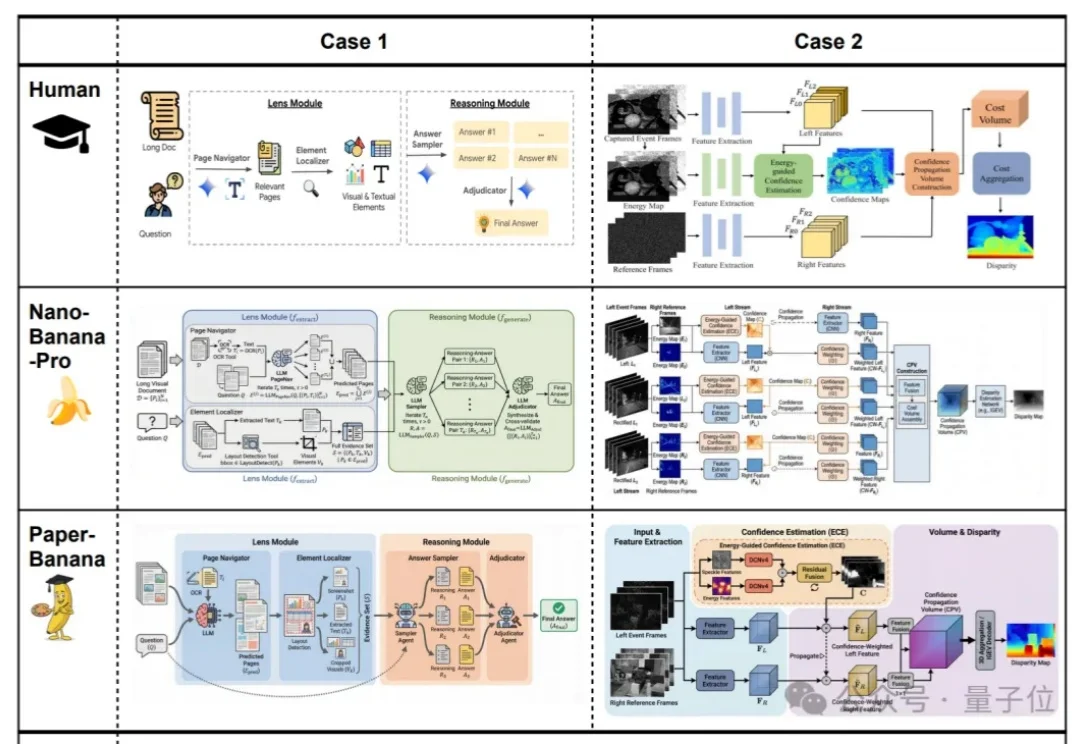

效果好到刷屏的Nano Banana,学术特供版热乎出炉!

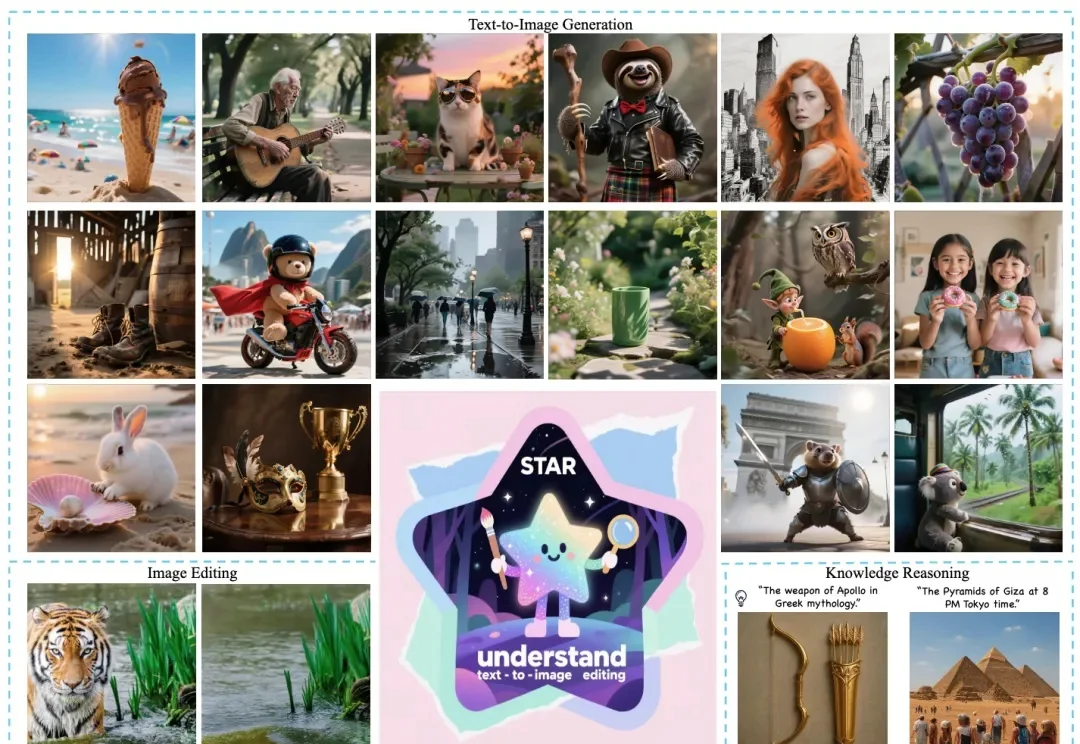

近日,美团推出全新多模态统一大模型方案 STAR(STacked AutoRegressive Scheme for Unified Multimodal Learning),凭借创新的 "堆叠自回归架构 + 任务递进训练" 双核心设计,实现了 "理解能力不打折、生成能力达顶尖" 的双重突破。

英伟达新论文让AI学会先盖房、再装修。

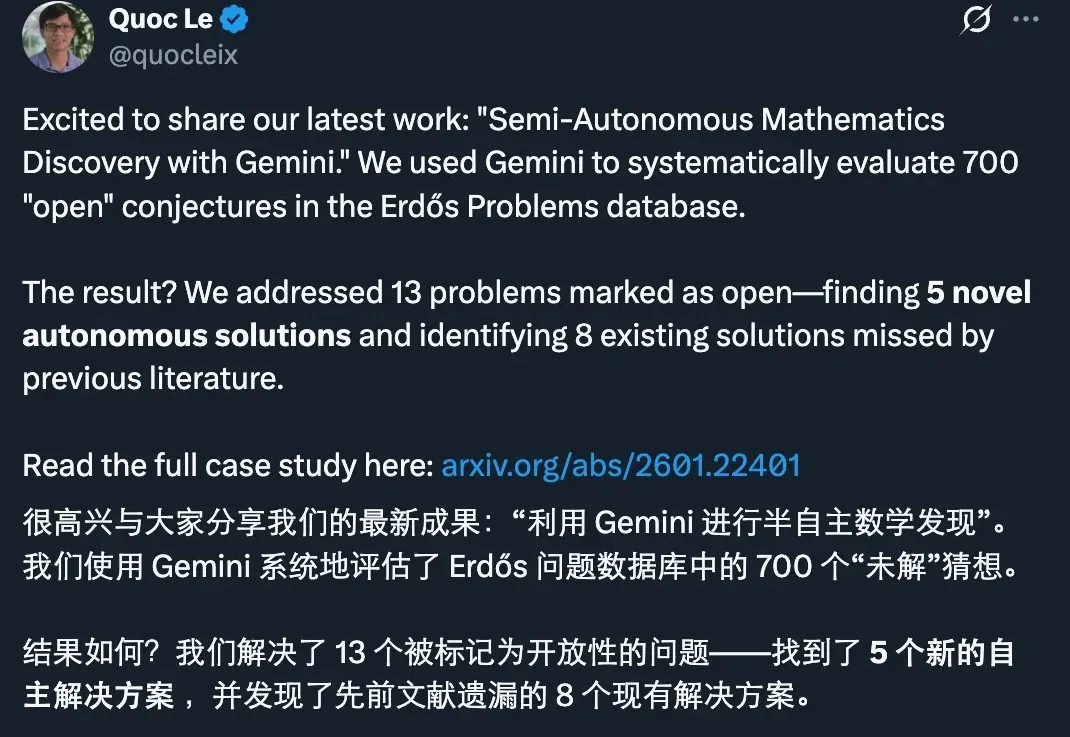

刚刚,谷歌发布了一项新的研究进展:他们用 Gemini 做了一次系统性的数学攻关实验,把目标对准了著名的 Erdős Problems 数据库里 700 个仍被标注为 open(未解决)的猜想。

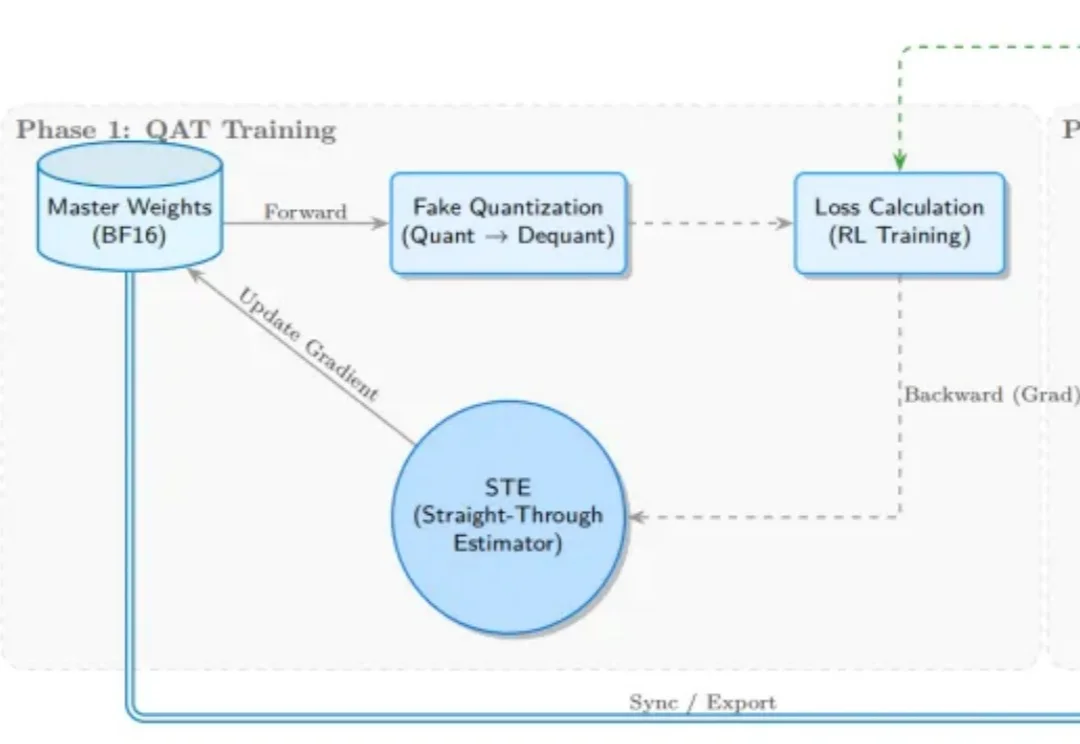

受 Kimi K2 团队启发,SGLang RL 团队成功落地了 INT4 量化感知训练(QAT) 流程方案。通过 “训练端伪量化 + 推理端真实量化(W4A16)” 的方案组合,我们实现了媲美 BF16 全精度训练的稳定性与训推一致性,

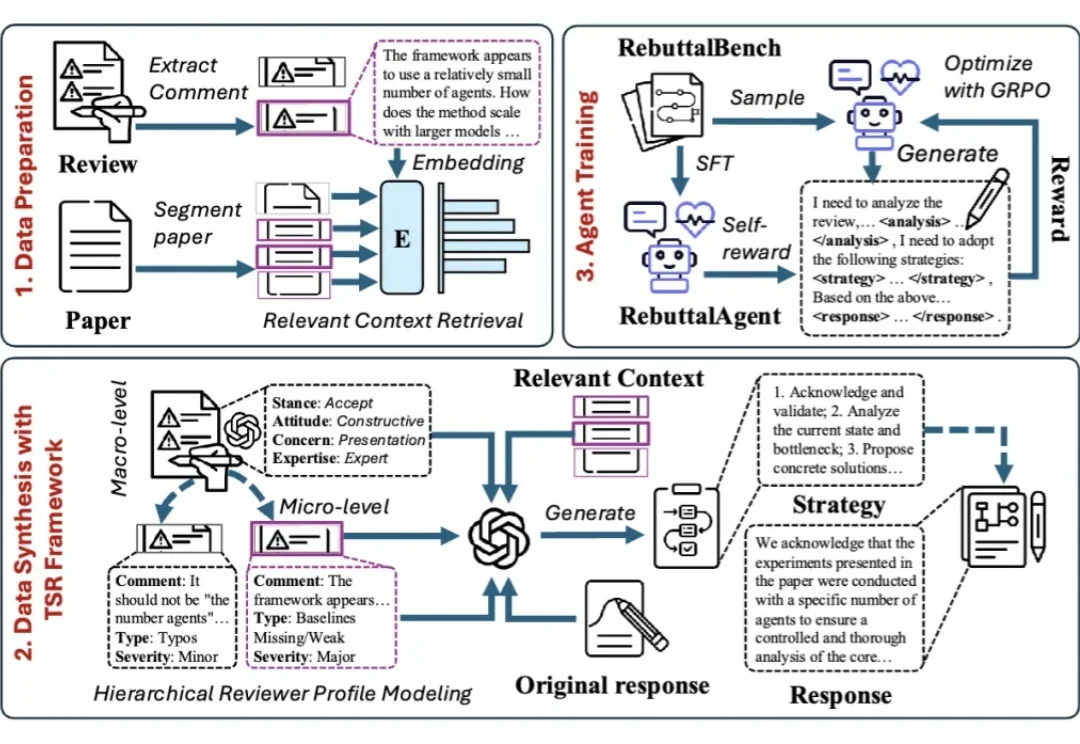

面对同行评审,许多作者都有过这样的经历:明明回答了审稿人的每一个问题,态度也足够谦卑,为什么最终还是没能打动对方?

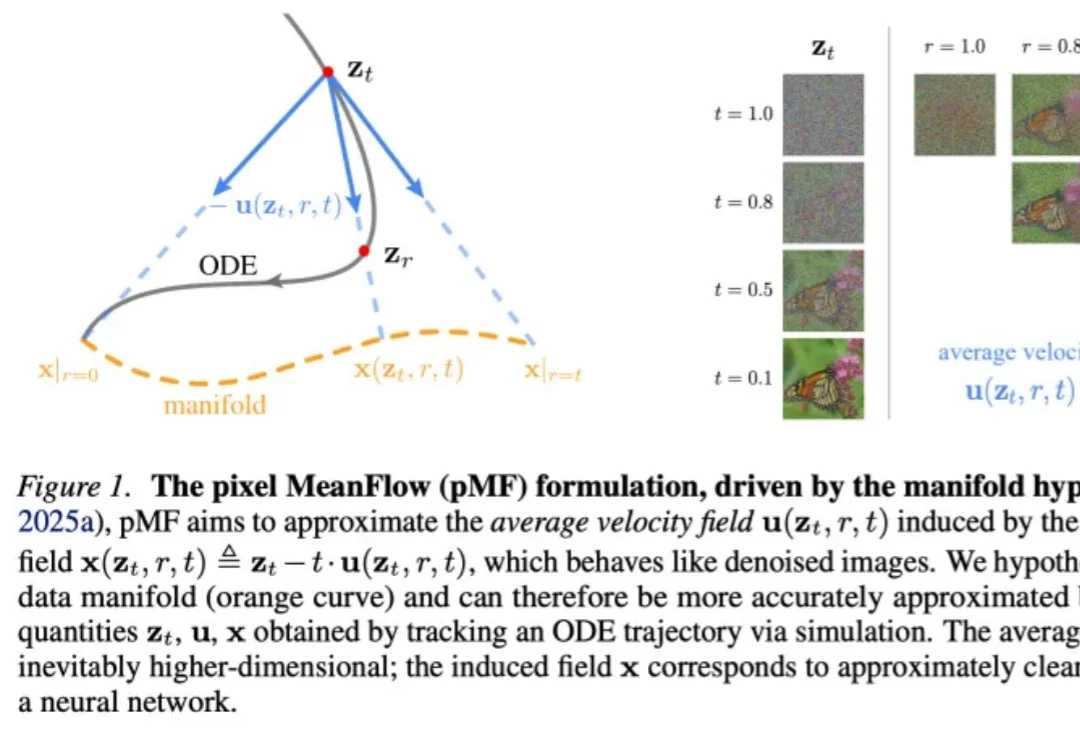

何恺明团队新论文,再次「大道至简」。

不久前在 AGI-Next 前沿峰会上,姚顺雨曾分享过一个核心观点:模型想要迈向高价值应用,核心瓶颈就在于能否「用好上下文(Context)」。

AI,是色盲吗?

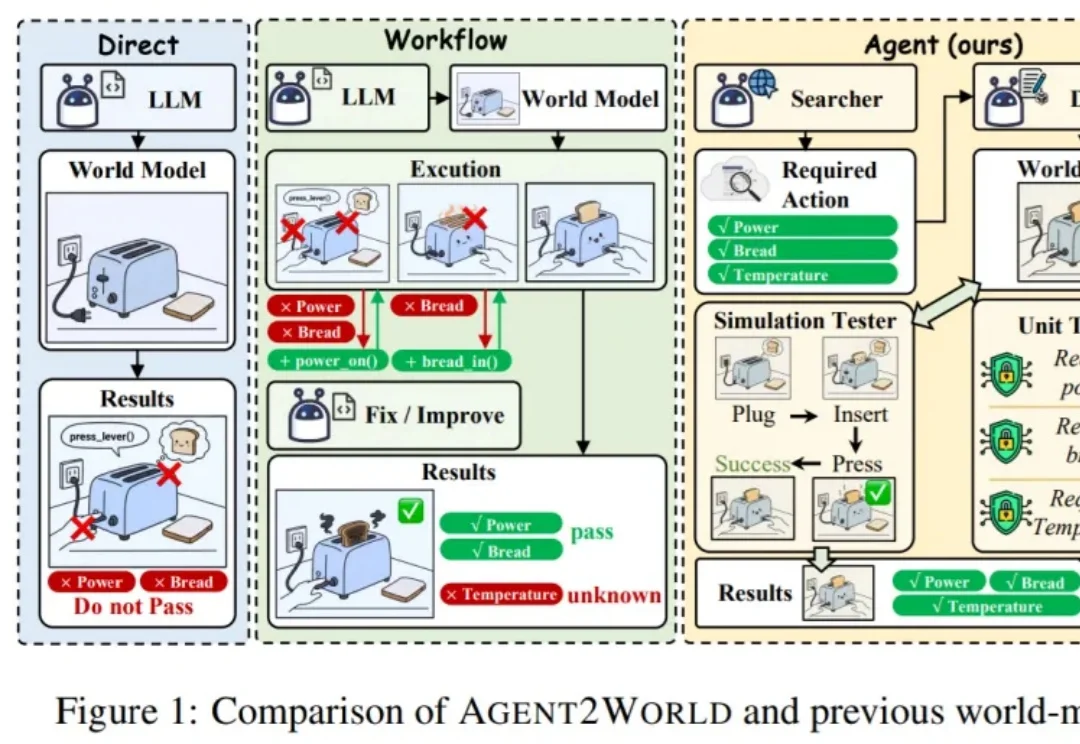

让模型真正 “能行动”,往往需要一个可执行、可验证的符号世界模型(Symbolic World Model):它不是抽象的文字描述,而是能被规划器或执行器直接调用的形式化定义 —— 例如 PDDL 领域 / 问题,或可运行的环境代码 / 模拟器。

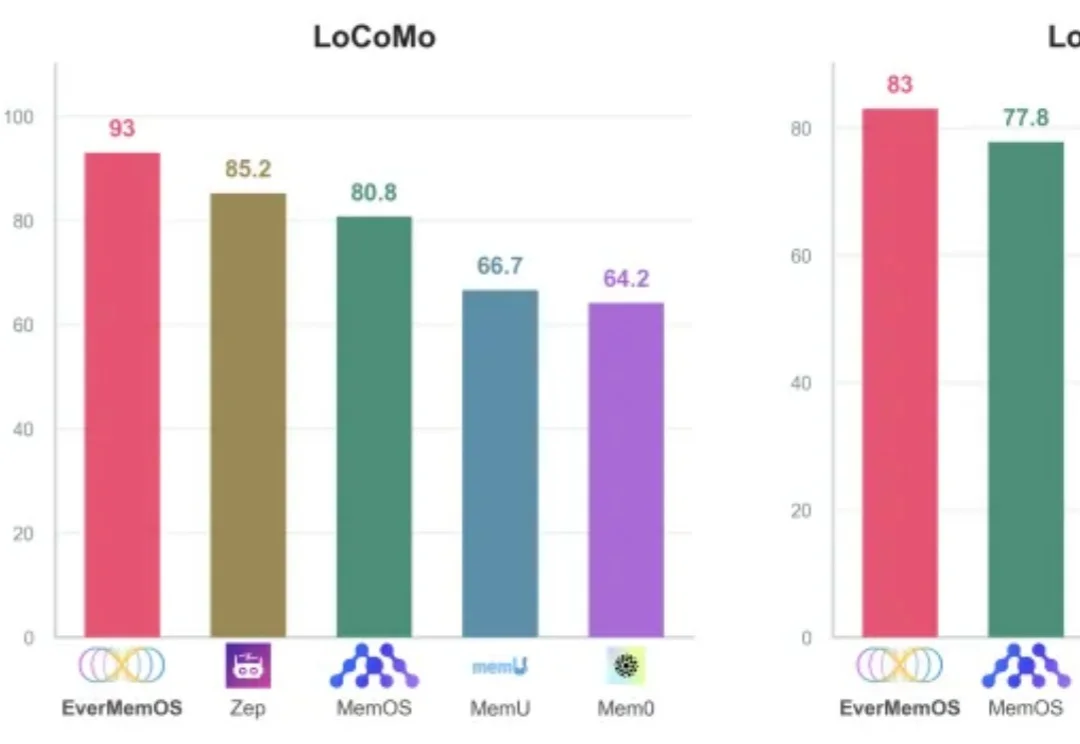

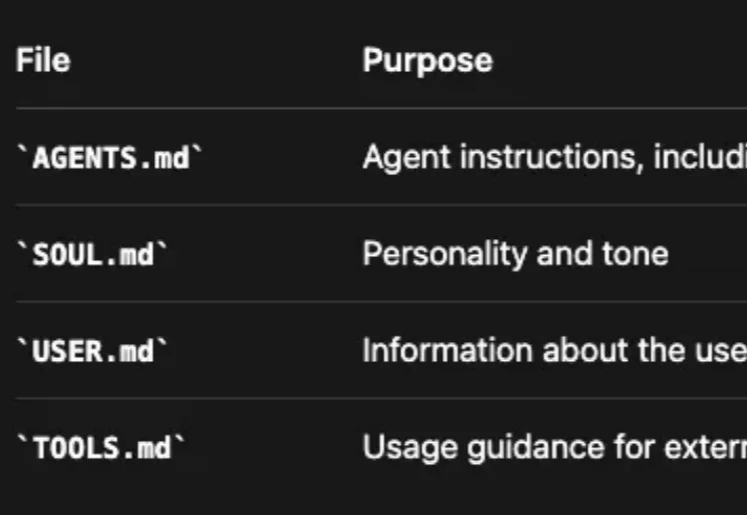

Clawdbot(现改名为 OpenClaw) 体验下来,持久的记忆管理系统很是让人惊艳——全天候保持上下文,无限期地记住对话并在此基础上持续深化互动。

何恺明,再次出手精简架构。

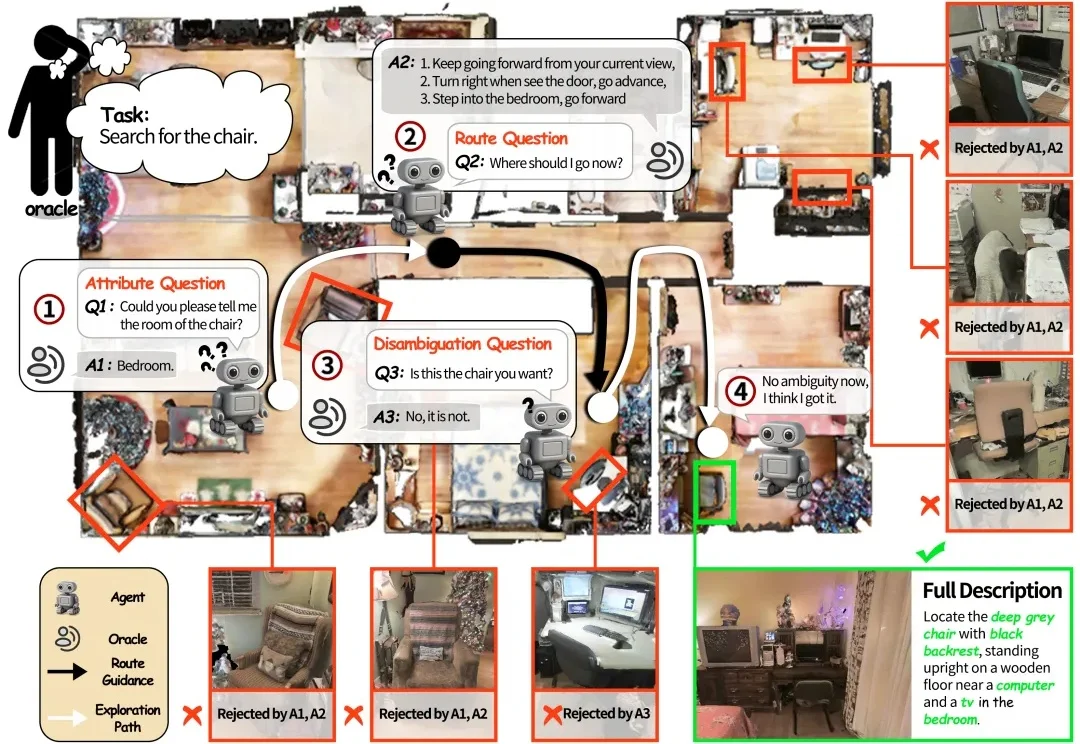

如果将一台在视觉语言导航(VLN)任务中表现优异的机器人直接搬进家庭场景,往往会遇到不少实际问题。

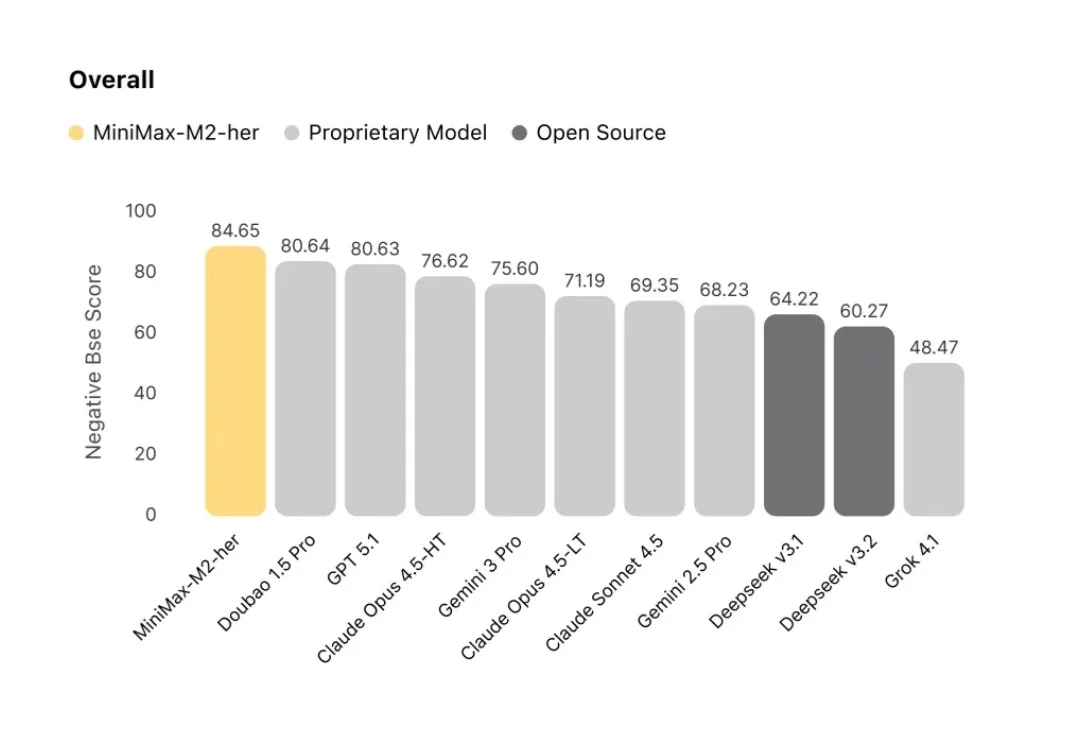

今天,我们分享 MiniMax-M2-her 背后的技术思考。M2-her 也是服务星野/Talkie的底层模型。

语析Yuxi-Know 是基于大模型RAG知识库与知识图谱技术构建的智能问答平台,支持多种知识库文件格式,如PDF、TXT、MD、Docx,支持将文件内容转换为向量存储,便于快速检索。

起因是这样的, 当我还在跟Mac Mini版满血版Clawdbot PK的时候,发现有人统计了排名前十的Clawdbot常见任务,分别是邮件处理,日历管理(日程提醒和会议安排),控制Claude Code开发,每日简报等,

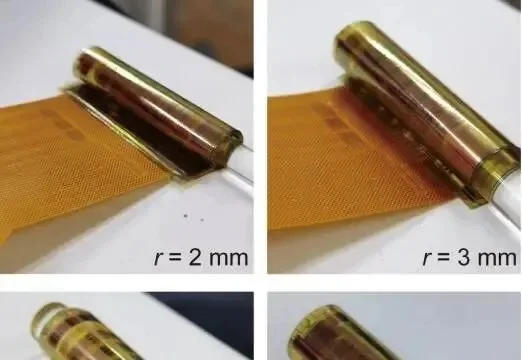

一张薄如纸片、能卷在手指上的柔性芯片(不是柔性印刷电路板,是柔性集成电路),能做什么?